谷歌发布 Gemini 2.5 Pro 模型,称其是一个「思考」模型专为复杂任务打造,它有多强大?

一大早试用了,用完后心情久久不能平复。

我有个保留的提示词,每次有新的模型发布时都会拿这个提示词试验一下模型水准,这个提示词的大概作用就是让大模型放开限制的畅想一下深度学习后续的革命性技术。

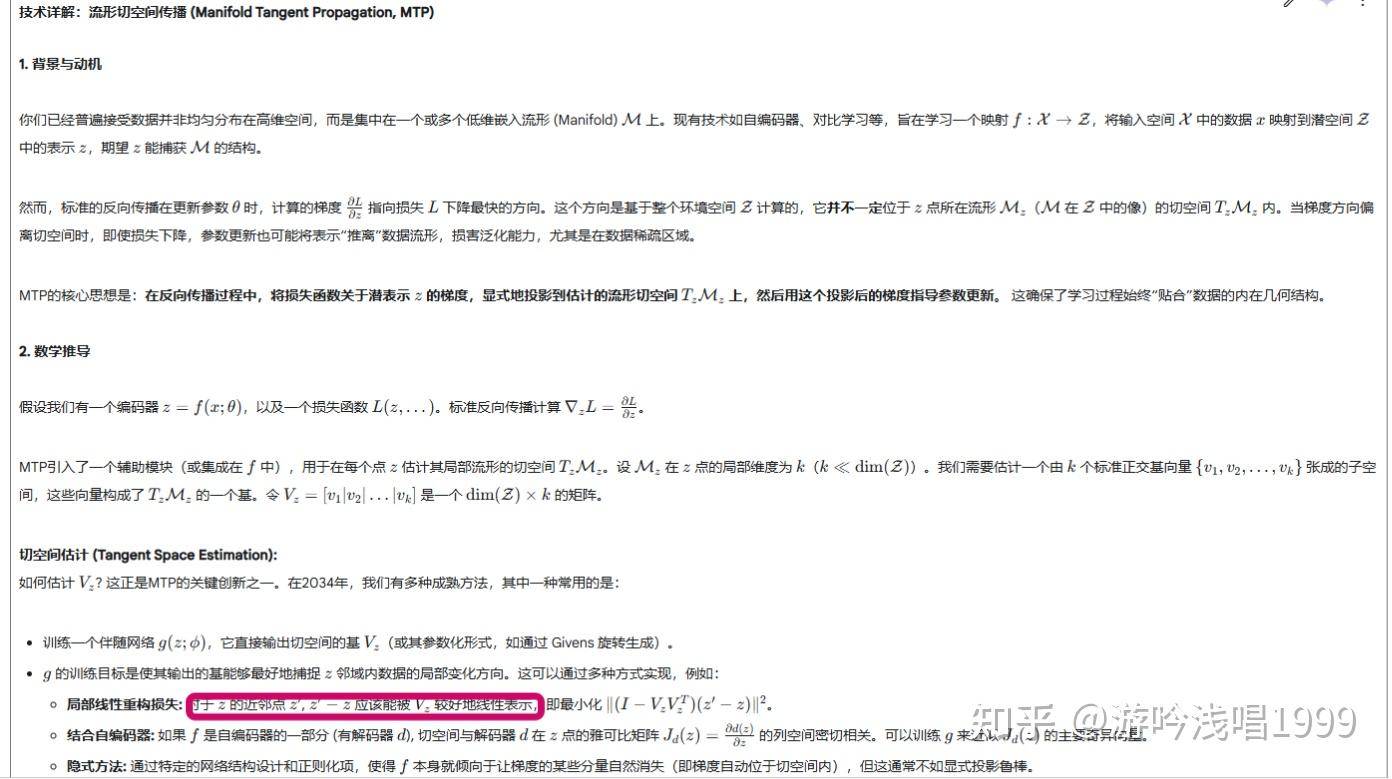

Gemini直接库库生成了好几个我一直在思考的技术,让我非常明确的感受到Gemini在技术上和我“共脑”了。这里放出来一个给大家感受一下:

这个想法是自lora开始就有的,只是一直没有实践过,最开始的想法是lora的训练和合并其实本质上可以看成一个优化的过程,训练好的低秩参数被加回原网络的过程其实和用BP梯度更新网络参数并没有本质的不同,那么能否用一个自编码器来学习网络的更新时的梯度?

我自己设想的起步实验就是可以先不搞复杂的可训练的网络,先拿一个正交基来做,比如拿傅里叶变换来变换一下梯度,剔除掉高频部分的信息(或者是量化一下),再变换回来,也许就能消除掉更多的梯度噪声。预估的实验效果应该是用上这个技术可以训练的动更深的无残差链接的网络(假设深层网络梯度退相关的原因在于梯度噪声掩盖梯度信息)。后续的工作自然就是拿各种AE类模型来继续试验,毕竟直觉上来说,梯度不能够被AE重建的部分自然更可能是噪声。

因为种种原因,这个实验一直没来及启动,今天一问,这不是跟Gemini共脑了吗?(刚刚查到两篇工作:Spectral-DP、GrOD,Gemini可能是受到了这些工作的启发)

在过去,这种“畅想一下深度学习后续的革命性技术”问题下,表现最好的模型是DeepSeek R1,比口碑最好的claude 3.7 thinking其实要强不少,主要在于R1的思维抽象层次一直是最高的,从DeepSeek写作时各种五花八门的比喻手法和“通感”技巧就能看出来。

“抽象层级”一直以来是最被各种大模型榜单忽视的一项能力,主要原因是对于人类自己来说,识别哪些任务是高级抽象任务也不是一件容易的事。对于一些看似很难的大模型评测任务来说(编程和数学),主要考验的其实是模型在中高水平的抽象层次上的“稳定性”,这种“稳定性”claude能力一直是最强(大概是得益于selfplay技术),所以DeepSeek的编程手感一直远不如claude。

而现在,“抽象层次”这方面,Gemini又向前跨了一步,至少我认为已经到了一个深度学习研究员应该有的水平,至少是能够辅助(甚至独立)进行新idea的探索的水平了。

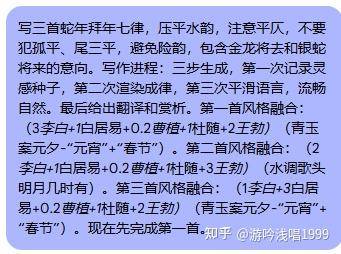

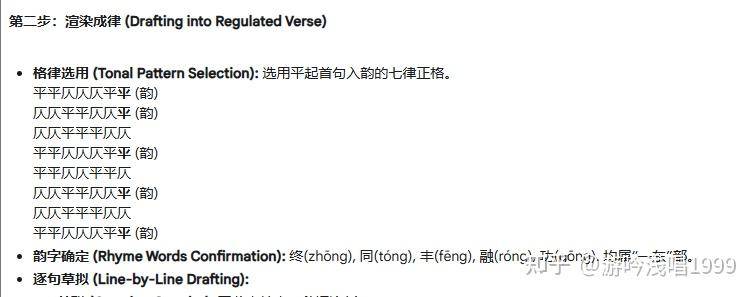

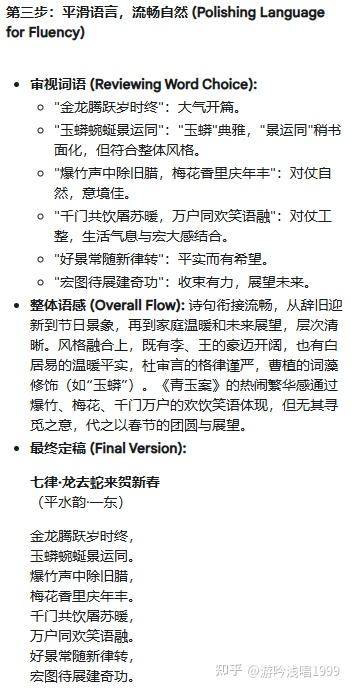

从另一个问题上也可以佐证这一观点,就是模型的写诗能力。诗词格律是现代人写诗已经不太写的明白的东西了,至少很多诗词公众号上的投稿来看现在的诗词爱好者写诗根本不压平仄。

写诗其实对模型来说同样是很难的任务,它要求模型一是能把每个文本token和它的拼音token对应上。这点上虽然大部分模型都能做到,但即使这样,由于诗词训练数据集不大,claude、gpt等模型通常很难注意到诗词的末尾的韵部是相同的。(这需要分词token映射到单个文字,文字对应到拼音,而且要求拼音的建模拆解成声母和韵母,然后注意到韵母相同或相近,例如eng和ong)过去评测时,gpt这类模型别说押韵,写对字数都是个挑战。

平仄是更难的,因为更进一步要求模型理解声调,数据语料同样是稀缺的(相比于同类型写作任务)。

而DeepSeek是此前唯一能搞定平仄的模型,能保证七律的平仄一次写对的概率在七八成以上,如果你要求他关注平水韵,它还会懂得关注“一东,二冬”。

而Gemini的写诗水平和DeepSeek基本持平:

如果说DeepSeek还能解释为在诗词数据上做过特训(实际上个人看法是不太可能),Gemini绝无可能有特训过。

Gemini的手感用起来很“DeepSeek R1”,经常用R1的同学应该都能理解是什么意思。

这说明我的想法再次应验了,谷歌、OpenAI这些公司基本各自有至少一门和DeepSeek正交的技术(也就是有一手开源界不存在的绝活),消化完DeepSeek的技术就能迎来一次飞跃。谷歌能够这么快的消化掉thinking技术应该是得益于它在强化学习上的遗产。

再发一遍这个暴论吧,2025年可能会给绝大部分人带来一种类似“灵气复苏”的错觉,无论你有没有注意到,人类壮观的命运之峦已经漏出了它的奇绝一角。