DeepSeek本地部署之后,都用来干什么?

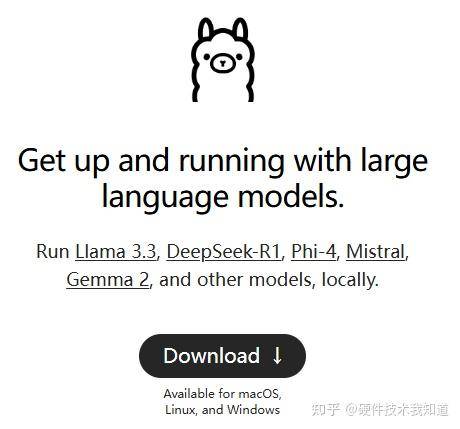

第一阶段:下载并安装Ollama

1, 打开浏览器,进入 https://ollama.com 官方网站

2, 点击“Download”,在新页面选择“Windows”,再点击“Download for Windows”。

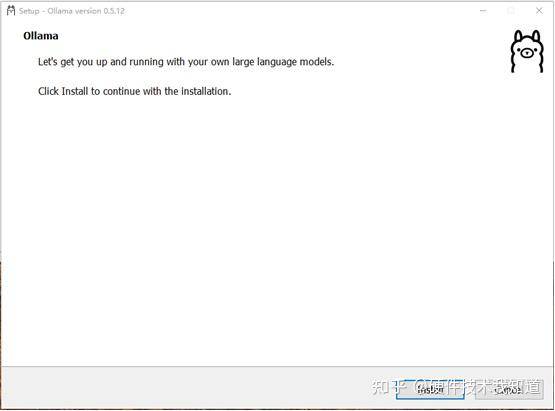

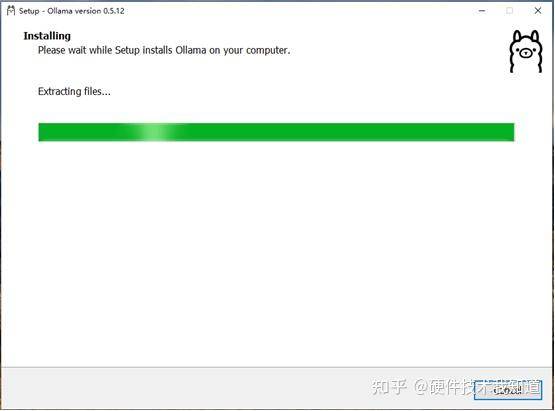

3, 下载完成后,在文件名(OllamaSetup.exe)点击鼠标右键,选择“以管理员身份运行”。

4, 点击“Install”开始安装。安装完成后,软件没有任何提示,但在启动菜单中可以看到。

第二阶段:安装Deepseek-R1大模型

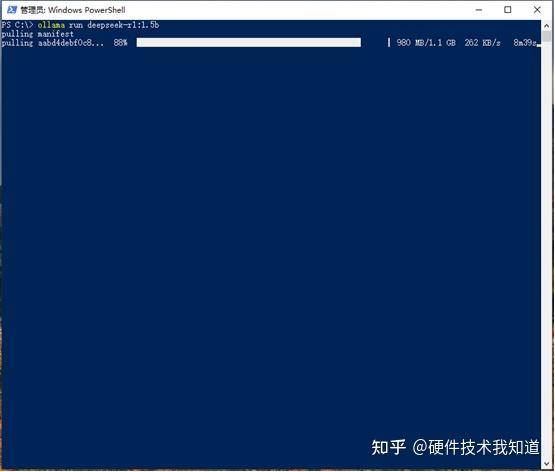

5, 在“Windows开始”图标上按右键,在弹出菜单上点击“Windows PowerShell(管理员)”或“命令提示符(管理员)”(因WIN10版本不同而不同,我用的企业版是PS)。在打开的窗口输入命令 ollama run deepseek-r1:1.5b

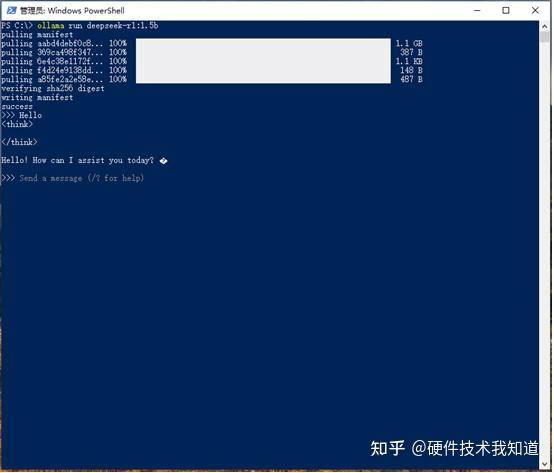

6, 安装完成后,会显示“success”。随后出现对话提示“>>> Send a message (/? For help”

这个时候就可以输出你的问题,它会给你相应的答案。如下图所示。

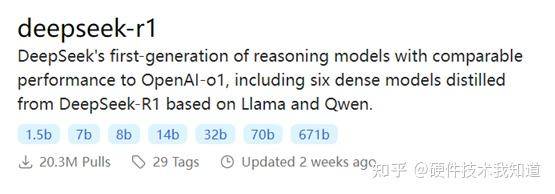

7, Deepseek-r1有多个版本,1.5b是最小的版本,大家可以根据自己的硬件配置选择更大能力更强的模型。如下图所示。

第三阶段:安装客户端GUI界面(可以不用)

8, 打开浏览器,进入ChatBox官网 https://chatboxai.app

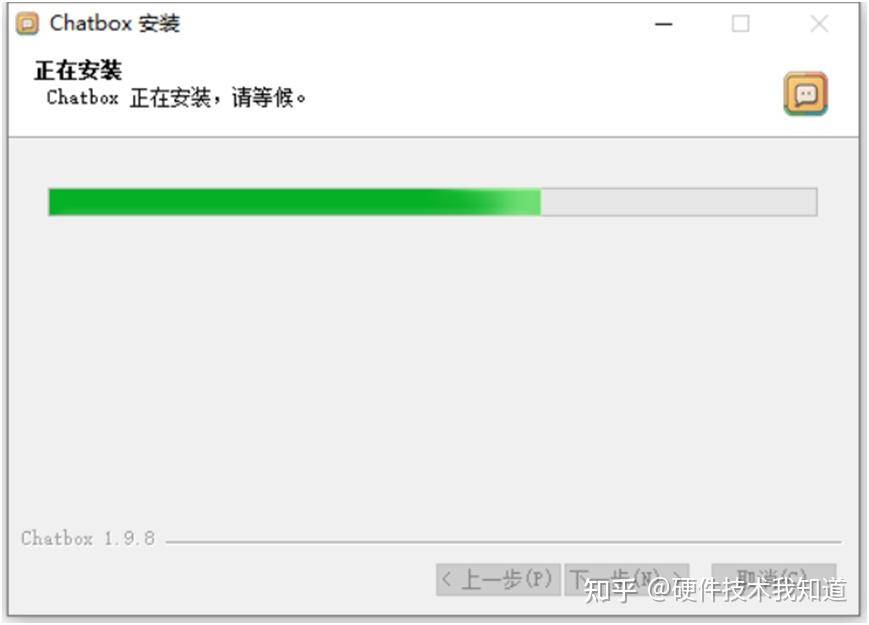

9, 点击“免费下载(for Windows)”,下载完成后,以管理员身份运行。

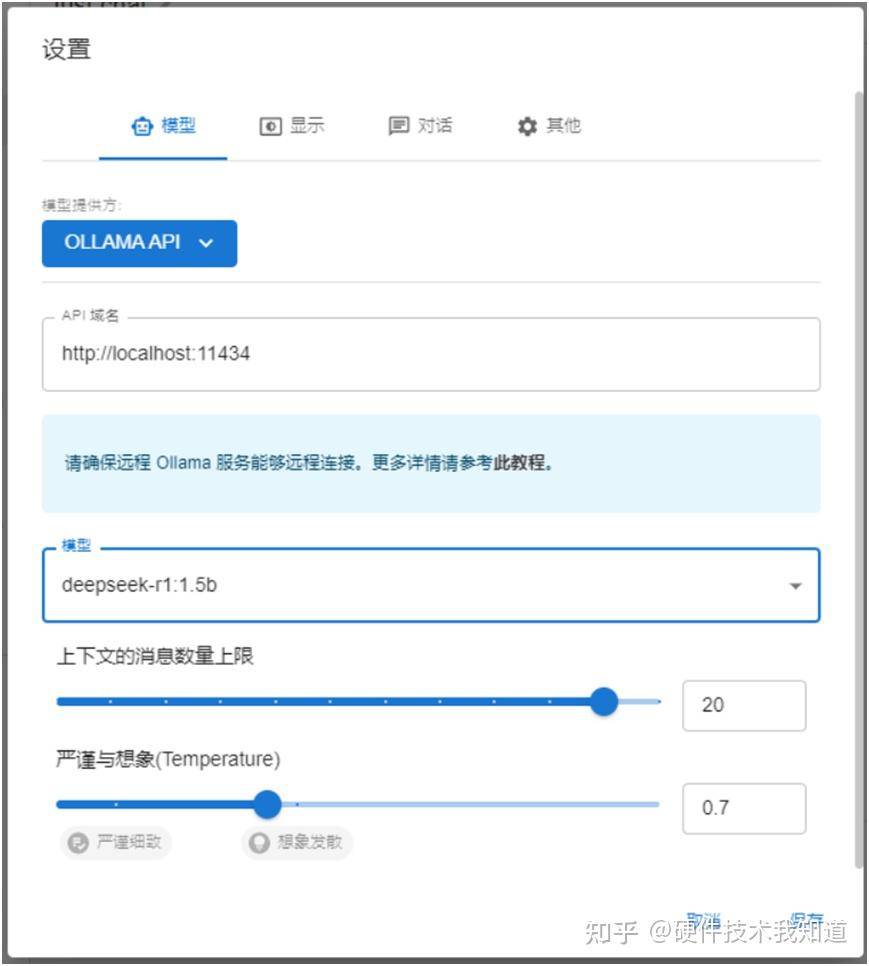

10, 在第一个界面,随便选,最终还是要看第二个界面的设置。如下图

11, “模型提供方”请选择“OLLAMA API”,“模型”请选择“deepseek-r1:1.5”(根据你安装和运行的模型来选择),“API域名”那里,点“重置”就会出现本地域名,选用本地模型。其他的可以不改。最后点“保存”

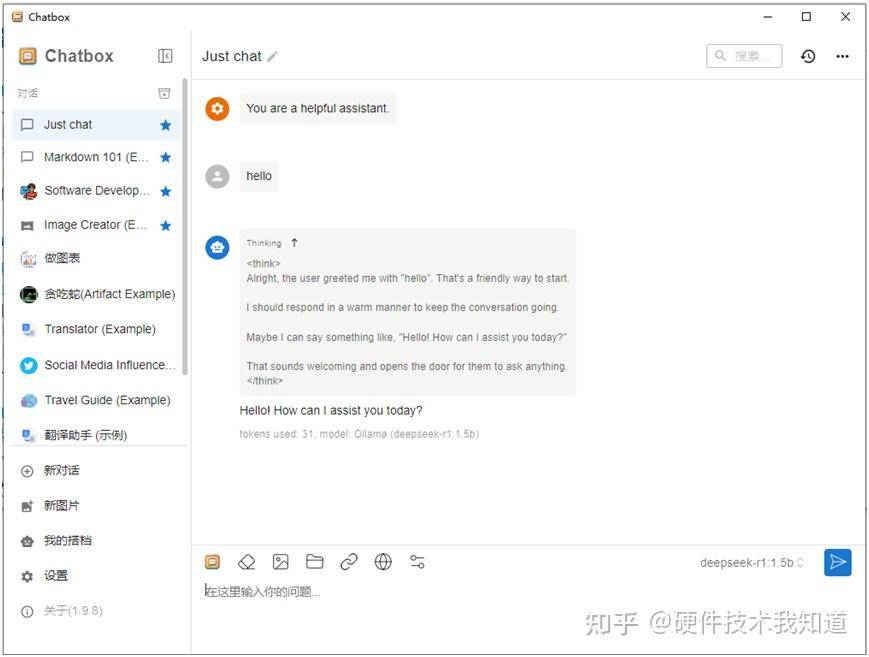

12, 到这里你就可以开始和Deepseek-r1大模型对话了。

推荐文章:

《工业计算机硬件技术支持手册》简介

用BIOS状态码(Checkpoint)及Beep声诊断计算机启动过程中的问题

DVI转HDMI和HDMI转DVI的电路设计

如何让mSATA和mini-PCIe co-lay?

英特尔性能混合体系结构