大学生学习深度学习,有必要桌面端4090显卡吗,?

4090没必要,但是本地有一张大一点显存大的卡是有意义的,主要是可视化和硬件完全在自己的控制下。

我推荐是配一台洋垃圾服务器装Ubuntu,度过前期的学习,顺便培养一下你的动手能力。

配置如下

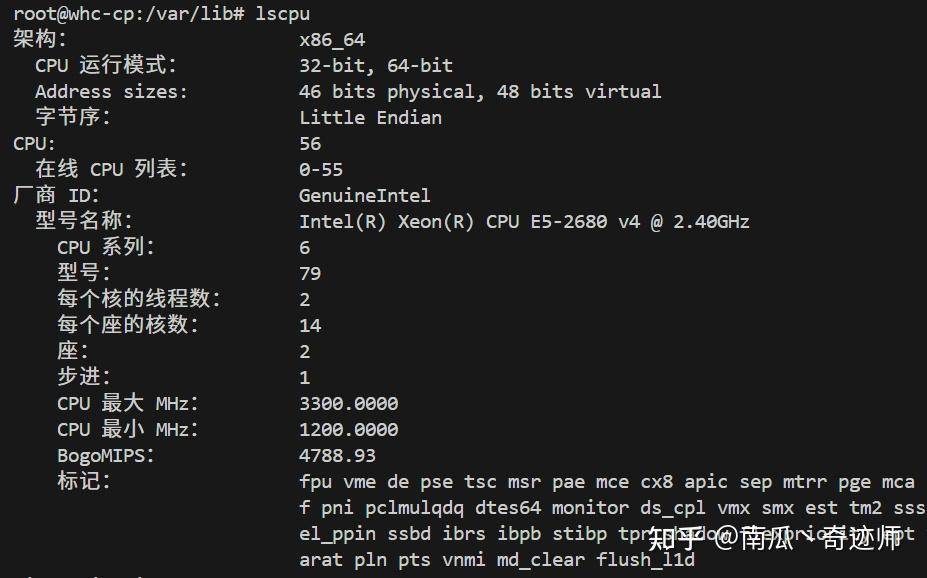

CPU:E5 2680V4 14核心28线程,70块钱一个,来两个共140元

内存:16G DDR4,110块钱一条;看你需求,一般8条共128G,880元。

主板:精粤or其他牌子的双路X99服务器,300~500元不等。

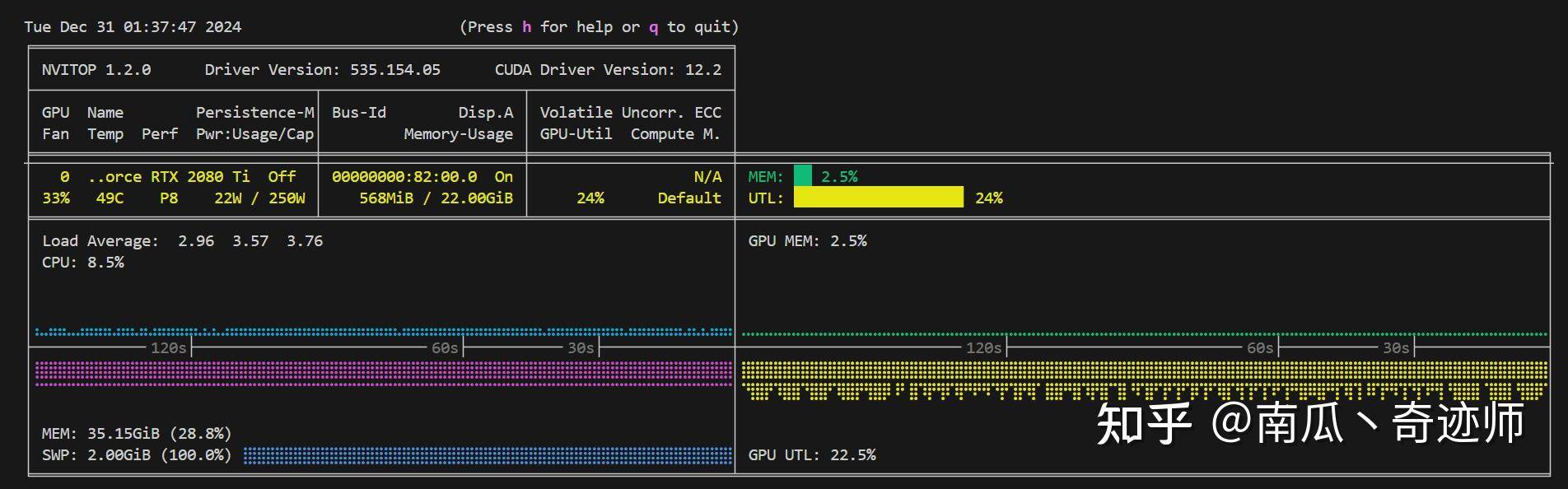

显卡:RTX 2080Ti 22G魔改版,店保一年,2600元(最好是涡轮卡,贵一些2700吧)

系统盘:1TB 梵想随便啥型号(全新pdd,350元)or PM9A1(三星980Pro的OEM版本,二手270元)

数据盘:看预算你自己搞吧。

电源:750W全新鑫谷,340元

散热器、机箱、线缆:拢共算个300吧

不算数据盘,全部加起来5000出头,这配置,基本上够用了。

既能再插一张2080ti 22G组NVLink,也能换3090用安培架构(如果有钱直接上2张3090组nvlink)。电源记得用大一些的。

组NVLink还有几个好处是,你可以学习如何写、调试多卡程序,感受卡间通讯对训练的影响。而且双卡44G显存(模型并行的方式运行),能推理更多更大的LLM。

你问我稳不稳?这服务器用了1年9个月没出问题,已经帮我跑了2篇A会的部分实验了,就算报废都赚了(还是得买涡轮卡)

这也是我个人的配置: