在CV界,传统卷积已经彻底输给Transformer了吗?

感觉很多答案都回答得很好了。

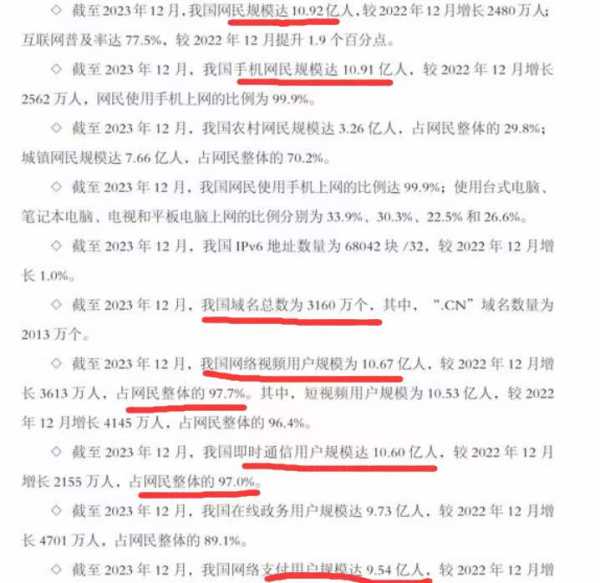

我就只说一点,经过在 Kaggle 上实践十几个数据集之后,我得到的结论是 ViT 系模型全都是“近视眼”。

(ViT 系模型: Vision Transformer 系列模型总称,包括 vit, swin, cait, deit, xcit, deit 等等)

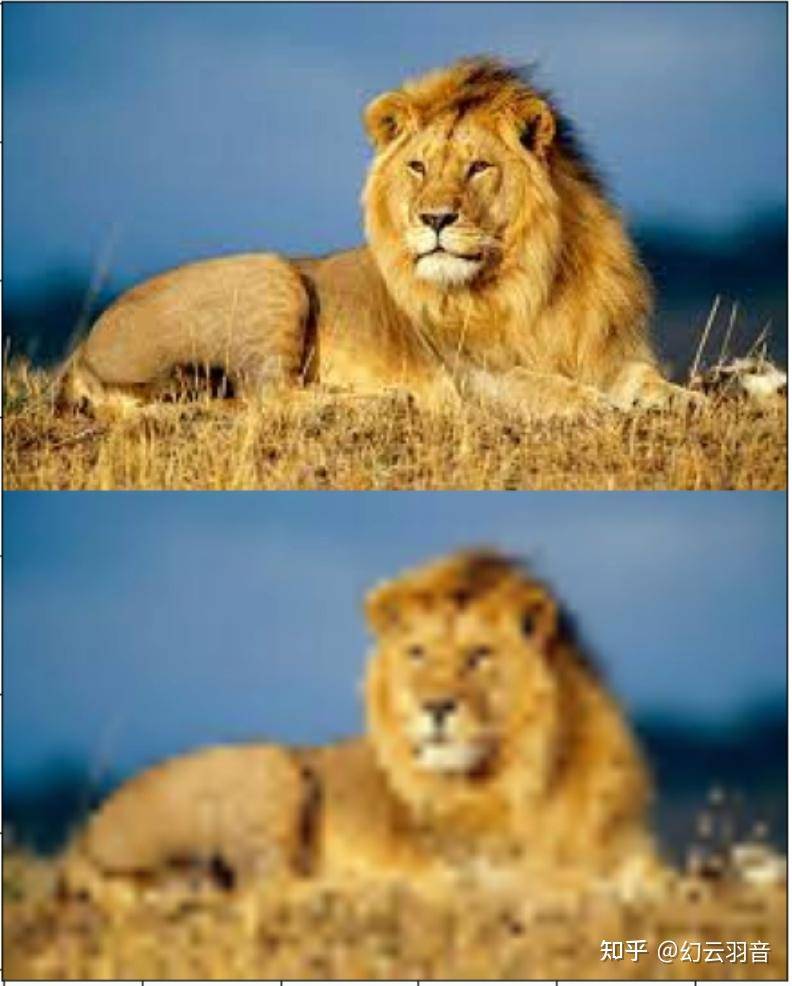

比如说像下图这样的,哪怕你有近视眼,还是能分辨出狮子是狮子。

而 CV 科研界圣杯 ImageNet 里全是这样的图片,因此 ViT 系模型能大显身手。

在 Kaggle 里的类 ImageNet 数据的比赛中 ViT 确实能占一席之地,和 CNN 分庭抗礼 (并不是一边倒)。

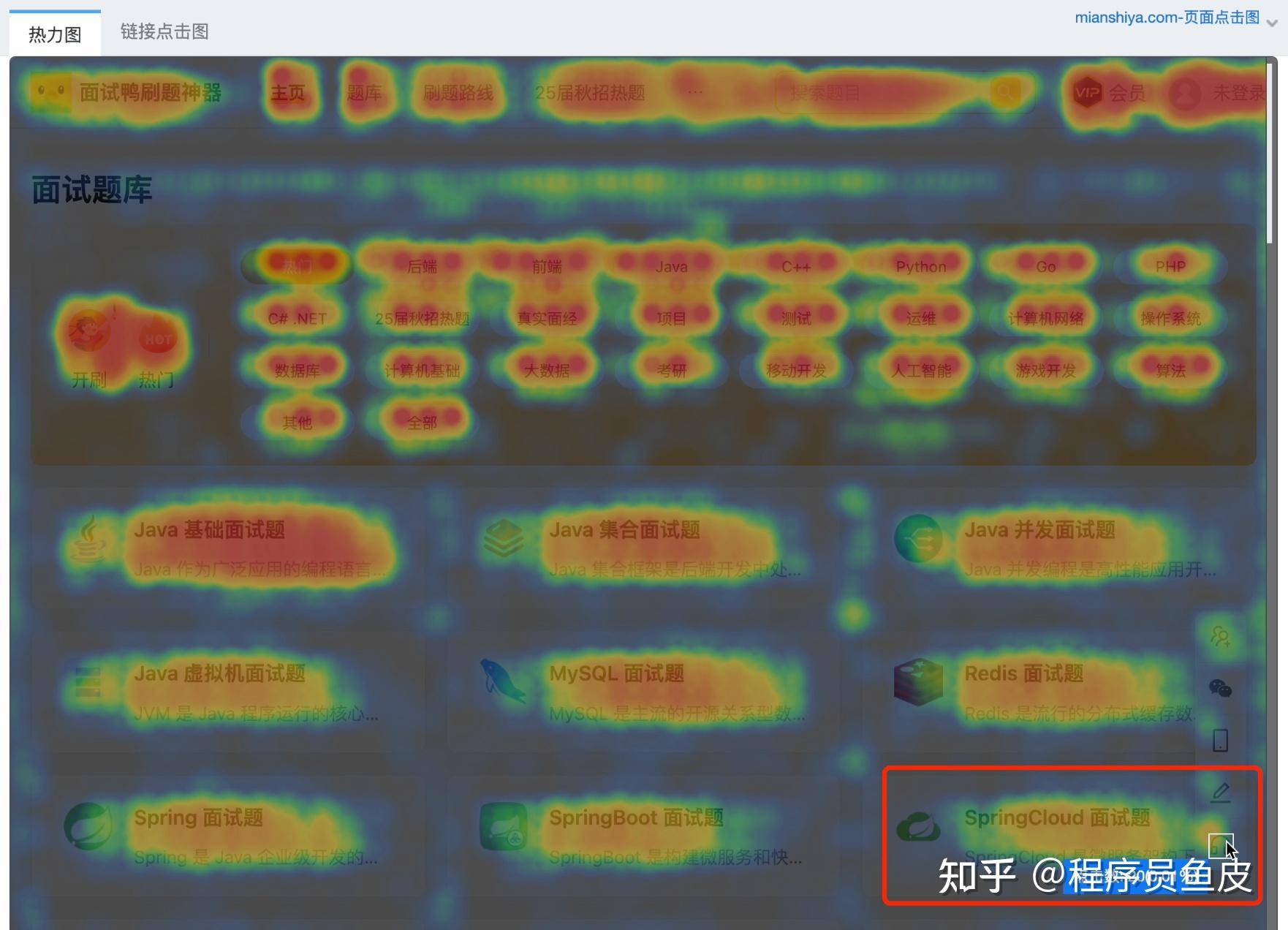

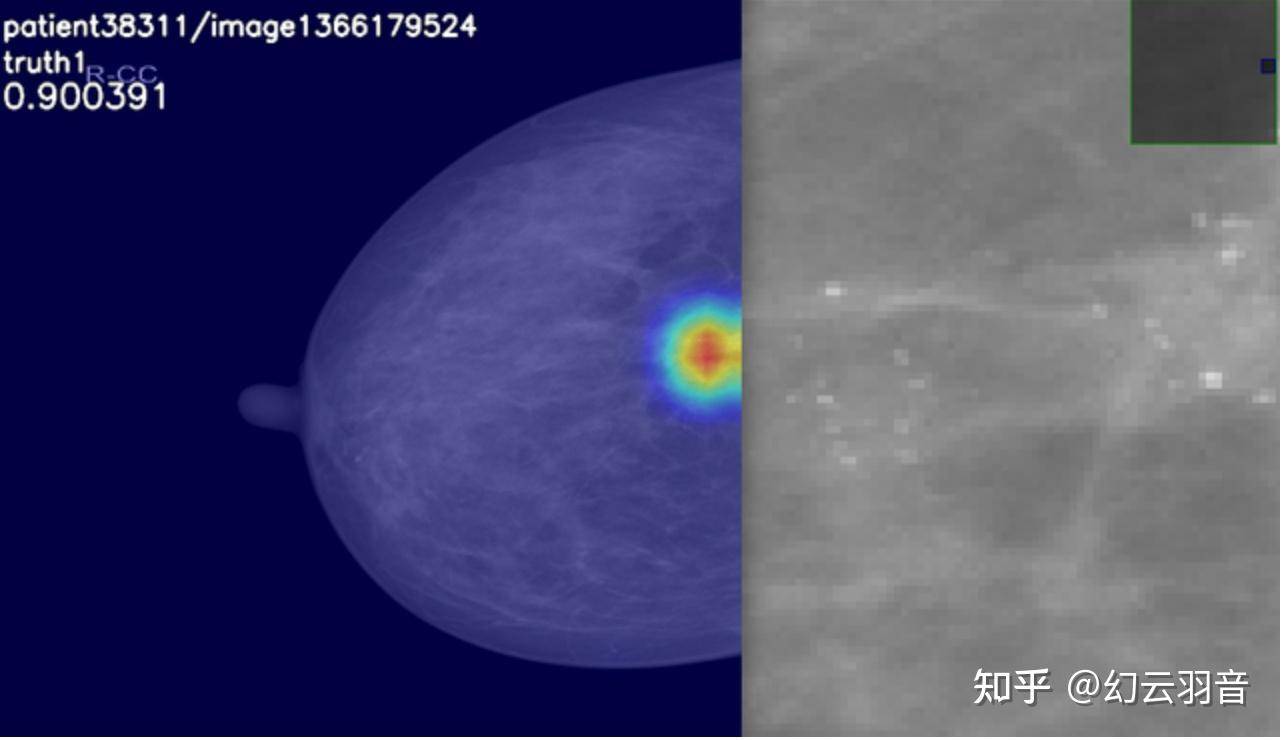

但如果换成这样的图片,要在几千x几千像素的图片里分辨出这种像素级别的细节,那就不是 ViT 系模型的强项了,甚至在某些个数据集上基本无法正常收敛。

可以去看 Kaggle 上近两年的医疗图像比赛,金牌区基本看不到用 ViT 系模型的,清一色 CNN。