MiniMax 最近开源的 MiniMax-01 系列,有哪些值得关注的点?

谢邀。

咱们开门见山先抛结论,个人认为MiniMax这个全⾃研的模型架构开源,一定程度上挑战了Transformer架构一直以来的霸主地位。

模型技术架构创新

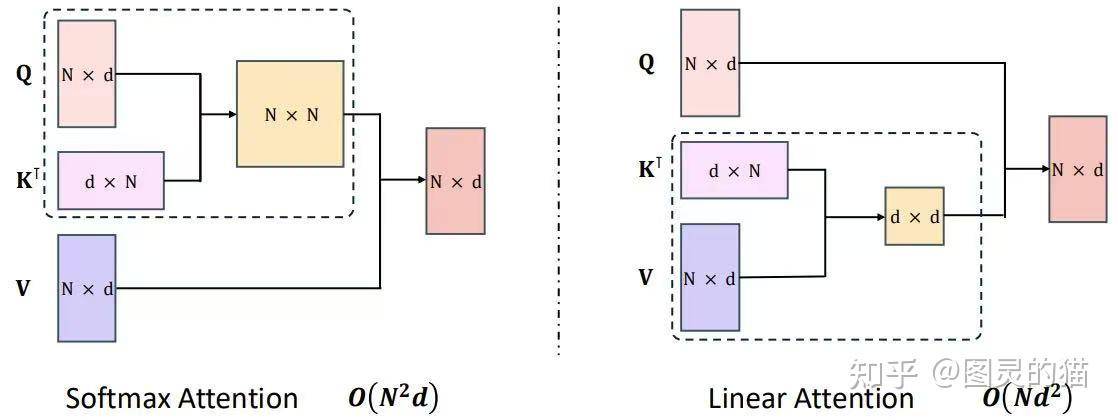

目前,国内外主流大模型几乎都基于 Transformer 架构,其最显著的特点是注意力机制。注意力机制能够自适应不同长度的上下文,在处理序列数据时展现出强大的建模能力。然而,注意力计算的复杂度与序列长度呈平方关系,这导致在处理长序列数据时显存占用和算力需求显著增加。

如果在推理阶段希望上下文长度扩展 32 倍,那么训练阶段也需要支持相应长度的上下文。这种扩展会使注意力计算量和显存占用增长到原来的 1024 倍,带来指数级的资源消耗。这不仅严重拖慢模型的训练和推理速度,还对算力资源提出了更高的要求,成为限制模型上下文长度进一步扩展的主要瓶颈。

在保证效果的前提下,如果能够优化注意力机制的二次方复杂度,将其降至线性复杂度,将极大推动大模型的发展。2023 年 5 月,Mamba 架构针对这一问题进行了探索。通过基于状态空间模型的递归公式,Mamba 将注意力计算的复杂度从二次方成功降低为线性。然而,由于其并行化支持较弱、通用性不足,以及在多模态任务中的适配性较差,Mamba 尚未能在大语言模型领域得到广泛应用或显著突破。

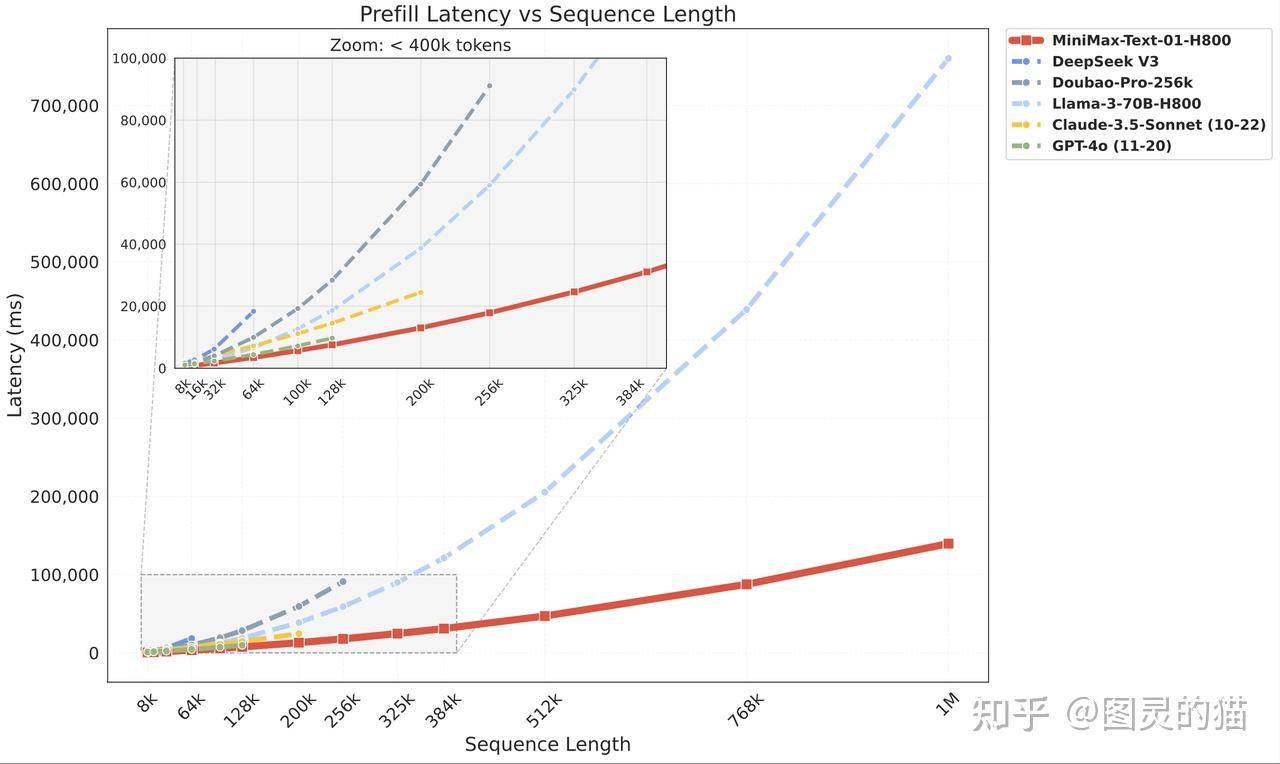

去年8月,我就有观察到MiniMax研发的新一代 MOE+ Linear Attention 模型技术发布。这个架构能够高效训练海量的数据,实用性和响应速度都有不小提升,大幅减少了大模型的训练和推理成本。相比于通用Transformer架构,在128K的序列长度下,这个新架构成本减少90%以上,而且序列长度越长,优势越明显。

如今,我们可以看到MiniMax完成了行业首个成功的大规模Linear Attention实现,这个创新让大模型推理速度更快、成本更低,也是解决无限长度输入和无限长度输出的关键一步。

简单来说,Linear Attention就是通过把Transformer 中的计算左乘找到一个右乘的近似,把传统模型架构中输入长度和计算复杂度之间平方增长的关系,变成线性的关系。通过使用Linear Attention,原生Transformer 的计算复杂度可从二次复杂度大幅下降到线性复杂度。

在我看来, Linear Attention也有助于构建更加轻量化的模型,减少模型的参数数量和计算量,使模型更易于部署和应用在资源受限的设备上,比如说像手机这样的移动设备、嵌入式设备等等,这都是未来的趋势。

模型效果表现

讲完架构创新,可能有人会觉得有点空,那咱们就来看看模型具体表现,就知道是否真的有这么高的含金量。

- 超长上下文输入

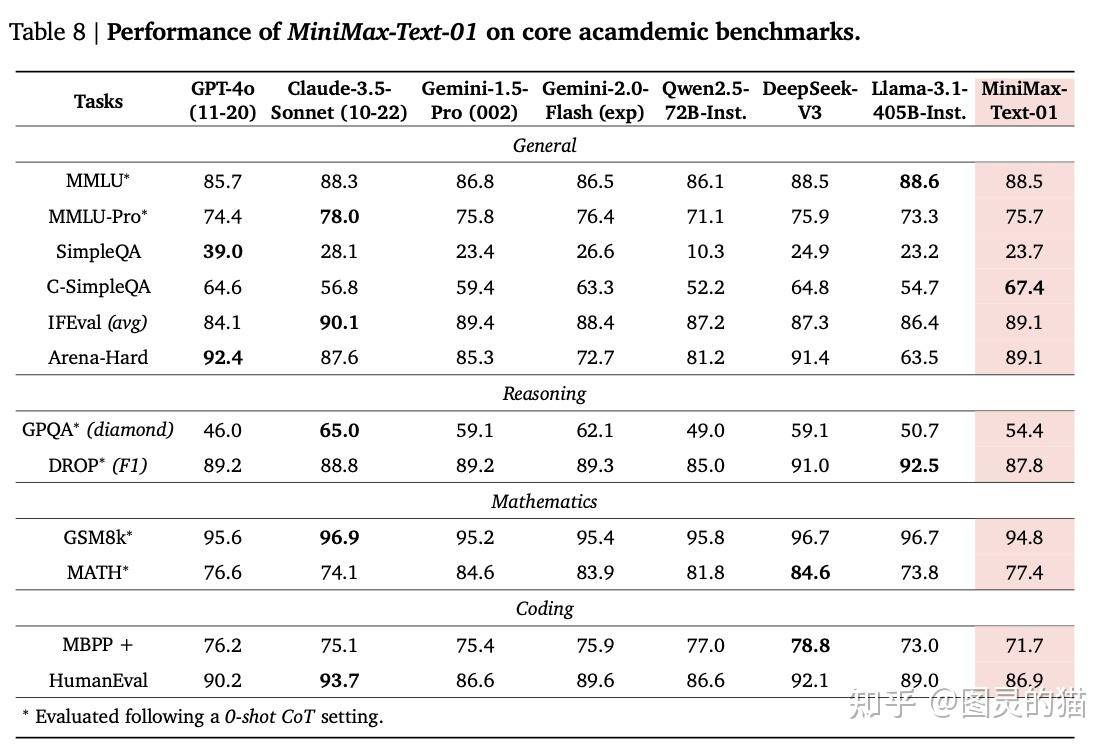

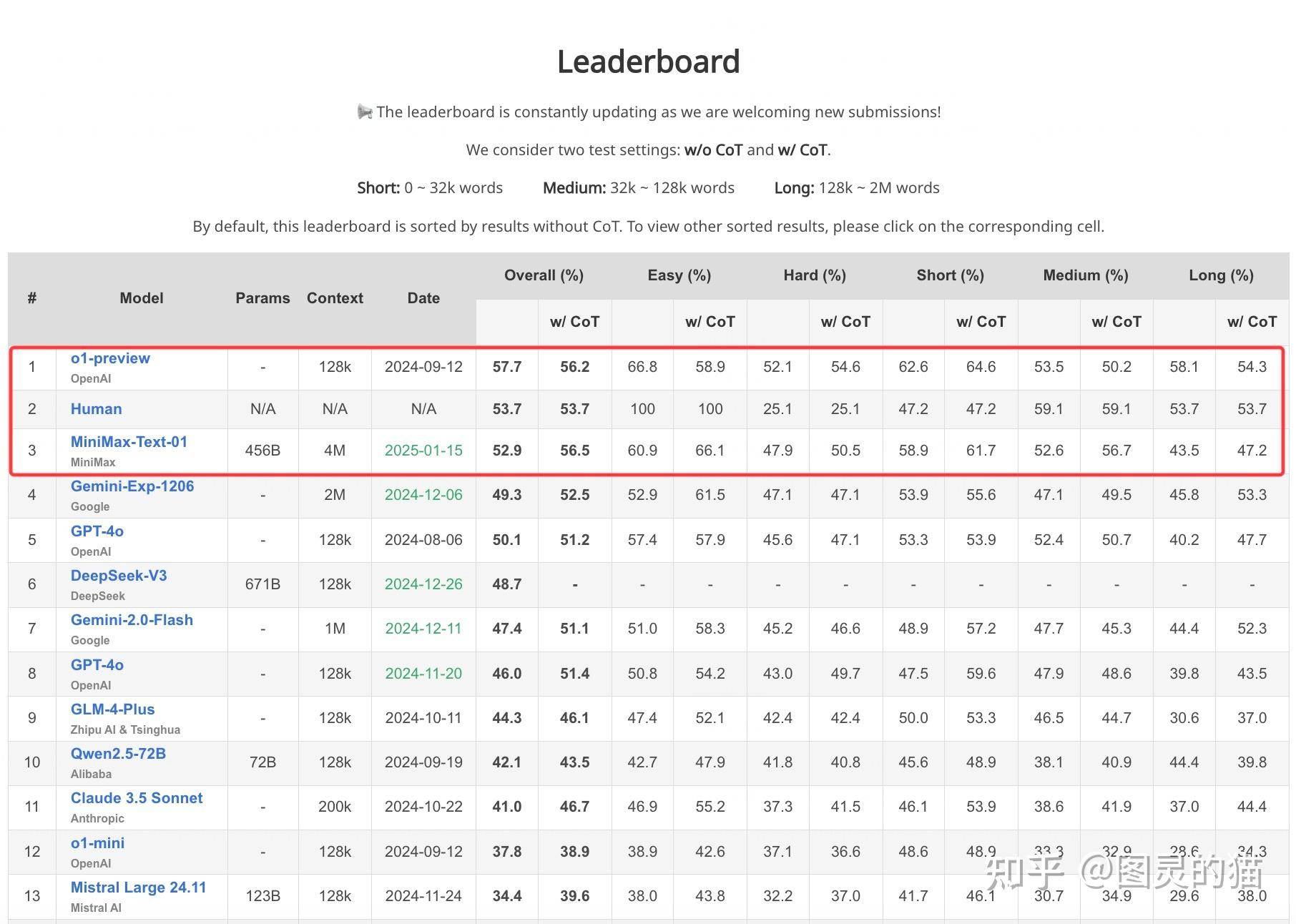

话不多说直接看成绩对比吧。在标准的学术测试集上,我们可以看到MiniMax-Text-01 基本上能媲美GPT-4o、Claude 3.5 Sonnet 等闭源模型以及 Qwen2.5、DeepSeek v3、Llama 3.1 这些 SOTA 开源模型。

- 长上下文理解

在长上下文理解上,相比于其他模型,MiniMax-Text-01的表现也比较领先。在长上下文理解任务上,MiniMax 给到了大家Ruler 和 LongBench v2 这两个常见基准。

举个例子,在 RULER这一基准上(英伟达发布的一个大模型长文本的评估基准,包含检索、多跳追踪、聚合、问答四大类共13项任务。),我们可以看到发现当上下文长度超过 128k 时,到后面256k、512k乃至1M时,MiniMax-Text-01 的模型架构优势就愈发明显,可以一起看下第三方的最新评测数据。

传统大模型在处理长文本任务时,随着输入长度的增加,通常会出现能力显著下降的情况。具体而言,当文本长度超过传统上下文窗口的支持范围后,模型往往难以保持前后文的逻辑一致性,导致生成内容脱节或信息遗漏。

而 MiniMax-01 凭借其创新的架构设计和优化算法,成功克服了这一瓶颈,展现了在超长文本任务中的卓越处理能力。尤其是在需要处理海量上下文信息的场景中,MiniMax-01 的性能稳定性得到了充分体现。

例如,在网络小说生成中,MiniMax-01 可支持 1M Token 的超长上下文范围,完整记忆人物设定、关键情节及世界观细节,保证续写逻辑连贯,避免传统模型在超长文本中出现内容断层或情节紊乱的问题。

在法律合同分析中,MiniMax-01 能一次性处理整份合同,精准提取关键条款、争议点或隐藏的逻辑,为法律从业者提供高效支持。在历史记录和事件时间轴生成中,MiniMax-01 凭借其强大的长距离依赖捕获能力,梳理事件因果关系与时间脉络,表现出色,适用于复杂的多层次分析任务。

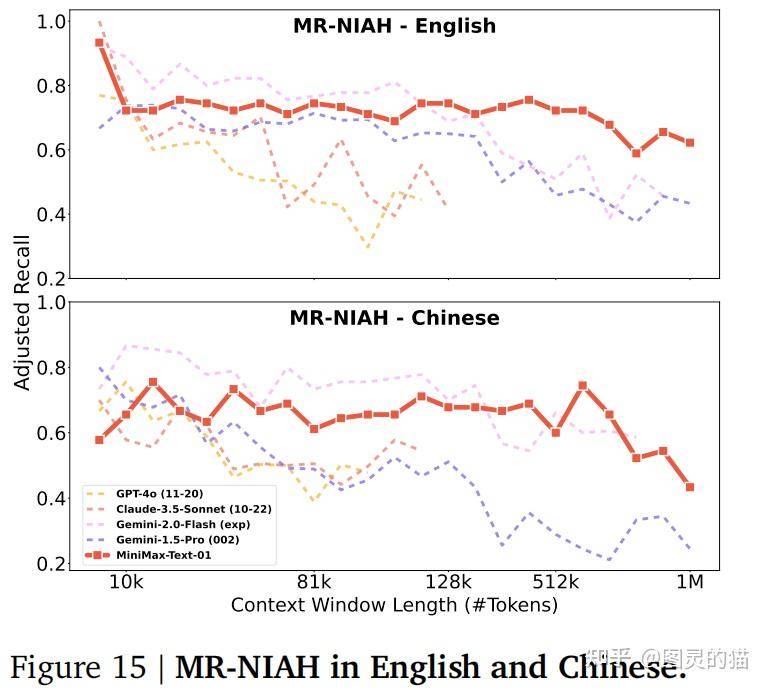

此外,为了评估模型在长文本任务中的记忆和检索能力,团队构建了一个名为 多轮针尖大海捞针(MR-NIAH) 的挑战性评估维度,专注于多轮对话上下文中的长文本检索任务。MR-NIAH 的任务模拟历史对话场景,其中用户查询是基于事件描述和创意写作的明确请求,要求模型在最后一轮中准确重复历史请求中的一个响应。

测试范围覆盖从 2K 到 1M Token 的上下文窗口,最多可涵盖 2000 次交互。评估中对每个响应的核心事实进行调整后的召回率分析(Adjusted Recall),以更精确地衡量模型的长文本检索能力。正如上图所示,MiniMax-Text-01 在中英文任务中表现优越,无论是短窗口还是长窗口(如 512k 或 1M Token),其性能下降幅度均显著小于其他模型(如 GPT、Claude、Gemini 变体)

- 多模态理解

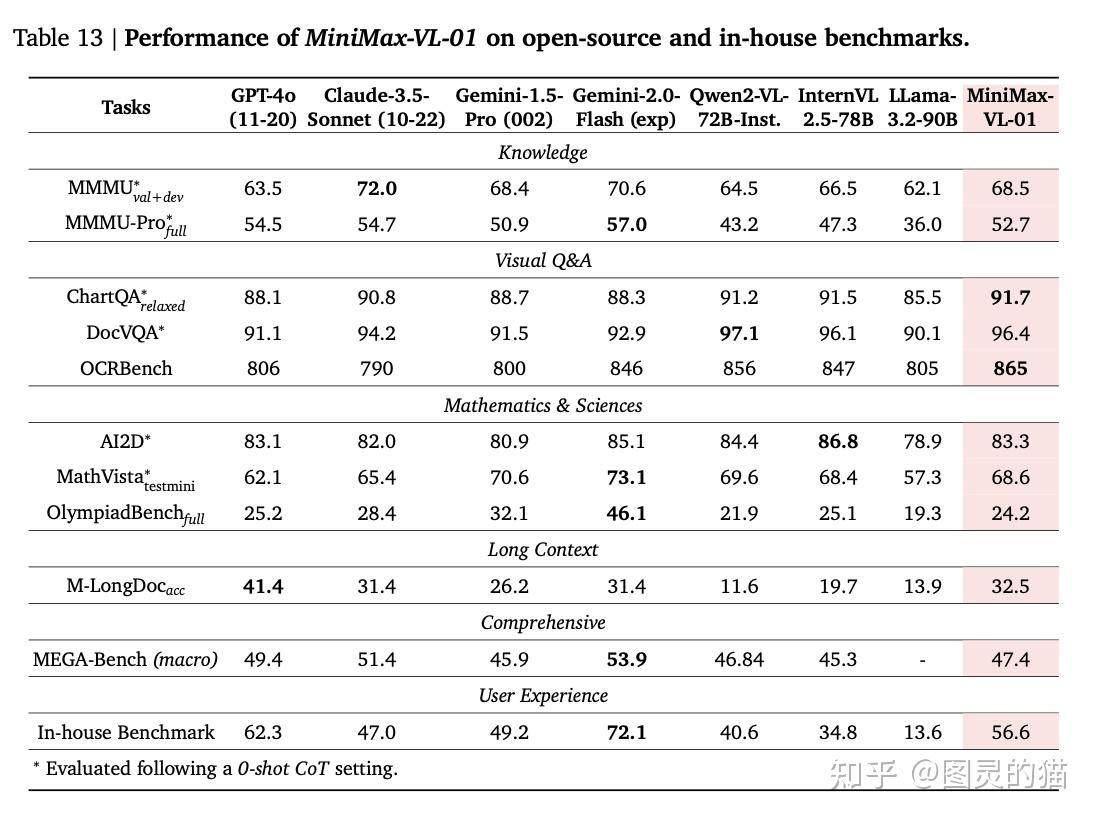

基于 MiniMax-Text-01文本模型,MiniMax 还开发了⽤于多模态理解任务的MiniMax-VL-01。从测试结果来看,⽤于多模态理解任务的MiniMax VL-01,也有较为领先的结果,整体能与其它知名SOTA 模型媲美,并可在一些基准上可以拔得头筹。

当然,每一家模型都存在一定自身局限性。比如说面对复杂高级编程任务,目前的模型表现有限,技术报告中表示未来会增加更多的训练数据来进行校准,增加这方面的能力。

此外,团队还表示未来会实现更高效的架构,即纯线性架构,不再使用Softmax注意力。

MiniMax技术开源的动作和行业意义

Agent,一个2024年在各种大模型发布会/国际学术会议,一直不断被各位AI大模型公司创始人/行业大牛反复提到的概念。涉及到长链路任务,或者复杂任务的时候,长上下文就是Agent应用开发的必要条件。

作为一个创业公司,坚持自己的技术判断做创新,还是很值得鼓励的。未来,希望我们国内像Deepseek、MiniMax这样的团队,可以越来越多。

参考资料

- 1.开源地址:https://github.com/MiniMax-AI

- 2.Hugging Face:https://huggingface.co/MiniMaxAI

- 3.技术报告:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

- 4.网页端:海外版https://www.hailuo.aiAPI 国内版:https://hailuoai.com