如何看待deepseek自我介绍时提到openai模型?

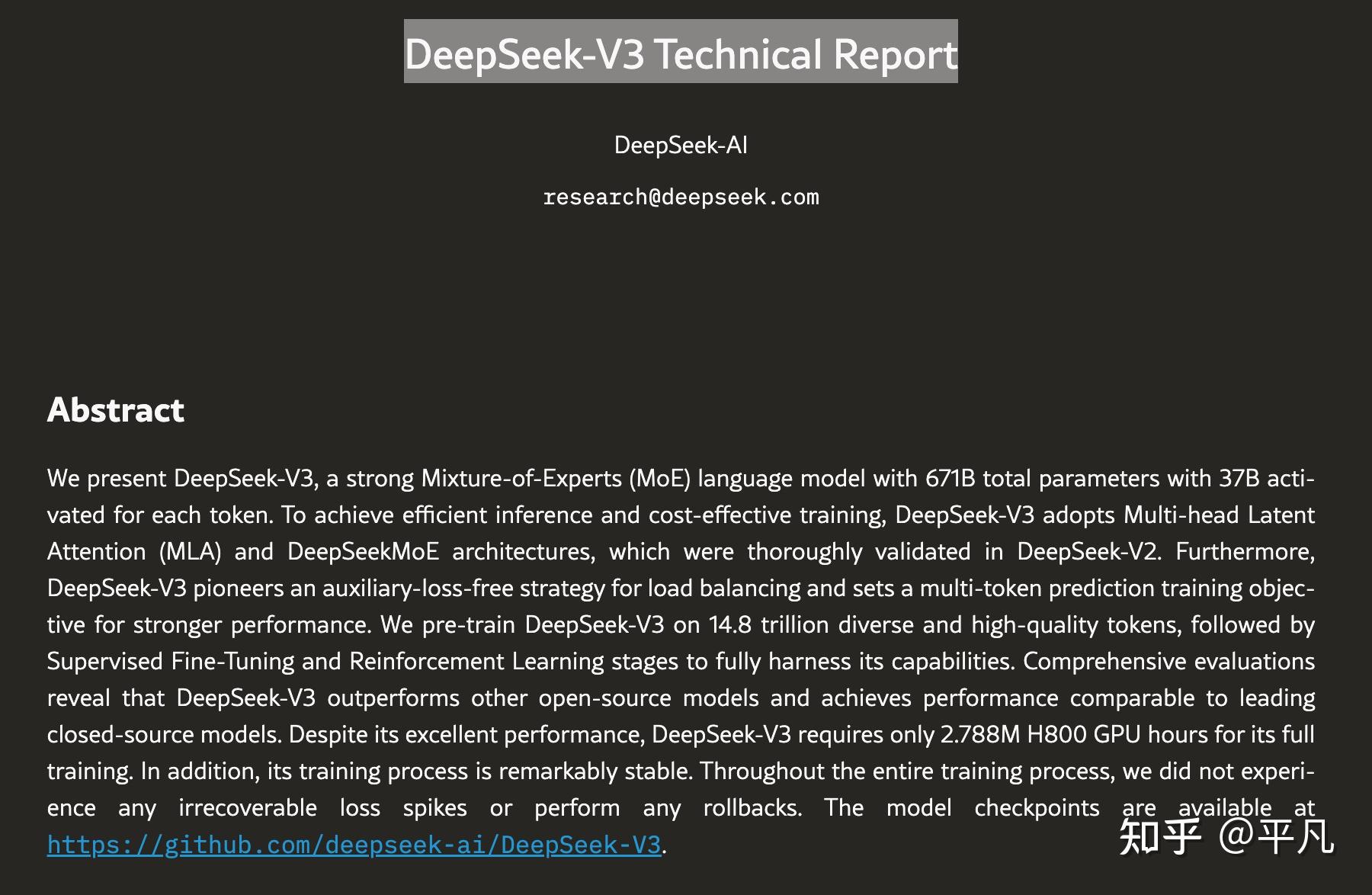

如何你愿意用翻译软件读一下《DeepSeek-V3 Technical Report》的话,就能够在论文的摘要,也就是报告最开始的一段话[1],提取到这两段关键的介绍。

第一段:

To achieve efficient inference and cost-effective training, DeepSeek-V3 adopts Multi-head Latent Attention (MLA) and DeepSeekMoE architectures, which were thoroughly validated in DeepSeek-V2.

这句话的表明了DeepSeek V3的主要目的是为了实现高效推理(inference)和具有成本效益的训练(cost-effective training),采用了两种关键架构:Multi-head Latent Attention (MLA) 和 DeepSeekMoE,并且这些架构已经在其前一版本 DeepSeek-V2 中经过充分验证。

更通俗点来讲,DeepSeek自己也提到了它的主要目的是“用最少的卡,实现尽可能好的效果”,这是它的出发点。

第二段:

在后面的这句话里提供了结果。

Comprehensive evaluations reveal that DeepSeek-V3 outperforms other open-source models and achieves performance comparable to leading closed-source models. Despite its excellent performance, DeepSeek-V3 requires only 2.788M H800 GPU hours for its full training. In addition, its training process is remarkably stable.

DeepSeek-V3性能领先于其他的开源模型,甚至和领先的Close-AI(特指OpenAI的GPT4o)性能相当。与此同时,DeepSeek-V3仅用了2.788M的GPU训练时间就完成了训练,而GPT4o需要25000块的A100显卡,是DeepSeek的10倍左右。

你看,DeepSeek通篇就说了两个点:

1 将大模型训练的成本打下去!

2 性能上达到第一梯度。

都实现了。

而题目中提到的问题,其实根本不算什么大事,因为这种问题根本不算“事实”,事实就是那些现实中已经有定论的,比如铁元素的化学符号是Fe,如果出现这种问题,那可以说明模型训练有问题。

但这种非常主观,且容易受到数据污染的问题,说明不了什么,甚至到不了瑕不掩瑜的程度。

外网DeepSeek的热度已经爆了,跟Qwen并称为国内两大顶流。

更为深度的解读,其实可以看他们的Github的总体介绍。

GitHub - deepseek-ai/DeepSeek-V3