Python 爬虫是什么?

一、爬虫的种类

静态爬虫容易理解,主要是动态的爬虫不容易理解。

1、静态爬虫

访问静态网页,直接解析HTML内容。常用于抓取新闻、博客等内容。

2、动态爬虫

动态爬虫通常需要模拟浏览器的行为,执行JavaScript代码来获取动态加载的内容。常见的动态网页包括Ajax加载的内容、SPA(单页应用)、WebSocket实时数据等。

一个常见的例子是爬取豆瓣电影的动态评论信息。使用静态爬虫只能获取初始页面的少量评论,而要爬取完整的评论数据,则需要通过模拟鼠标滚动、点击"加载更多"等动作来获取。这时就需要使用动态爬虫技术,比如Selenium或Puppeteer。

以Selenium为例,安装方法如下:

pip install selenium

然后编写如下代码模拟浏览器行为:

from selenium import webdriver

from selenium.webdriver.common.by import By

# 创建Chrome浏览器实例

driver = webdriver.Chrome()

# 访问豆瓣电影页面

driver.get("https://movie.douban.com/subject/26683290/comments?status=P")

# 模拟滚动加载更多评论

last_height = driver.execute_script("return document.body.scrollHeight")

while True:

# 滚动到页面底部

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

# 等待新评论加载

new_height = driver.execute_script("return document.body.scrollHeight")

if new_height == last_height:

break

last_height = new_height

# 获取所有评论元素

comments = driver.find_elements(By.CSS_SELECTOR, ".comment-item .comment p")

for comment in comments:

print(comment.text)

# 关闭浏览器

driver.quit()

运行后会出现类似的界面

二、爬虫的应用

- 内容采集:新闻、博客、电商数据等。

- 信息监控:价格监测、舆情分析等。

- 数据挖掘:社交网络分析、行业研究等。

- 自动化任务:RSS订阅、天气预报等。

三、爬虫常用的库

1. requests

简介:requests是一个用于发送HTTP/HTTPS请求的Python库。它允许你轻松地发送各种HTTP请求,如GET、POST等,并处理返回的响应。

安装方式:

pip install requests

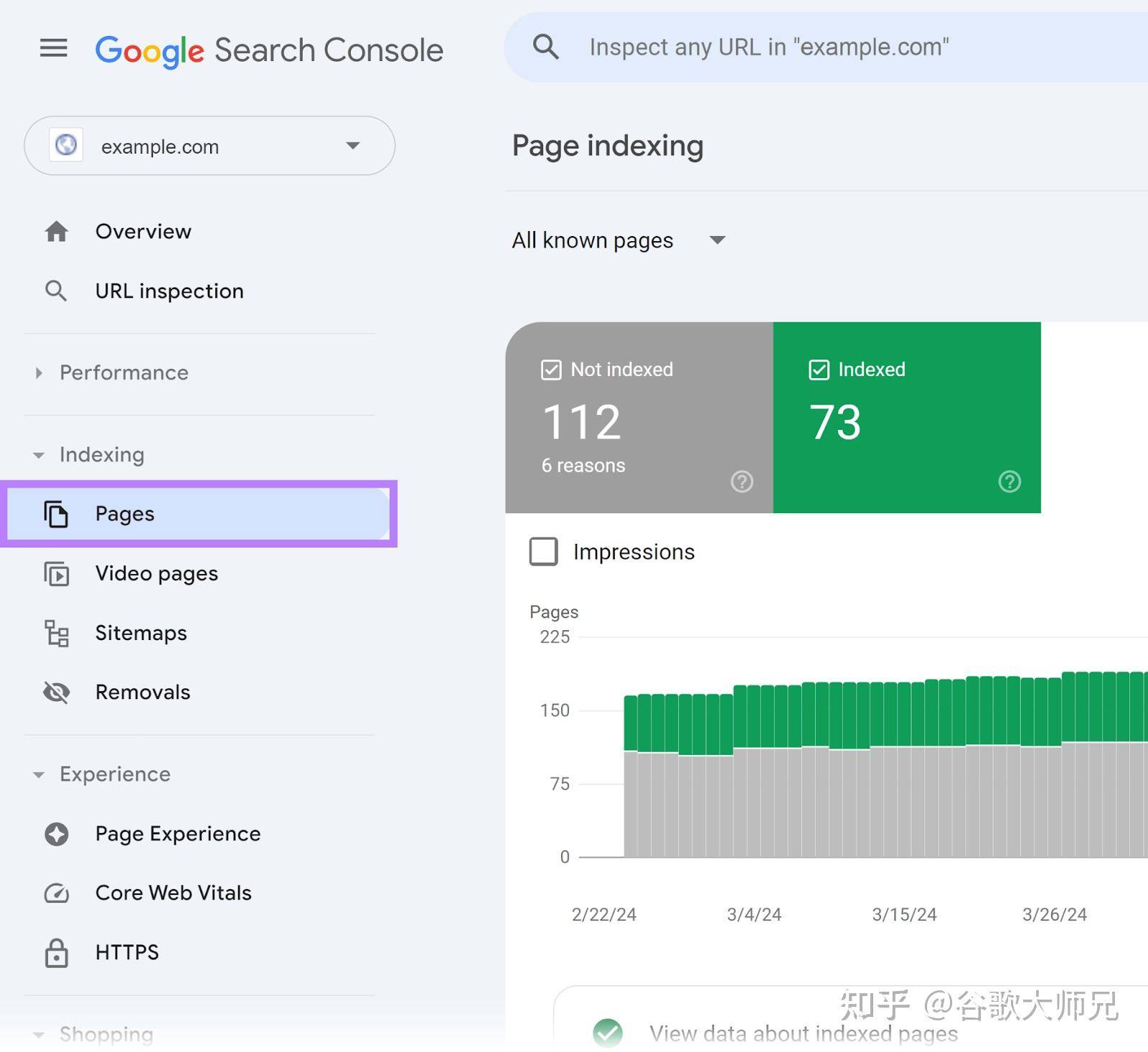

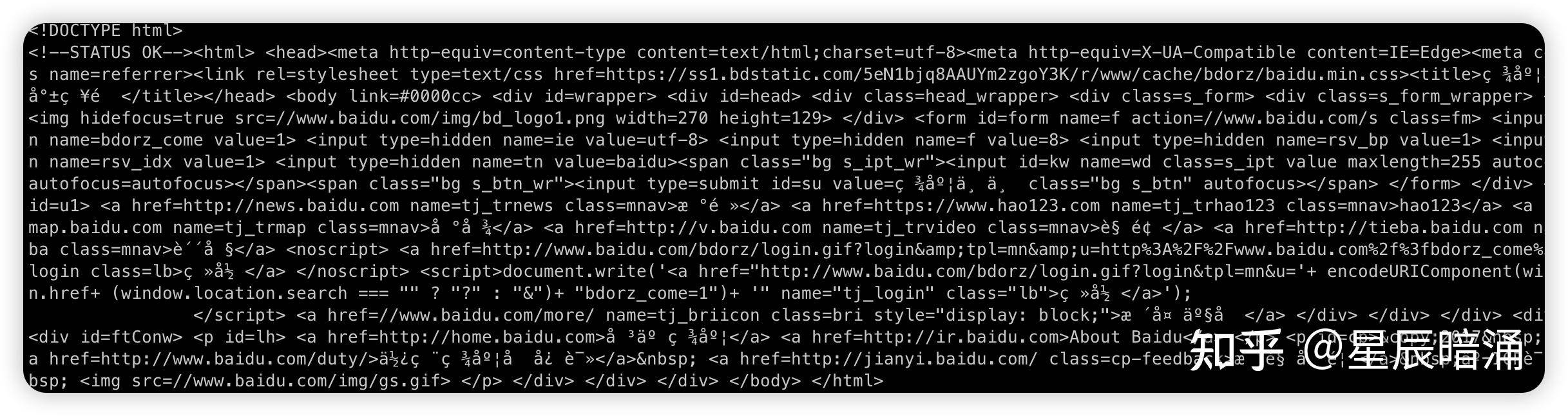

示例:以某度为例子说明

import requests

response = requests.get('https://www.baidu.com')

print(response.text)

运行后界面是

2. BeautifulSoup

简介:BeautifulSoup是一个用于解析HTML和XML文档的Python库。它提供了简单的API来遍历、搜索和修改解析树。

安装方式:

pip install beautifulsoup4

示例:

from bs4 import BeautifulSoup

import requests

url = 'https://www.baidu.com'

response = requests.get(url)

# 设置响应的编码格式为UTF-8

response.encoding = 'utf-8'

html = response.text

soup = BeautifulSoup(html, 'html.parser')

title = soup.title.string

# 直接输出即可,Python3默认使用UTF-8编码

print(title)

3. Scrapy

简介:Scrapy是一个快速的高级Web爬取和网页解析框架,用于抓取网站并从中提取结构化的数据。它提供了异步并发、中间件、管道等功能,非常适合构建复杂的爬虫项目。

安装方式:

pip install scrapy

示例(创建一个简单的Scrapy项目):

scrapy startproject myproject

cd myproject

scrapy genspider example example.com

然后在生成的example.py文件中编写爬取逻辑。

4. Selenium

简介:Selenium是一个自动化测试工具,但也可以用于爬取动态网页。它通过模拟真实用户的行为来操作浏览器,从而获取动态加载的内容。

安装方式:首先安装Selenium库:

pip install selenium

然后下载对应浏览器的WebDriver,如ChromeDriver,并将其添加到系统PATH中。

示例:

from selenium import webdriver

driver = webdriver.Chrome() # 确保ChromeDriver已添加到PATH

driver.get('https://example.com')

title = driver.title

print(title)

driver.quit()

详细见第一部分。

5. lxml

简介:lxml是一个快速、灵活且易于使用的HTML/XML解析库。它结合了libxml2和libxslt的优点,提供了XPath和XSLT等高级功能。

安装方式:

pip install lxml

示例:

from lxml import etree

html = '<html><body><h1>Hello, World!</h1></body></html>'

tree = etree.HTML(html)

title = tree.xpath('//h1/text()')[0]

print(title)

这些库在Python爬虫开发中非常常用,根据具体需求选择合适的库进行使用。

四、爬虫的Git库

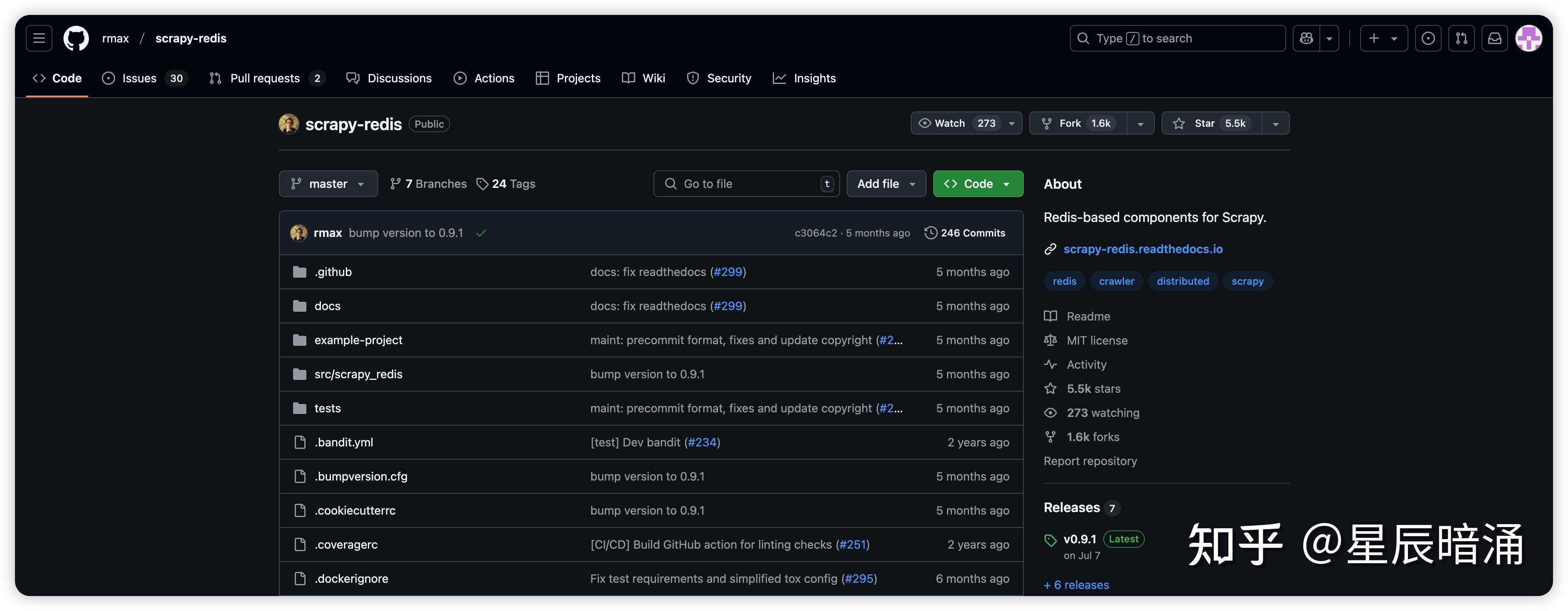

Scrapy-Redis

基于Redis的分布式爬虫,可扩展性强。

https://github.com/rmax/scrapy-redis

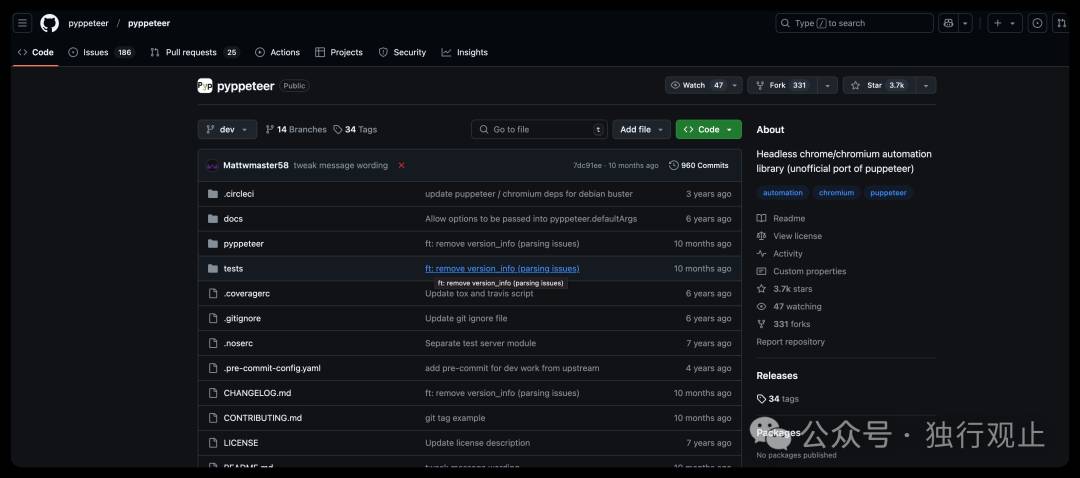

pyppeteer

基于Puppeteer的无头浏览器库,可模拟Chrome行为https://github.com/pyppeteer/pyppeteer

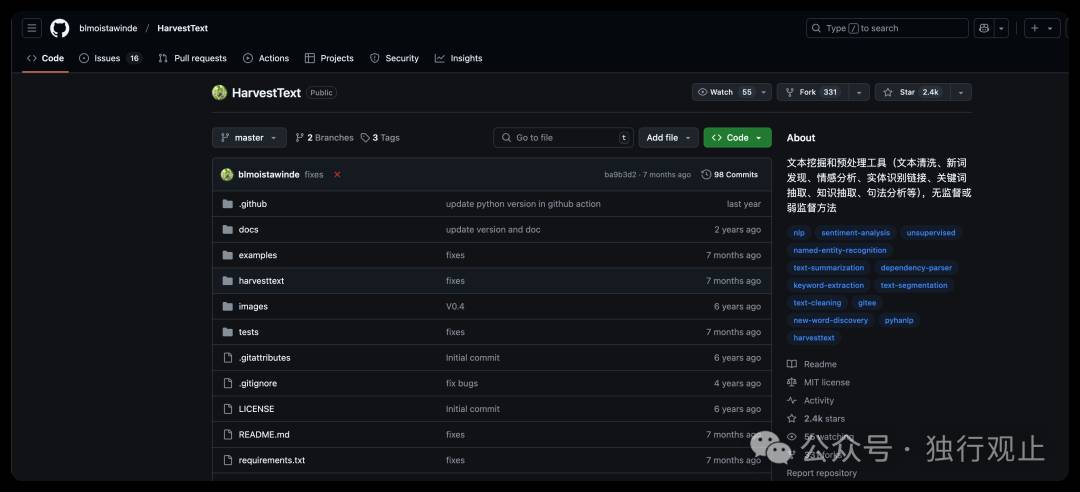

HarvestText

多功能文本处理库,包括提取、清洗等。https://github.com/blmoistawinde/HarvestText

五、爬虫的性能优化

- 使用异步并发库如aiohttp、Scrapy等提高并发性能。

- 采用增量式更新,只抓取变化的数据。

- 使用代理IP、User-Agent池等避免被屏蔽。

- 合理设置请求间隔,遵守robots.txt协议。

六、爬虫的合法性与道德规范

- 遵守网站的robots.txt协议。

- 尊重网站的使用条款,避免过度消耗网站资源。

- 适当增加请求间隔,避免给目标网站造成负担。

- 保护个人隐私信息,不将数据用于非法用途。

七、爬虫的错误处理与日志记录

logging库提供了强大的日志记录功能,可以记录各种类型的错误信息。

requests.exceptions模块定义了丰富的异常类型,可以灵活处理各种网络错误。

import logging

logging.basicConfig(level=logging.INFO)

try:

response = requests.get(url)

response.raise_for_status()

except requests.exceptions.RequestException as e:

logging.error(f'Error fetching {url}: {e}')

八、特定数据类型的处理

- pandas: 处理表格数据,提供了强大的数据清洗、分析功能。

- PyMongo: 处理MongoDB数据库,方便存储和查询结构化数据。

- elasticsearch-dsl: 处理Elasticsearch数据,支持复杂的全文检索。

九、爬虫的扩展性与模块化设计

- 使用面向对象编程,将爬虫逻辑封装到类中,提高代码复用性。

- 采用插件化设计,将不同功能拆分成独立模块,方便扩展和维护。

- 利用设计模式如工厂模式、观察者模式等提高系统灵活性。

- 实现可配置的设置系统,支持动态调整爬虫参数。