为什么BAT没做出DeepSeek?

阿里在这件事里绝对是最冤的那个。

当时Qwen2.5霸榜了openllm好久,夸张到Best XXX Model从0.5B的到70B的清一色全都是Qwen2.5。

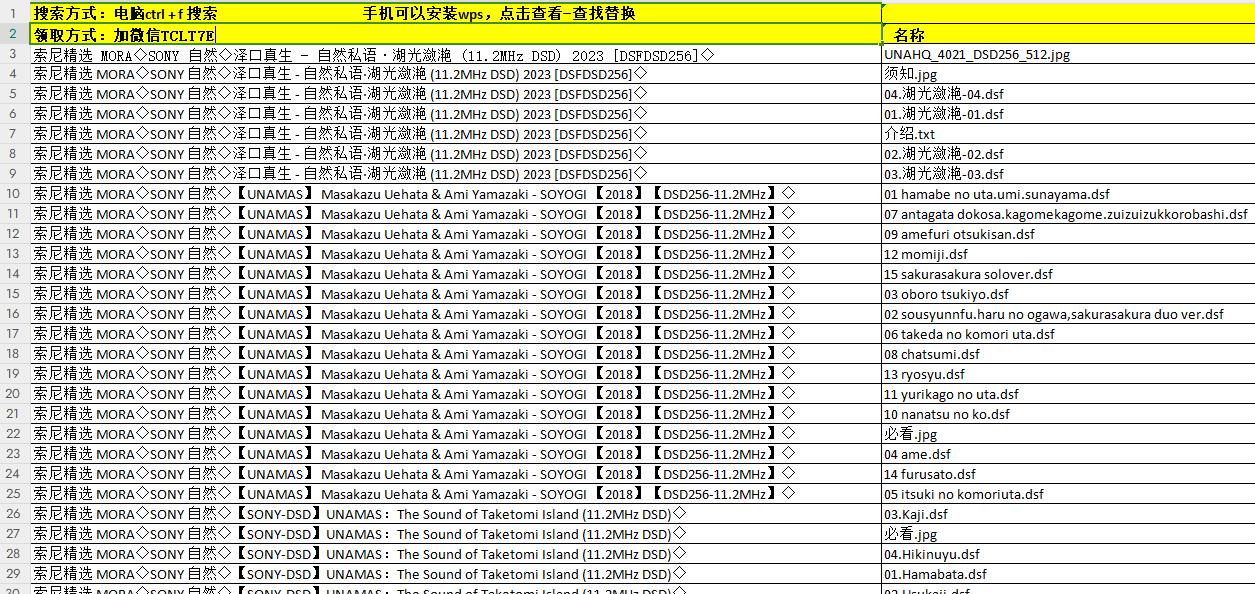

现在随便翻进一个rank(openllm,只有开源模型):

看起来百花齐放是吧?然而事实上是点进去看看前十名都TM是Qwen2.5 72B上finetune的。

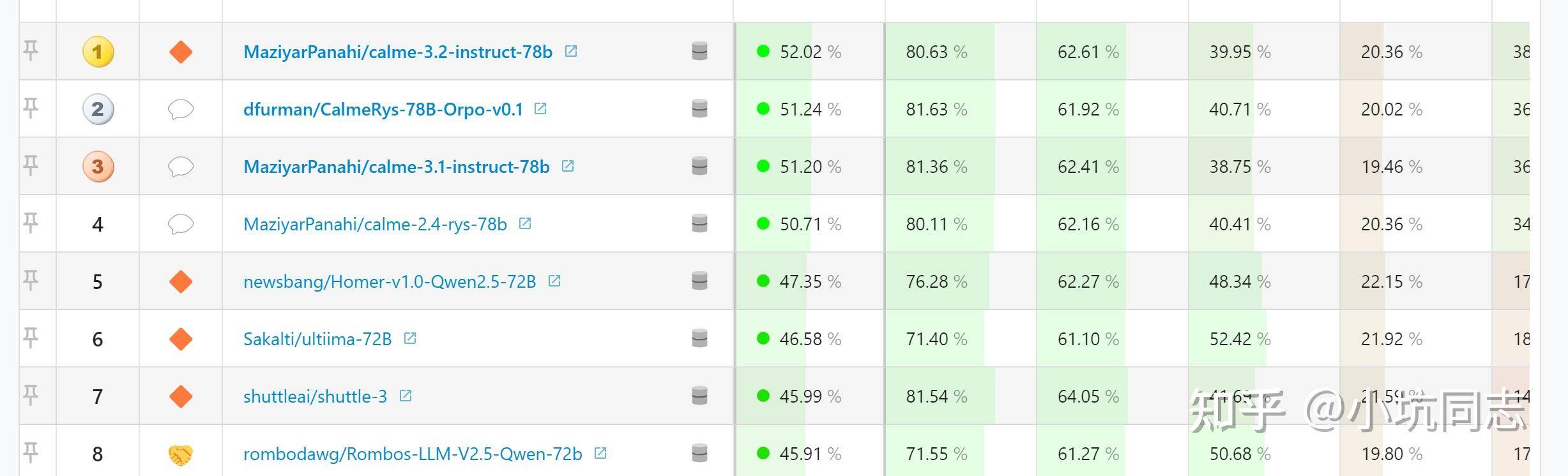

你再随便翻进另一个rank(arena hard)

这个有点老了,第一个开源模型也是Qwen72b finetune出来的。

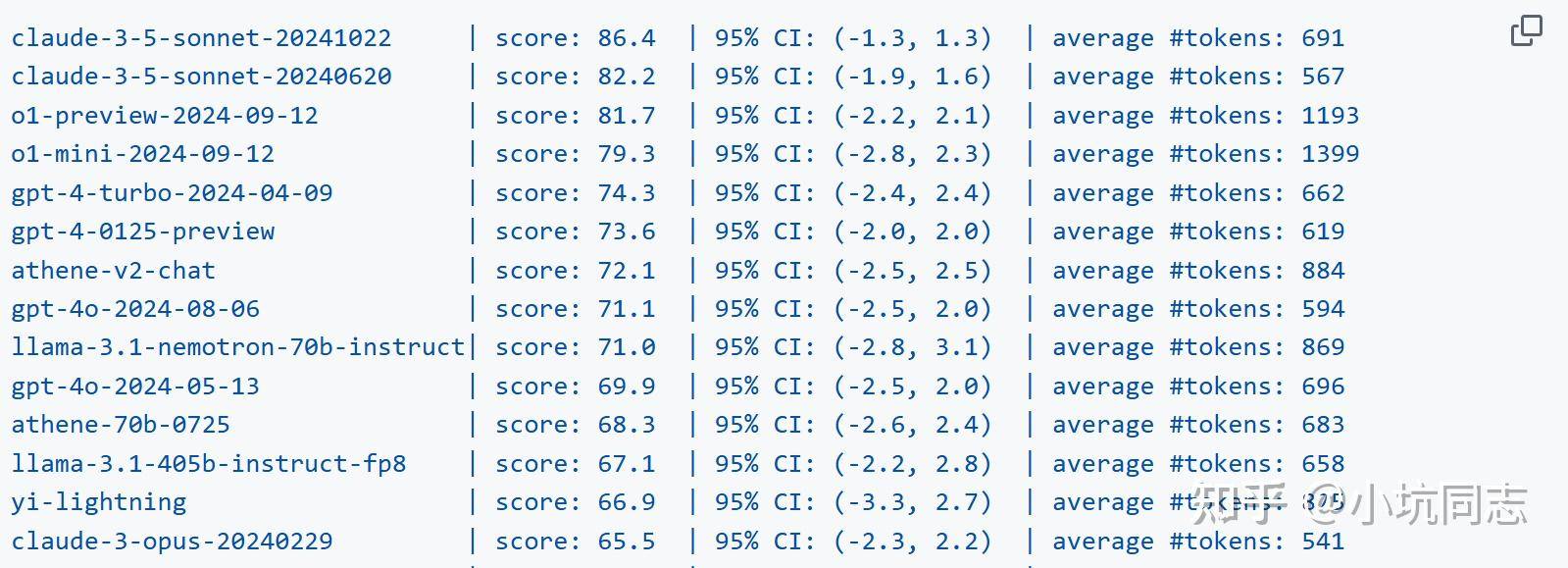

你再随便翻进一个rank(live bench),这个很新,上面甚至有R1/V3。R1/V3之后的开源模型就是Qwen72b给finetune出来的。

之后阿里的创新能力就严重不足了,悲。事实上Deepseek发了一个R1一个V3,之后又有好几个版本finetune的qwen,为什么他发布的是 distill的qwen不是其他模型(像llama)?肯定是有}理由的啊。