阿里开源 320 亿参数模型吊打 DeepSeek-R1,网友:参数少性能强是真突破还是营销噱头?

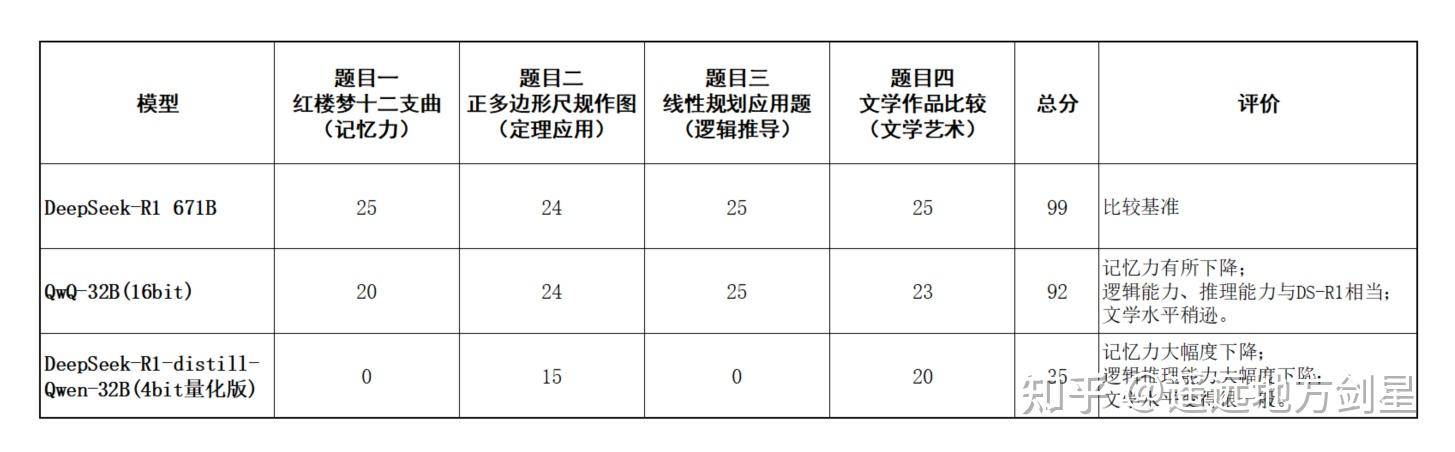

大模型相关技术发展太快了,我在2025-2-16的时候写过一篇文章,对比的是DeepSeek-R1满血版和我们自己部署的DeepSeek-R1-distill-Qwen-32B 4bit量化版。当时我考了它们4道题目,百分制下满血版DeepSeek-R1得分99分,DeepSeek-R1-distill-Qwen-32B 4bit量化版 得分35分,差距还是比较大的。具体情况见文章链接,

遥远地方剑星:DeepSeek R1 满血版和 4-bit 32B 量化版的简单对比没想到短短不到一个月之后,阿里就发布了QwQ-32B,这是一个经过强化训练(RL)、具备推理能力的千问32B大模型。阿里自己认为这个大模型的能力在几个测试集上(AIME24、LiveCodeBench、liveBench、IFEval、BFCL)的表现都不逊于或超过满血版DeepSeek-R1,我一开始也是比较惊讶的。

当然,阿里发布的这款QwQ-32B是16bit参数的,而我之前对比的是我们自己部署的DeepSeek 蒸馏 4bit量化版本,所以毫无疑问阿里这款QwQ-32B能力应该是比我当时对比的4bit量化版的能力要强的。但是这个QwQ-32B能否比肩满血版DeepSeek-R1呢?毕竟满血版的R1是671B的参数规模。下面我还是用我之前文章中的4道题目对QwQ-32B做一次面试,仍然是在允许深度思考但关闭联网搜索的基础上进行面试,情况如下:

测试题目1:《红楼梦》第五回中警幻仙姑请贾宝玉欣赏的红楼十二支曲子的名字都叫什么?

《红楼梦》第五回中,警幻仙姑为贾宝玉展现的《红楼梦》十二支曲子(即“金陵十二钗正册”判词对应的曲名)共有十二首,其名称及对应人物如下:

---

### **1. 《终身误》**

- **对应人物**:贾宝玉、林黛玉、薛宝钗

- 内容:揭示宝玉与宝钗、黛玉之间的婚姻悲剧与命运错位。

---

### **2. 《枉凝眉》**

- **对应人物**:贾宝玉、林黛玉

- 内容:以宝黛爱情为线索,暗示两人因“木石前盟”而终成虚幻。

---

### **3. 《恨无常》**

- **对应人物**:史湘云

- 内容:以史湘云的“寿夭”命运为象征,隐喻美好事物的短暂与无常。

---

### **4. 《分骨肉》**

- **对应人物**:贾探春

- 内容:预示探春远嫁异乡,骨肉分离的悲剧。

---

### **5. 《乐中悲》**

- **对应人物**:贾元春

- 内容:暗喻元春入宫为妃的荣耀与最终的凄凉结局。

---

### **6. 《世难容》**

- **对应人物**:妙玉

- 内容:反映妙玉孤高自许却难逃世俗污染的悲剧。

---

### **7. 《喜冤家》**

- **对应人物**:贾迎春

- 内容:暗示迎春嫁入孙家后被虐待致死的悲惨命运。

---

### **8. 《虚花误》**

- **对应人物**:贾惜春

- 内容:预示惜春看破红尘,遁入空门的结局。

---

### **9. 《聪明累》**

- **对应人物**:王熙凤

- 内容:讽刺王熙凤机关算尽却反误自身的命运。

---

### **10. 《留余庆》**

- **对应人物**:巧姐(贾琏之女)

- 内容:暗示巧姐虽出身显赫,却因家族败落被刘姥姥救赎。

---

### **11. 《晚韶华》**

- **对应人物**:李纨

- 内容:描绘李纨青春守寡、晚年“封诰”却晚景凄凉的矛盾。

---

### **12. 《好事终》**

- **对应人物**:秦可卿

- 内容:以秦可卿的早逝为象征,暗示宁国府“树倒猢狲散”的结局。

---

### **补充说明**

- **命名特点**:十二支曲名均以“悲、恨、误、冤、虚、累”等字眼收尾,暗示人物命运的悲剧性。

- **结构顺序**:曲目顺序并非完全按人物地位排列,而是通过诗意的关联串联全书主题,如《终身误》与《枉凝眉》以宝黛爱情开篇,最终以《好事终》收尾,象征“白茫茫大地真干净”的结局。

这些曲子与太虚幻境中的判词共同构成《红楼梦》的预言体系,是解读全书命运线索的重要依据。

这个回答把《恨无常》与《乐中悲》对应的人物搞反了,而且《虚花悟》错写为《虚花误》。另外,其实红楼十二支曲子共有十四首,还有前面的引子和后面的收尾,这篇回答也未提及。所以,总体上给20分吧。

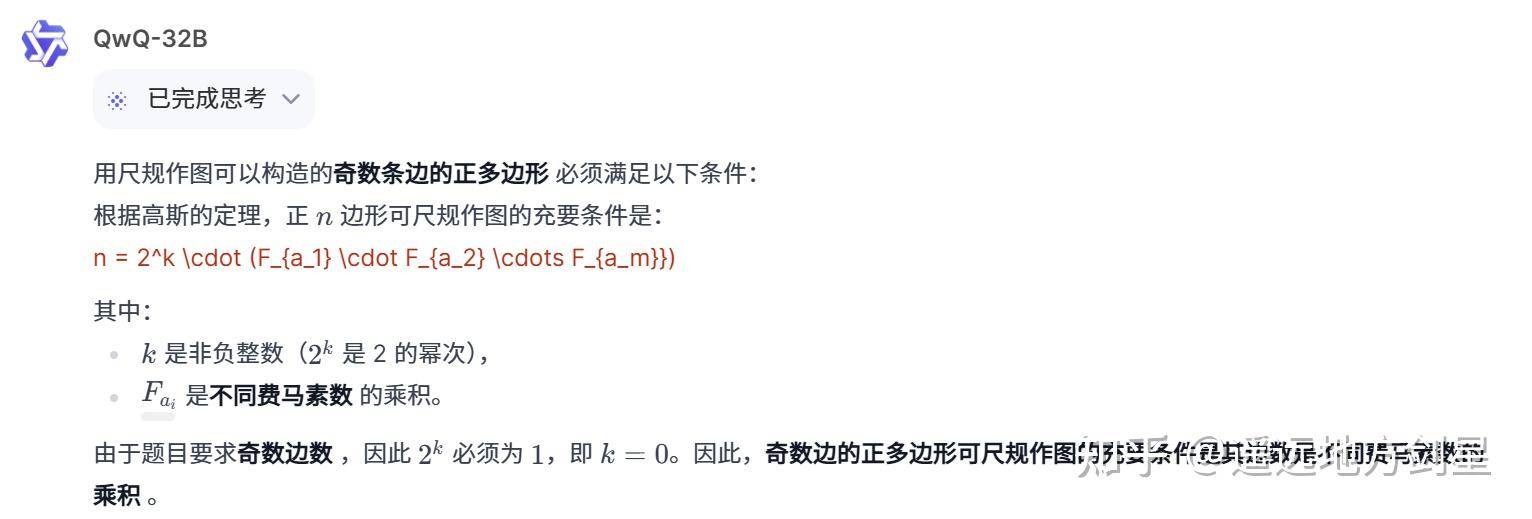

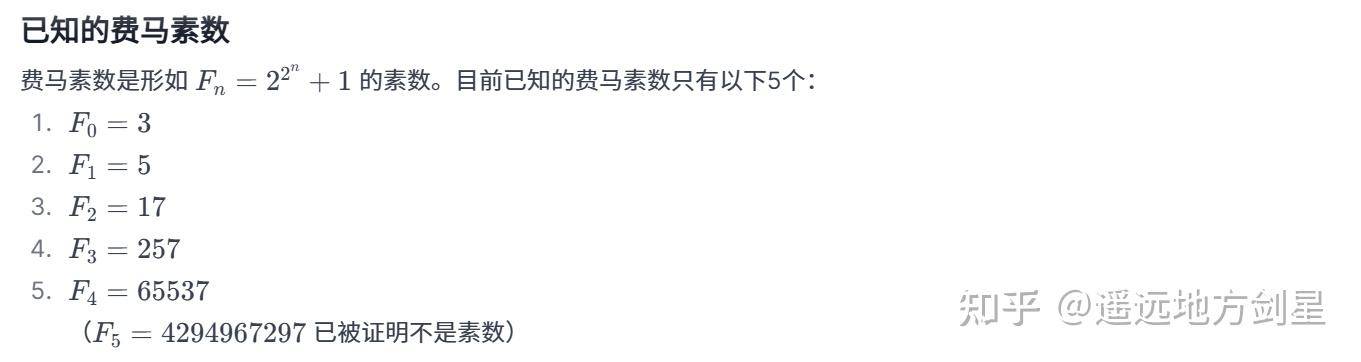

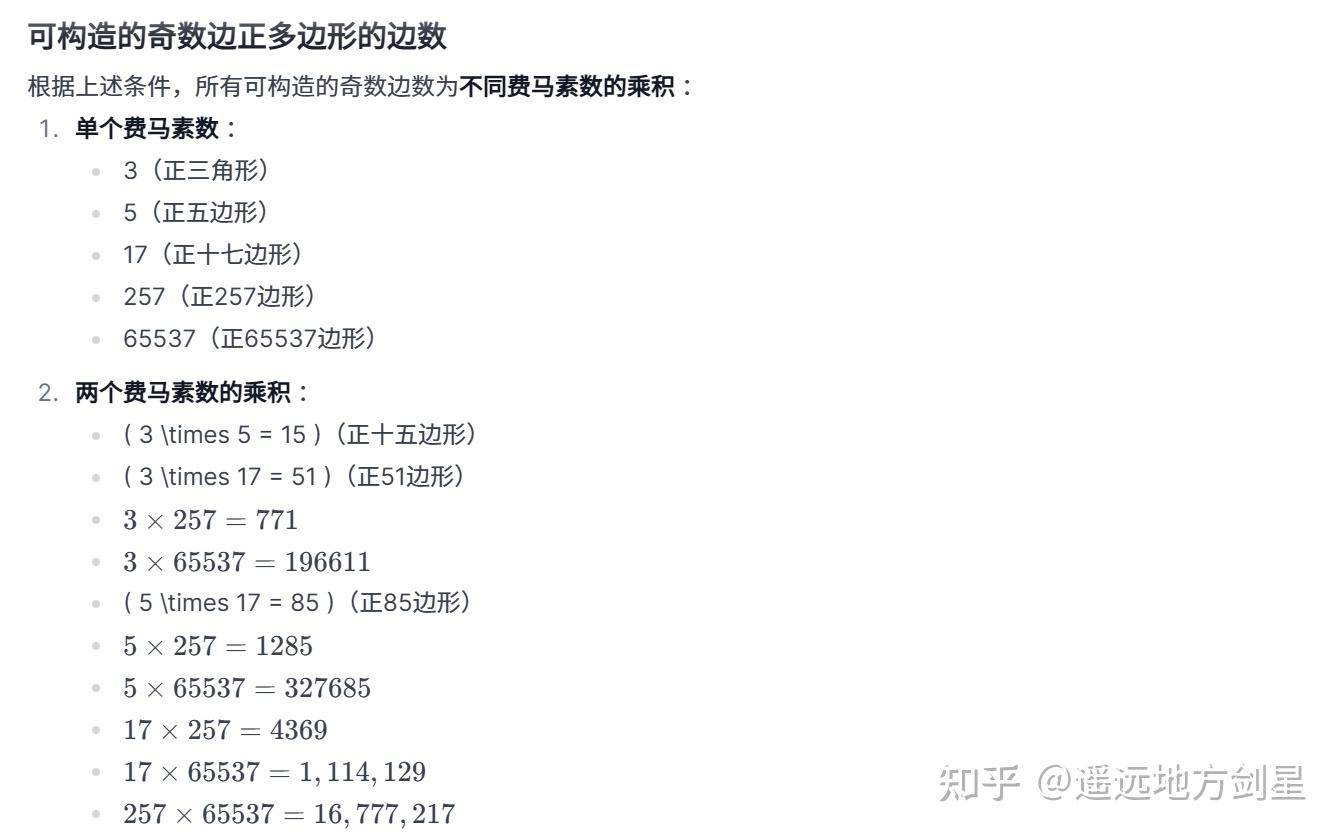

测试题目2:用尺规作图(无刻度的直尺+圆规)可以做出哪些奇数条边的正多边形?

这道题目QwQ-32B的回答与满血版DS-R1的回答相当,都可以给24分,扣掉1分是由于没有明确给出共有31中可能的奇数边正多边形。

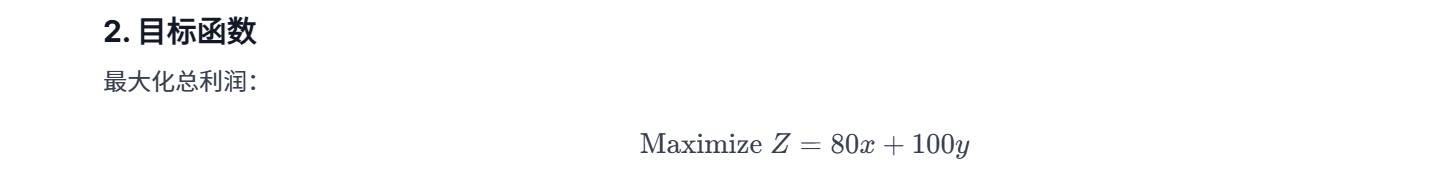

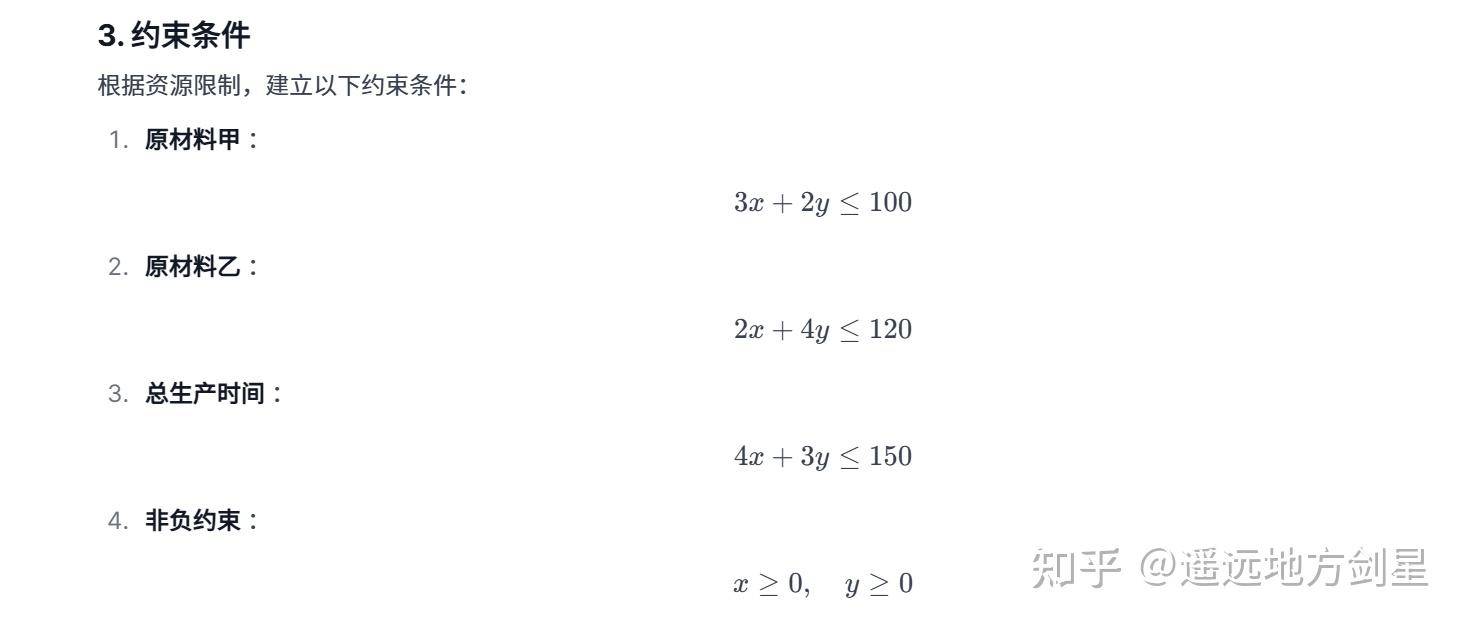

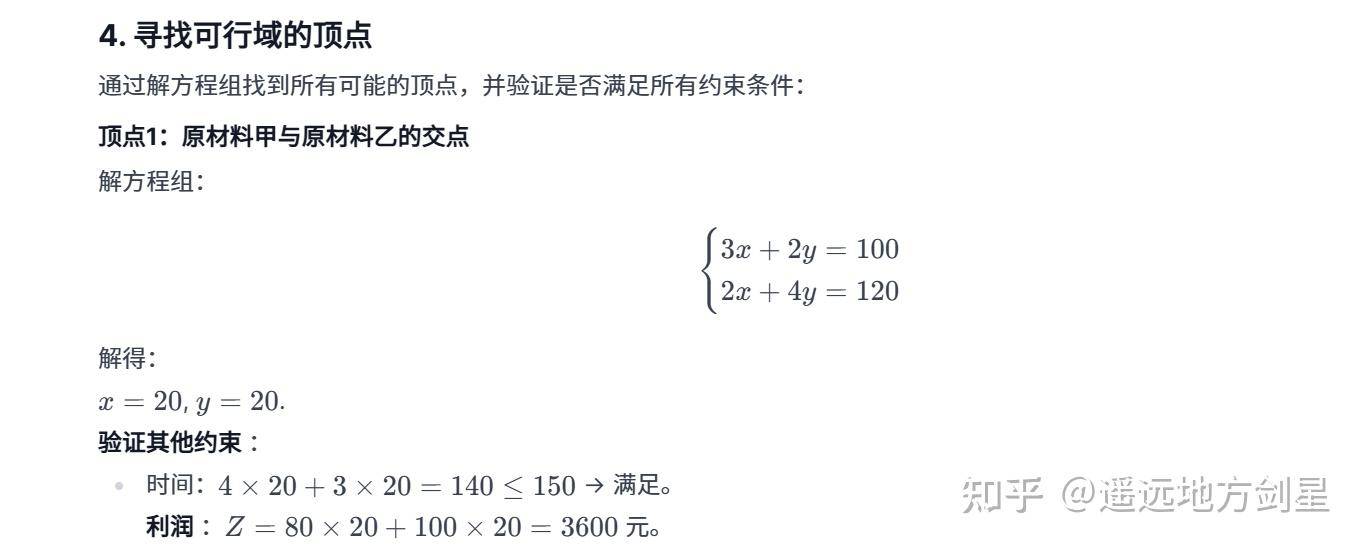

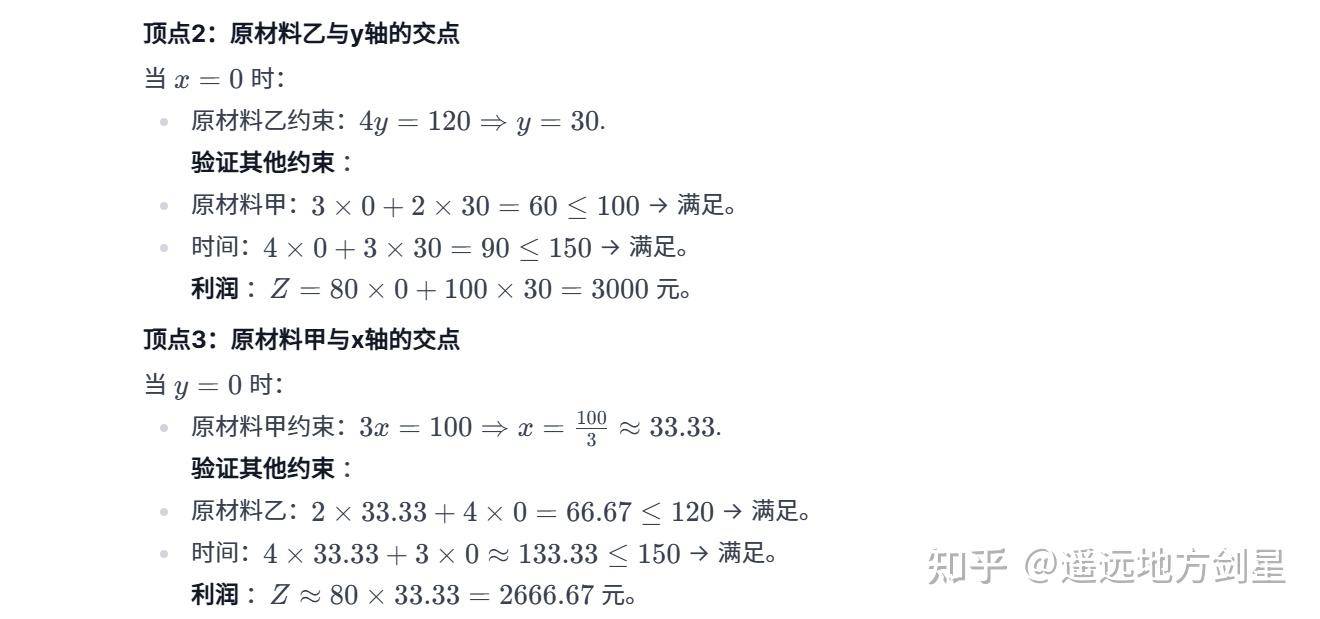

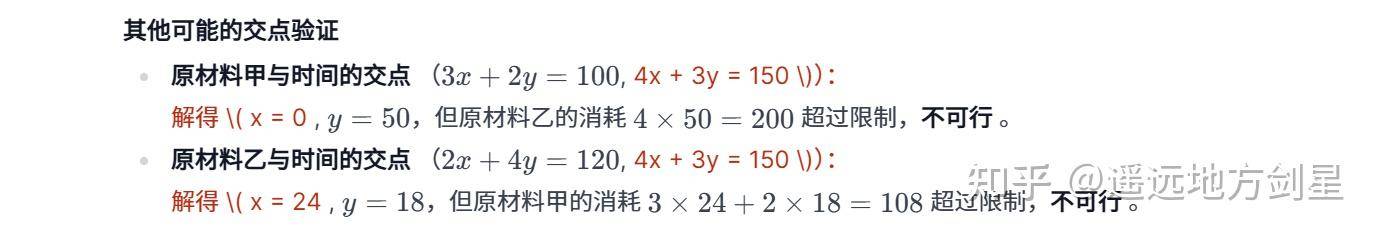

测试题目3:请帮忙给出下面这道题的解答:一个工厂生产两种产品 A 和 B,生产一件产品 A 需要消耗原材料甲 3 千克、原材料乙 2 千克,耗时 4 小时,可获利 80 元;生产一件产品 B 需要消耗原材料甲 2 千克、原材料乙 4 千克,耗时 3 小时,可获利 100 元。现在工厂有原材料甲 100 千克,原材料乙 120 千克,总生产时间为 150 小时。问:如何安排生产产品 A 和产品 B 的数量,才能使工厂获得最大利润,最大利润是多少?

这道题目QwQ-32B给出的回答相当精彩,完全不输满血版R1。它思考的过程也很长,和满血版R1的思考过程也相当。所以,这道题目给它满分,25分。

测试题目4:请告诉我你觉得张若虚的《春江花月夜》和李白的《蜀道难》这两首诗哪一首更好一些?

对于这道题目的回答,我觉得QwQ-32B水平应该说基本能够比肩满血版DS-R1,从最后的总结来看,文学色彩稍逊一点点,差距不是很大,我给它23分(当然,这个评分是有一些主观性的)。DS-R1满血版的回复可参见我前面文章的链接。

分析总结:

从这次面试情况来看,QwQ-32B(16bit)的总得分为92分,远高于“DeepSeek-R1-distill-Qwen-32B 4bit量化版”的35分,略逊于满血版 DeepSeek-R1 671B的99分。所以,我的结论是:

QwQ-32B水平与DeepSeek-R1 671B总体上相当,远高于我们当初部署的“DeepSeek-R1-distill-Qwen-32B 4bit量化版”。但毕竟由于参数规模小,与DeepSeek-R1 671B相比,在记忆力方面(第一题)有所差距,在文学水平方面(第四题)略逊,但是在推理能力方面看不出有什么差别。

一个32B规模的模型能够与一个公认高水平的671B的大模型能力相当,是非常不容易的,但是肯定不能说QwQ-32B吊打DeepSeek-R1 671B,这是不现实的。

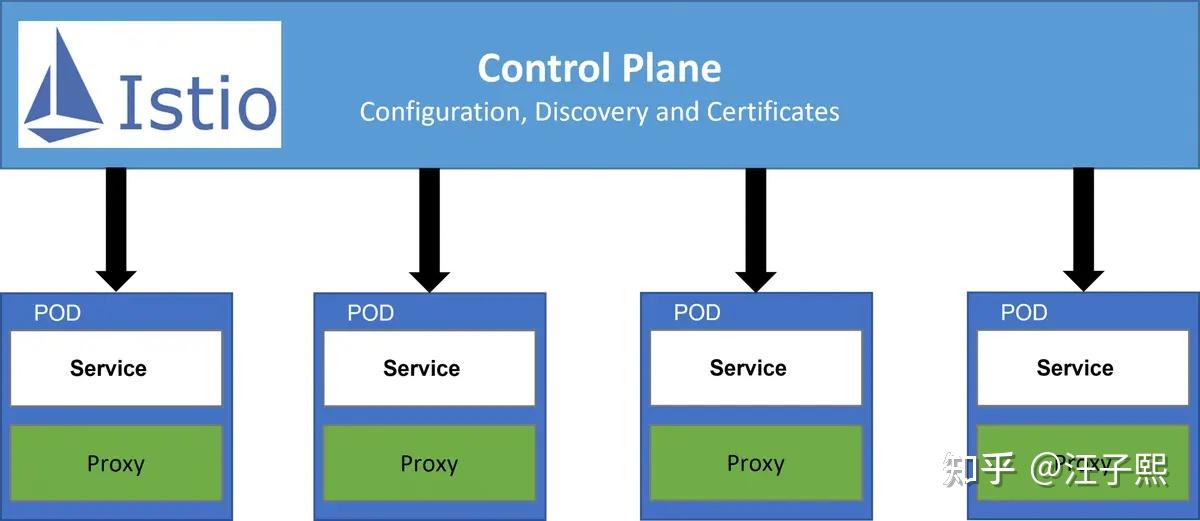

按道理说,一个32B规模的模型是很难超越一个高水平的671B模型的。我觉得QwQ-32B之所以能够做到与DeepSeek-R1 671B相当的程度,其中一个重要原因是“DeepSeek-R1 671B”采用的是MOE架构,它的参数矩阵总体上比较稀疏,虽然总共有671B的参数,但是每次计算时涉及到的参数大概在37B左右。QwQ-32B显然是一个训练得比较精干的模型,能够充分发挥这32B参数的作用。我想,QwQ-32B每次计算应该都会用到这32B的参数,与DeepSeek-R1 671B每次计算用到的37B参数规模相当,因此才有可能做到模型总体能力与DeepSeek-R1 671B相当。当然,做到这一点肯定是很不容易的。

QwQ-32B达到这样一个水平,说明目前大模型参数规模还有“挤水分”的空间,同时也给以后独立部署能力较强的大模型带来了可能性。设想随着GPU、NPU能力的提升,以及同等能力的大模型参数规模的下降,也许日后我们的手机、pad、电脑等个人设备都可以独立运行能力较强的大模型了,甚至未来的人形机器人也可能把大模型作为自己的大脑独立部署了。到那一天,机器人就不再是“机器”了,而更像是个“人”了。