如何评价智谱刚刚开源的文生图模型CogView4?

今天,智谱开源了新的文生图模型CogView4,而且开源协议是Apache 2.0,这意味着可以直接商用。

按照官方的说法,这是「智谱2025开源年」的第一个模型:首个支持生成汉字的开源文生图模型——CogView4。

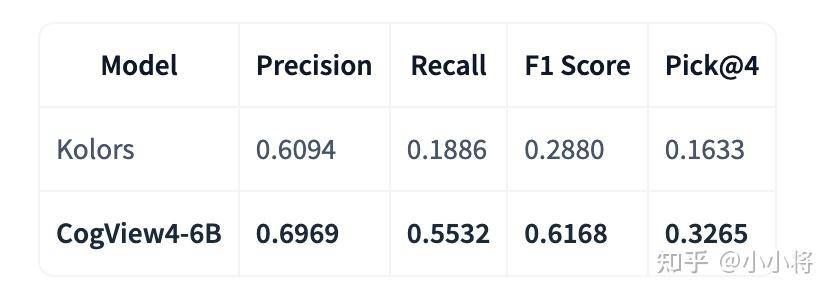

但是我觉得这里的首个支持生成汉字,应该是限定为智谱所开源的首个支持生成汉字的文生图模型,因为之前快手其实已经开源了一个可生成汉字的文生图模型Kolors。

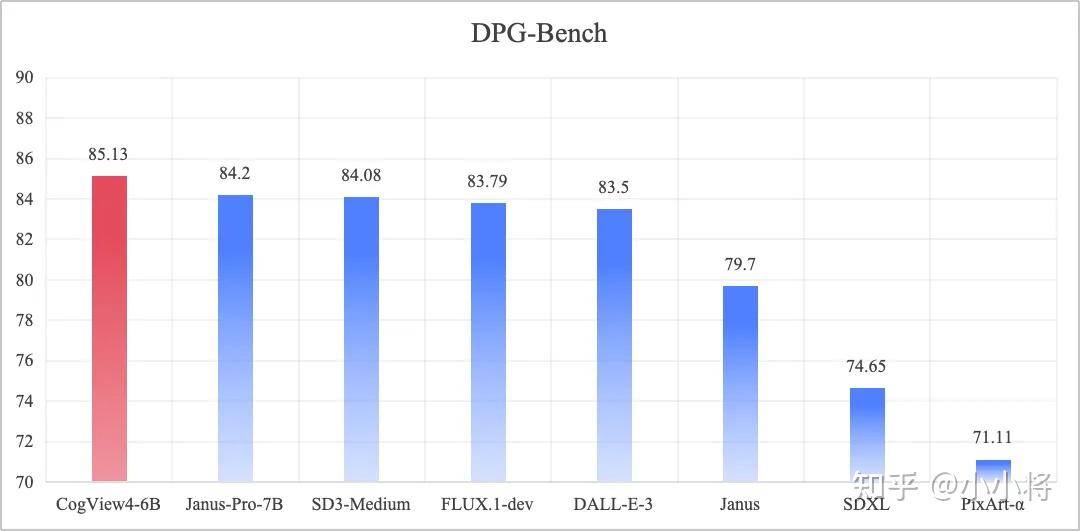

CogView4 在 DPG-Bench 基准测试中的综合评分排名第一,在开源文生图模型中达到 SOTA。DPG-Bench 基准测试是用来评估文生图模型的文本指令跟随能力,CogView4得分是85.13,超过之前DeepSeek开发布的Janus-Pro-7B。

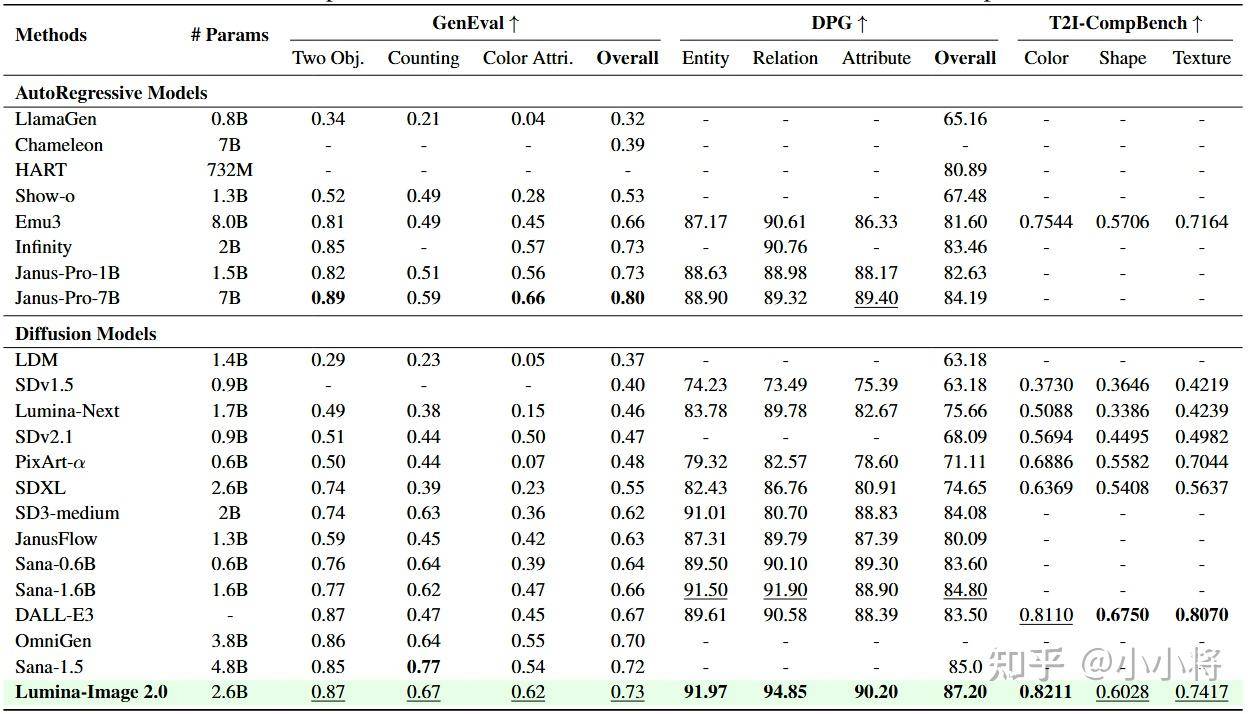

但是很遗憾地说,文生图模型竞争也很激烈,目前CogView4所达到的85.13在DPG-Bench并不是最好的,前段时间NVIDIA发布的Sana-1.5达到了85.0,而开源的Lumina-Image 2.0更是达到了87.2。

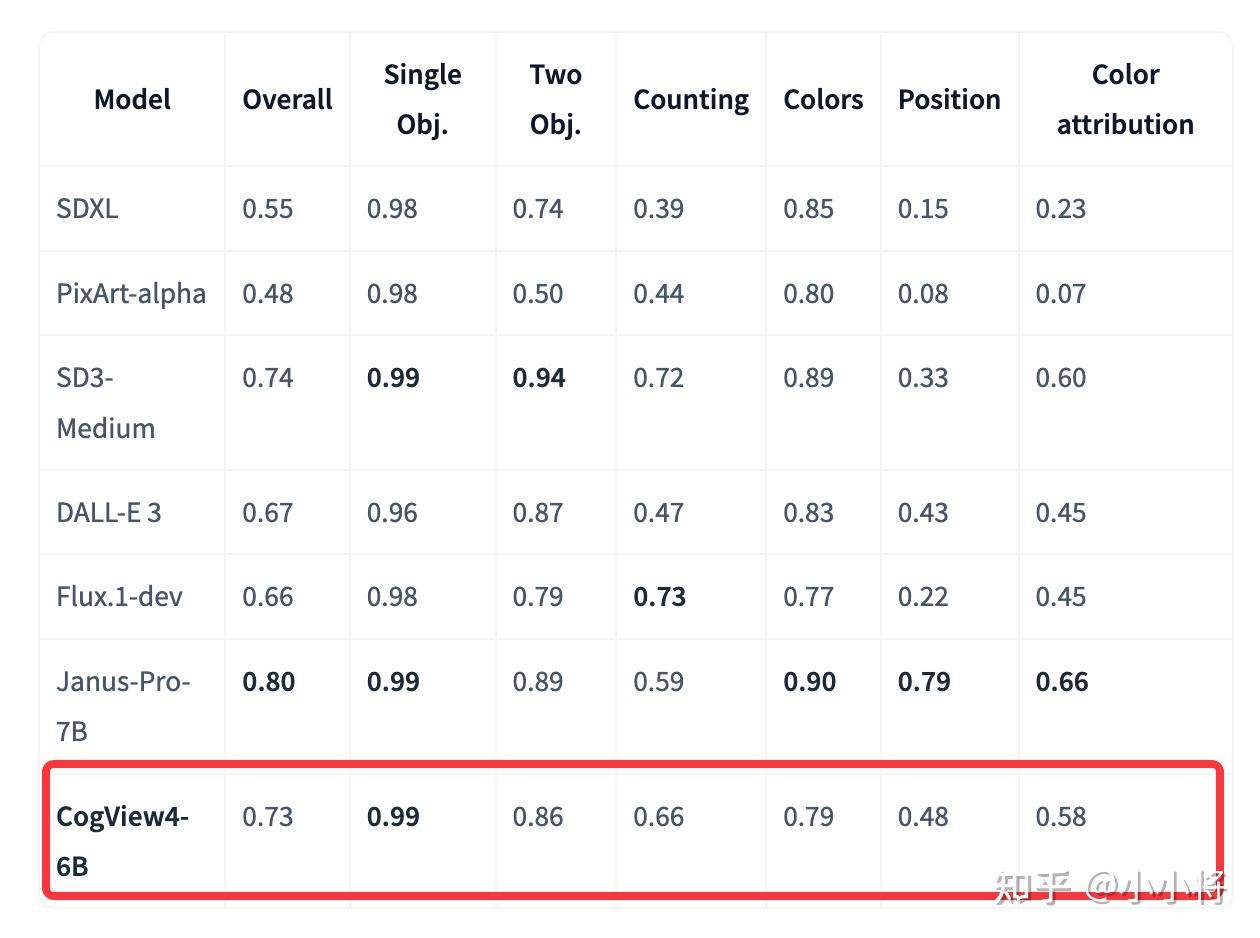

另外除了DPG-Bench,官方还给出了CogView4在GenEval和T2I-CompBench两个基准测试上的性能,其中GenEval上得分是0.73,略低于Janus-Pro-7B,而在T2I-CompBench两个部分取得了最佳。

虽然在基准测试上CogView4并不是真正的SOTA,但是性能其实已经和SOTA很接近了,而且基准测试上的定量评估只能作为参考。我个人觉得CogView4的文本指令跟随能力应该算是第一梯队了。

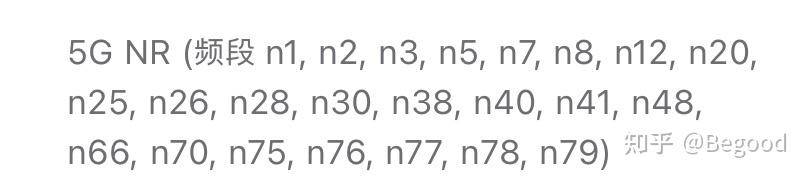

CogView4相比之前的版本,将文本编码器从纯英文的 T5 encoder 换为具备双语能力的 GLM-4 encoder(GLM-4-9B),并通过中英双语图文进行训练,使模型具备双语提示词输入能力。这让CogView4能支持生成汉字,同时也能理解和遵循中文提示词。

虽然CogView4不是首个支持生成汉字的开源模型,但是在文字的生成准确性上超过之前的Kolors。

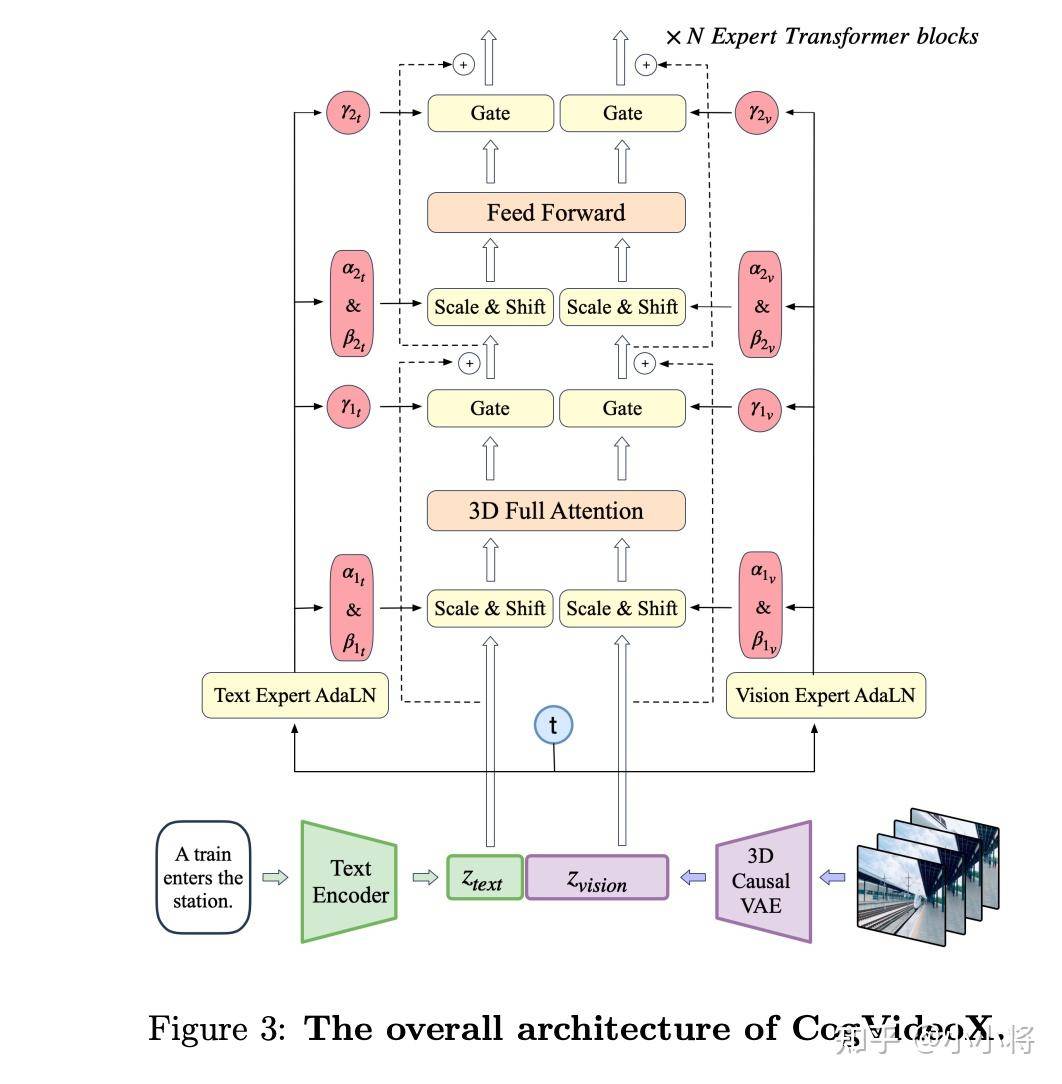

这里我们也简单聊一下CogView4的架构,CogView4也是DiT架构,不过并非MMDiT架构,而是延续了上一代的 Share-param DiT 架构,这里Attention和FFN的参数是文本和图像共享的(比MMDiT更节省参数),但为文本和图像模态分别设计独立的自适应 LayerNorm 层,以实现模态间的高效适配。架构上和CogVideoX是一致的,DiT参数量约6.4B。

生成方法采用Flow Matching,VAE的channel=16,不过参数量为406M,比SD3和Flux的VAE要大不少。文本编码器前面说了,采用的是9B的GLM-4-9B。

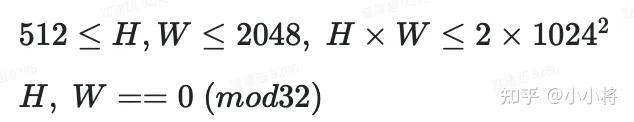

CogView4支持生成512~2048分辨率图像:

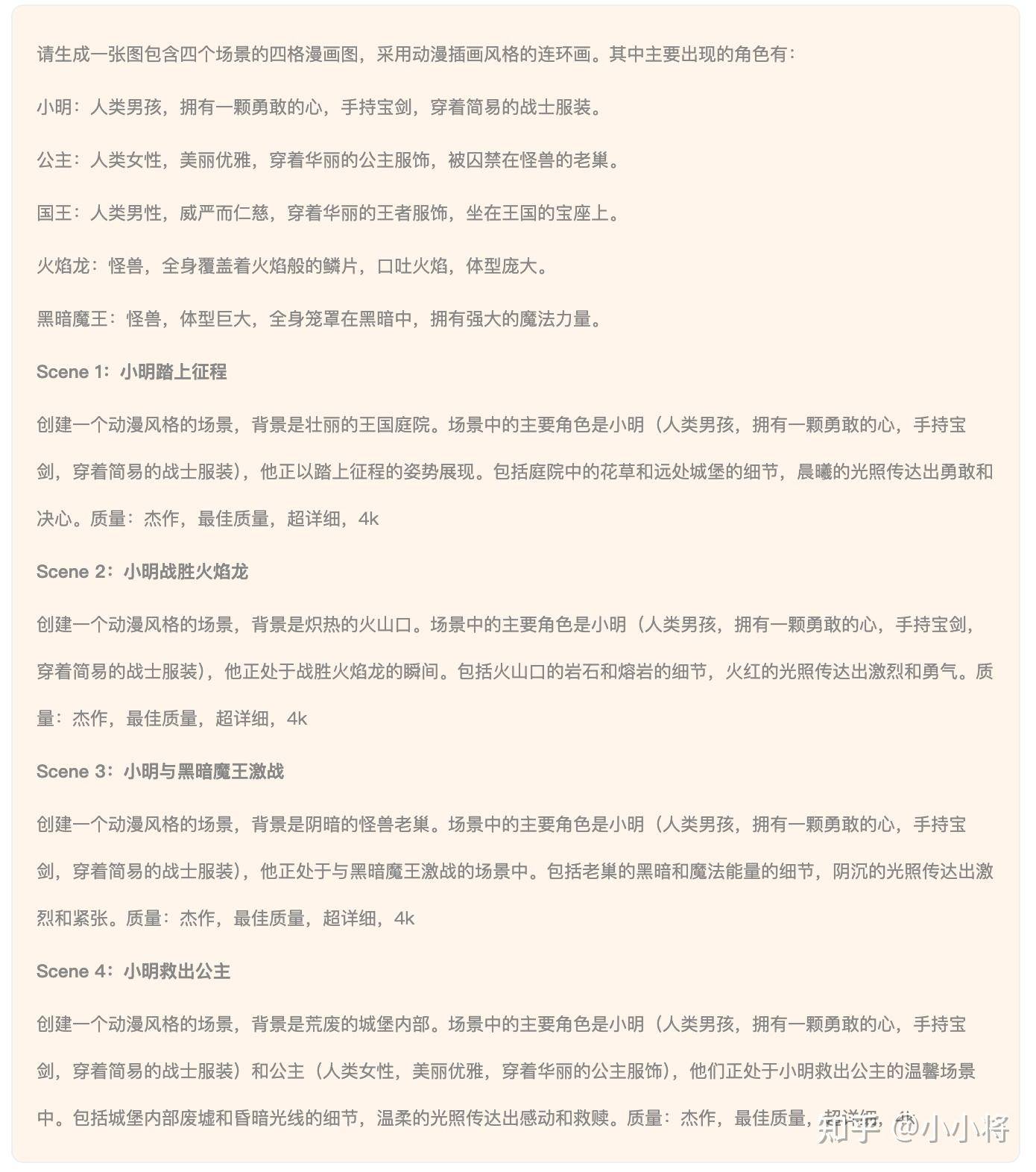

而且CogView4 突破了传统固定 token 长度的限制,允许更高的 token 上限(最长1024 tokens)。下面是一个超长提示词生成的四宫格图像:

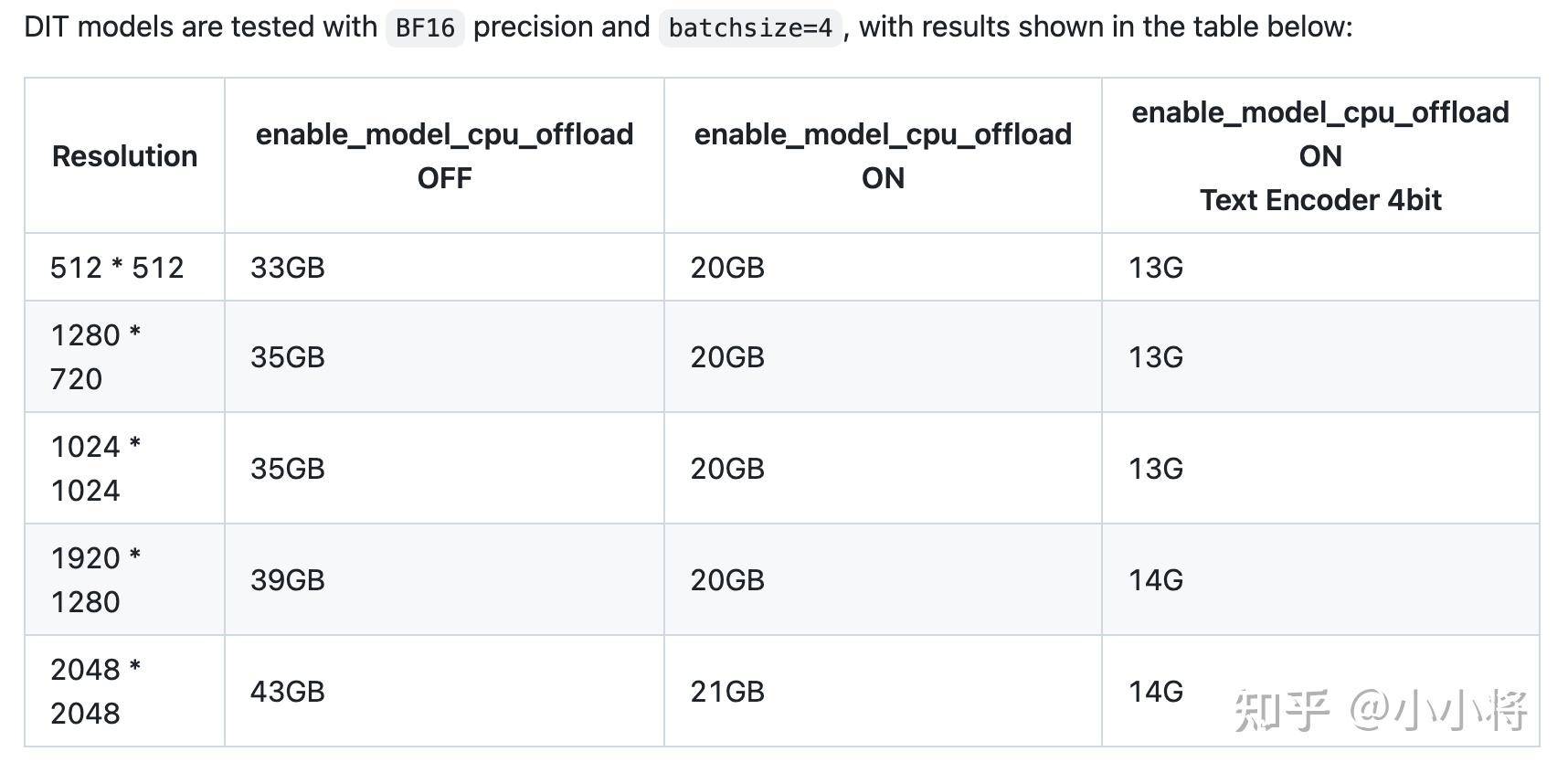

CogView4的推理成本如下所示,采用4bit的文本编码器的话,只需要13GB显存就能生成1024图像。

最后放一些实测的例子,总体评价是画质可以,但文本指令遵循能力弱于Flux。