如何评价RTX2080Ti 22G魔改版?

省流,买,推荐,无他。

2080Ti~22g:目前(2024年12月底),可以找到2400-2500店保一年的,尽量选口碑好的。

这张卡能力均衡,是平民/垃圾佬的Ai神器,同样也是来路不明nv骑士的典范,生产力老手。

大显存,高算力,高带宽,功耗合理,噪音散热可接受,还支持nvlink扩展。在我看来,它的唯一缺点就是Turing架构有一丢丢老了,但比volta又要好一丢丢。至于矿不矿反而不重要。

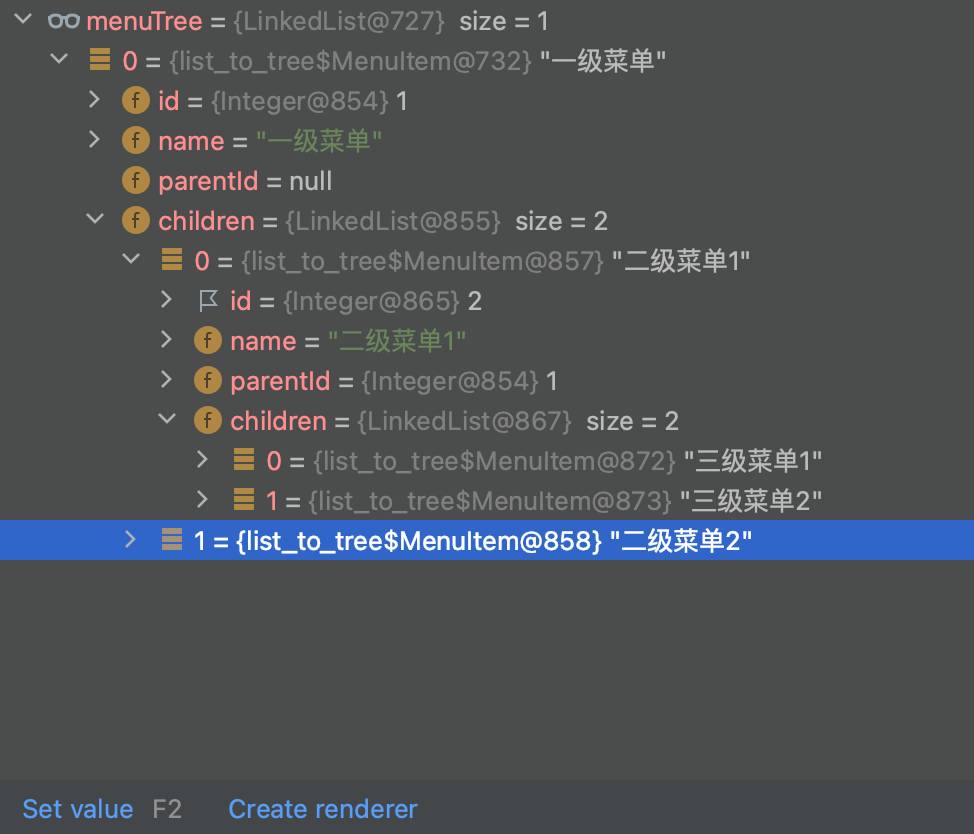

到手验证,一般是压测,比如甜甜圈、gpu-burn,备选cuda-samples、mlperf,以及跑你的目标任务,验证工况下功耗散热稳定性,以及噪音容忍度。

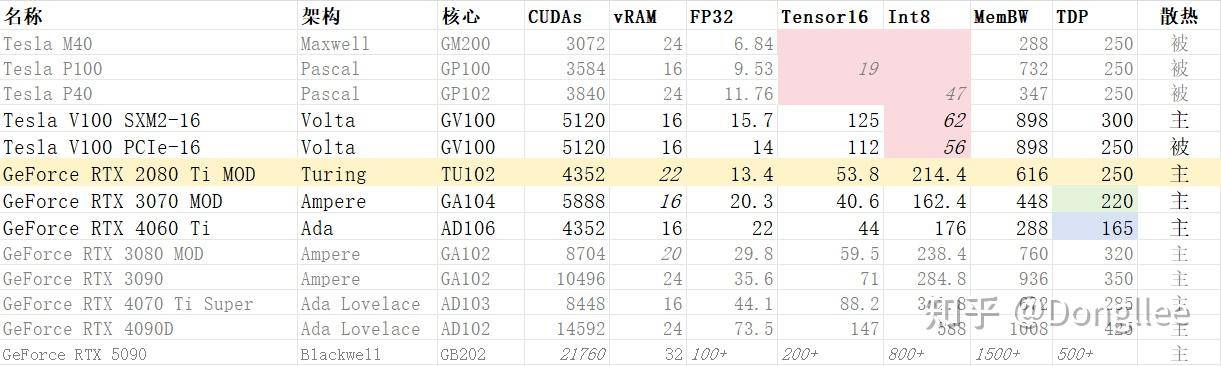

2500附近的同一价位,能买到:

V100-sxm2-16g~PCIe(转接卡,训练向)

V100-pcie-16g-定制(核心搬板,训练向)

2080Ti~22g(显存扩容,训练推理兼顾)

3070~16g(显存扩容,推理日常兼顾)

4060ti-8g(16g要捡漏,推理日常环保)

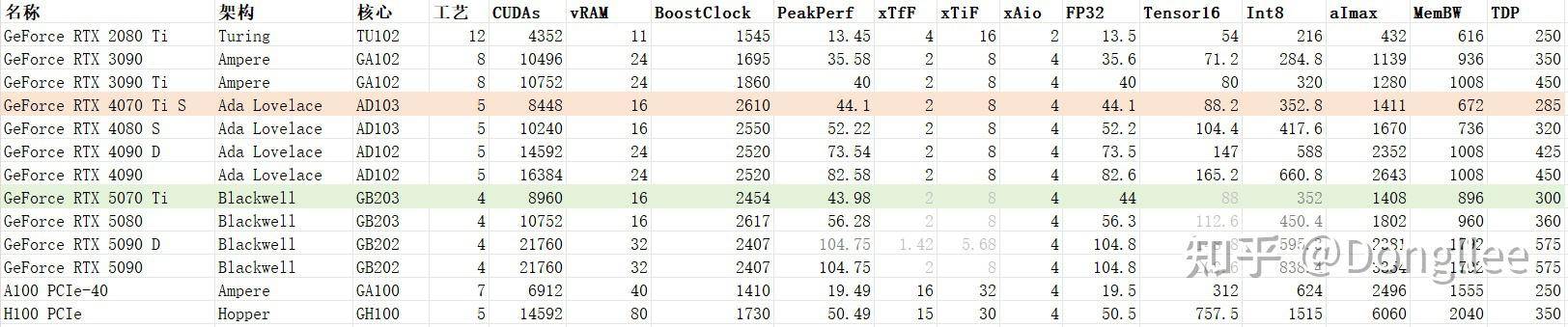

性能参考:

深度学习我觉得关注这么些参数就足够了。但要说性价比大多数新卡(主要是专业卡和数据中心卡)费拉不堪。

我认为,深度学习的生产力提升关键在于混合精度训练(mixed-precision-training)和低精度推理。放弃pascal及以前任何没有tensor core的加速卡。除非你有非常明确的目标,比如依赖显存大小的传统单精度计算,并且有严格的预算,才考虑p100/p40。

V100可以提供超越3090/4080的混合精度算力,适合深度学习训练,但因为volta作为最初代tensor core,不支持int8/int4加速,量化推理没有优势。

⚠️从CUDA 12.8开始,英伟达官方不再对maxwell(cc 5.2/5.3)、pascal(cc 6.0/6.1)、volta(cc 7.0) 提供更新,它们被标记为过时架构,选择时需要评估。

2080Ti~22g,特点如前,推荐。精度不支持tf32/bf16/fp8/fp4,库不支持flash-attn:2+,影响需要根据实际研判。

T10-16g x2,小众思路,T4平替。单宽全高全长,150w供电,被动散热,TU102支持nvlink,纸面算力和2080类似,没具体接触,不详评。(添加于25年2月初,感觉deepseek-r1使这块卡价格探底回升)

3070~16g或者择机捡漏上4060ti-16g,更适合入门选手,什么都想试试,推荐新架构。这个价位上目前还能买到A2,但只有3050的性能明显不太够看。

Ampere和Ada架构相比Turing的优势,一是工艺改进带来的能耗优化,二是支持更多的数据类型在tensor加速,比如bf16甚至fp8,附带就是flash-attention(2+)依赖硬件架构,这些改进都足够面向未来。

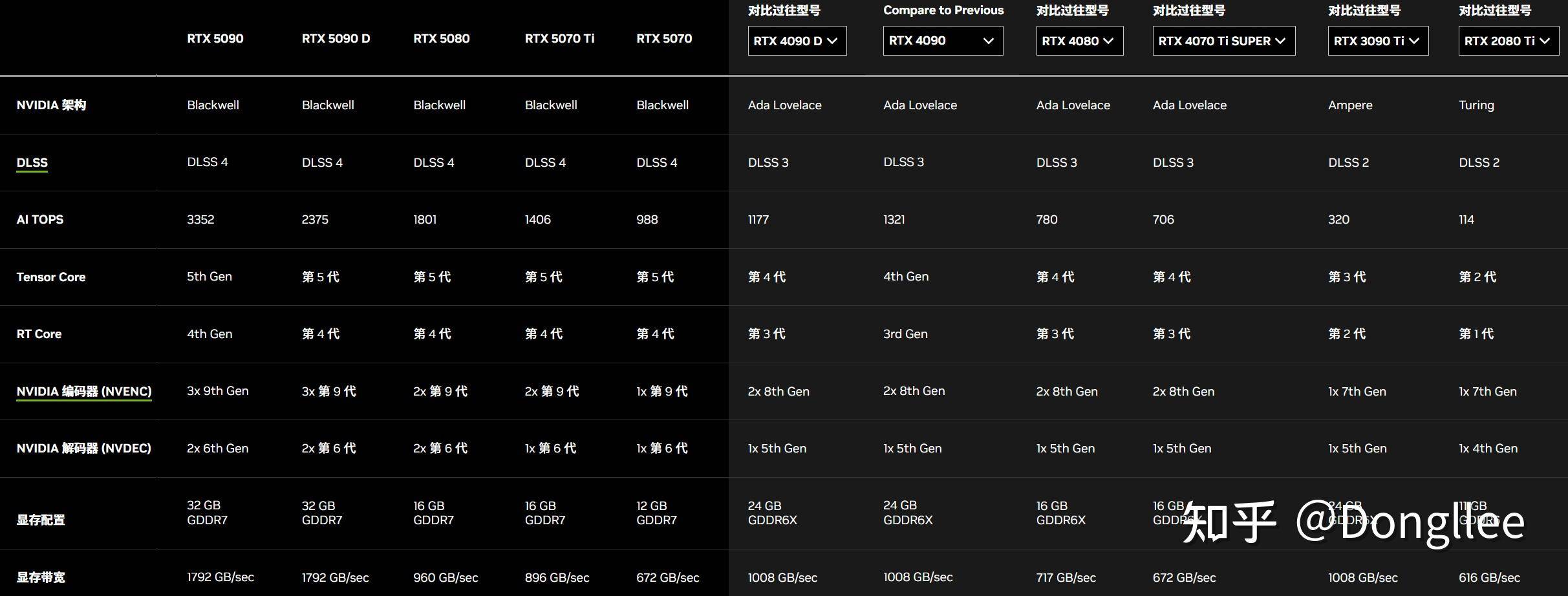

25年初,补充一点关于Blackwell架构50系消费级显卡的信息,新架构进一步支持更低精度的FP4加速,新的架构/技术对游戏友好,可以关注16G入门卡,比如还没发布的5060Ti,但提升可能极其有限。

下表的图是1月初根据发布会推测,白皮书来了(nvidia-rtx-blackwell-gpu-architecture),看了一下,基本正确,不改了。

算力跃升的直接原因是工艺的进步,带来更多的单元和更高的频率,架构的改良更多是在功能特性上反映。

纸面算力:PeakPerf = cuda_FP32 = CUDAs x BoostClock x 2 / 1M(将单位转为Tflops)

Tensor算力可以笼统理解为纸面算力乘上一个系数,这个系数不同系列产品线略有区别。

AI算力是老黄ppt的话术,怎么大怎么来,只要言之成理即可。稀疏的INT4/FP4算力可以是单精度(FP32)纸面算力的32倍,从ampere就开始支持,白皮书里也有,但老黄只是按需往ppt上写。

实际算力测试显示,优化较好的gemm可以跑到纸面算力的8-9成,而一般我们的任务不可能只跑gemm,所以能跑到5-6成的算力已经很不错了。

如何去测量本地矩阵乘算力,可以直接在知乎搜「cuda矩阵乘优化」或者「cuda矩阵乘测量」关键字。

关于功耗,TDP可以理解为加速卡满负载稳定运行的平均功耗,而不是尖峰功耗,尖峰功耗可能是TDP的150%,所以要注意电源的选择。

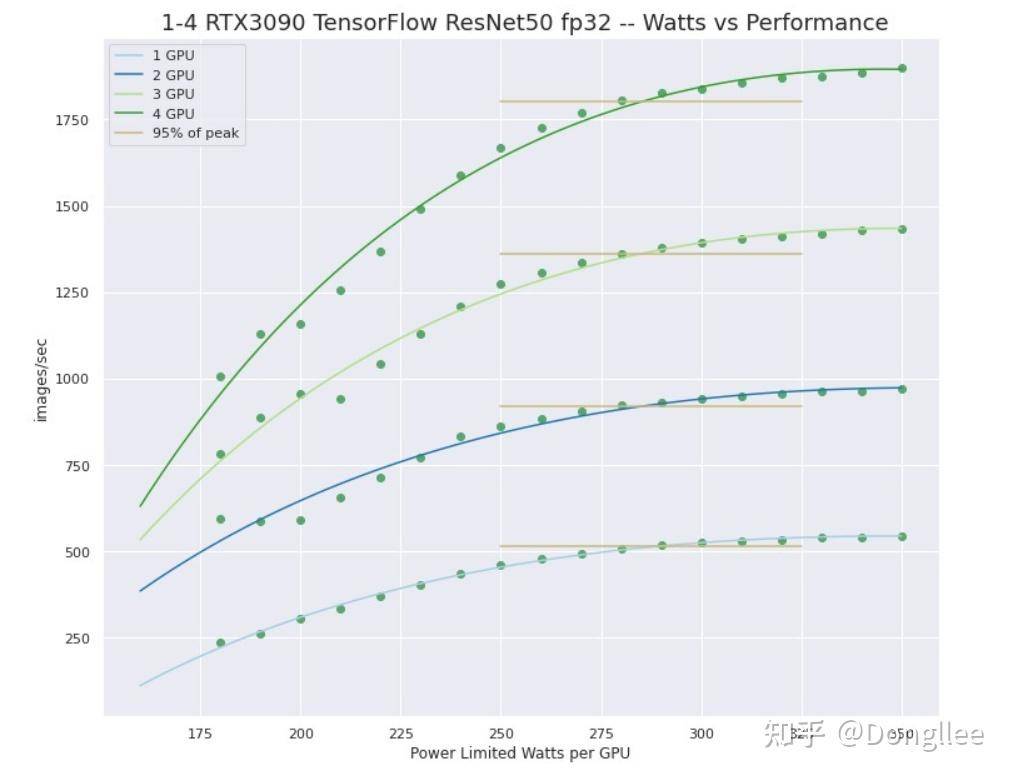

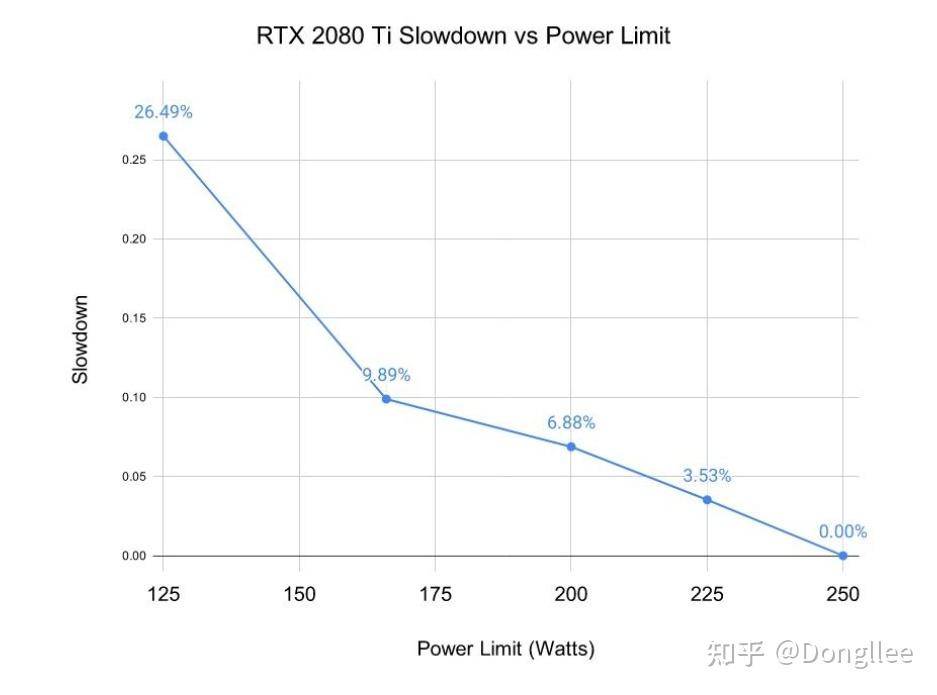

限制功耗也是一种方案,从实测中看到,各代高端消费卡在限制10%功耗时,实际性能(非纸面算力)损失不到5%,限制20%功耗时,实际性能损失不到10%,再限制功耗就会有大于线性性能下降的损失。

具体可以参考以下文章,方法里边有描述。

RTX3090-GPU-Wattage-Limited-MaxQ-TensorFlow-Performance深入研究GPU选型及参数影响,可以参考这篇文章,知乎里边也有翻译版本。

The Best GPUs for Deep Learning in 2023 — An In-depth Analysis要是还想进一步探索关于整机的思路,可以看我之前夏天写的一篇,那个时候刚给朋友装了服务器。

配深度学习主机,预算1.8W,请问各位大佬这个配置如何?