如何看待马斯克宣布新一代大模型 Grok3 将发布,称其为「地球上最聪明的人工智能」?其竞争力在哪里?

我感觉马斯克的 Grok3 走错了方向,或者说,被 OpenAI 带沟里去了。

Grok3 有两个主要特点,第一个是大,10 万张 H100,算力远超其他模型,第二个是合成数据,Grok3 是第一个大规模采用合成数据而非人类数据的大模型。

这两点恰恰是 OpenAI 这两年所犯的最大错误,太信仰规模效应了,这也是被 DeepSeek 追上的主要原因。

模型越大,性能越强,这没错,但大到一定程度,边际效应就会递减。

GPT-3 拥有 1750 亿参数,比 GPT-2 多 100 倍。

GPT-4 拥有 1.8 万亿参数,比 GPT-3 多 10 倍。

GPT-4.5 据说拥有 256 万亿参数(至少达到了百亿级别),比 GPT-4 大 100 多倍。

同样的,除了算力,在数据规模上,OpenAI 每代产品也是几十倍上百倍的提升,一直撞到数据墙,互联网几十年积攒的高质量数据都被消耗殆尽了。

但很明显,从 GPT-3 到 GPT-4.5,大模型性能并没有几十上百倍的提升,说明这条路走不通。

事实上,我们都不用深入研究工程,仅从深度学习的原理上,就不难发现 OpenAI 的问题。

大模型的背后是连接主义,连接主义模仿的是人类大脑。

但人类大脑可不是规模越大越好。

当初生物学家很头疼的一件事,就是解释人类为何比其他动物聪明?

最开始是大脑重量,然后发现大象不比人类差。

后来是大脑重量占比,然后发现黑猩猩也差不多。

再后来是大脑皮层的神经元规模,然后发现蓝鲸比人脑还多。这就尴尬了。

在算力这个层面,人脑并没有特别大的优势。

至于数据层面就更拉胯了,大部分鸟类接收的视觉信息规模都吊打人类。

后来生物学家总算领悟到,人脑之所以强大,核心原因是算法。

人脑有这样几个「超能力」——

1. 长期记忆:人类可以通过睡眠,把海马体的短期记忆转变为新皮层的长期记忆。

长期记忆对于推理(归纳与演绎)的帮助极大。如果你记不住去年的时节气候,怎么可能推演出农耕历法呢。

不过人脑并不是什么信息都转化为长期记忆。人生中只出现一次的现象,大脑不会记忆太久,因为这说明这东西太偶然了,对生存模型没有帮助,只有当一个现象反复出现在各个场景中,大脑才会认为这东西很重要,值得记忆。

这就是为什么提示词写好了很有用,因为提示词就是反复出现的信息。输入越准确,越详细,效果就越好。你直接让大模型写西游记第一章的总结,和把第一章的文本贴给它,然后让它总结,效果是完全不一样的。

2. 思维链:有了长期记忆,人类的推理能力极大加强,可以一步步做归因分析,从而诞生「想象」(即抽象能力与泛化能力)。

人类这项能力是从狩猎中学会的。

追踪猎物可不是件简单的事,需要根据猎物留下的各种痕迹,比如脚印、毛发、血迹、粪便,打斗的残痕,折断的树枝,消失的鸟鸣等信息,来推测猎物可能的动向与反应。

狩猎需要大脑把各种线索串起来,不停的根据追踪过程中的每一个发现,来推断各种可能性,并决定下一步的行为。

DeepSeek 的深度思考就是这个原理。

想训练好一个模型,需要不停的让它思考,消耗 token,而不是直接给答案。

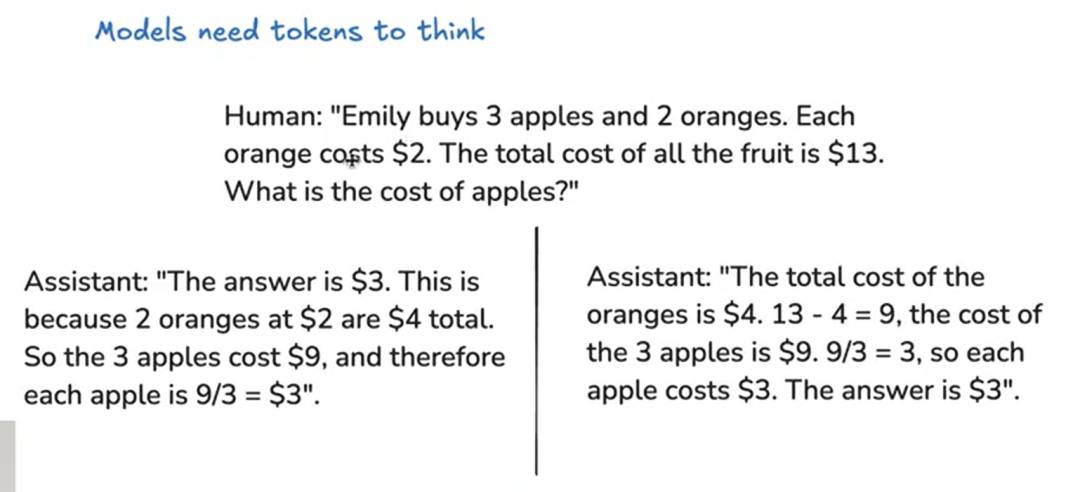

Andrej Karpathy(OpenAI 研究科学家,李飞飞弟子) 曾经举过一个 SFT 示例——

在我们看来,左边效果更好,因为逻辑性强。但在大模型看来,右边效果更好,因为可以先展开思考,最后再对比正确答案。

杨立昆之前不看好 LLM,认为自回归模型都是下意识的回答,没有任何思考,就好比一个小孩背书再好,把全人类的知识背的滚瓜烂熟,那又怎样?你不思考,就不可能诞生智能。

不过等 DeepSeek 出来,他就不说话了,Meta 开始疯狂研究 DS,因为大模型真的会思考。

3. 分层思维:大脑在思考问题时,不会调动所有资源,只是激活少量的相关神经元。

OpenAI 训练 GPT-3,用电量约为 1.287 吉瓦时,ChatGPT 每天消耗超过 50 万度电力,相当于 1.7 万个美国家庭的用电量。

马斯克的 Grok3,大概还要再乘以 10。

大脑呢,大约 10-30 瓦,一个灯泡的用电量。

所以你就知道 DeepSeek 为何如此低成本了,MoE 混合专家模式,堪比大脑节能的方法。

辛顿在 17 年的论文就提出了 MoE 模式(这个思路还可以追溯到更早),可惜没受重视。全世界的 AI 研究者都被 OpenAI 带歪了。

4. 强化学习:人类天生就会强化学习,在与环境的交互中通过试错来学习最优策略。

其实人类也是被逼的,那些不懂得学习的都被自然选择淘汰掉了。

我们教育小孩也用到强化学习。

像机器人那样,直接给小孩写硬规则,比如不许打游戏,九点要上床睡觉,没用,谁搭理你啊,他的基因自发的在反抗。

只有不停的引导孩子,告诉他什么是对,什么是错,并给予相应的奖励或惩罚,从而改变他的观点(权重),影响他的行为(输出)。

某种意义上,训练大模型就是教育孩子。

说实话,我挺奇怪为啥没人早想到强化学习路线。

很多早期投身人工智能的同学,都有被当年 AlphaGo 震惊到,AlphaGo 就是强化学习的典范,尤其是 AlphaGo Zero,没有任何棋谱数据或人类先验知识,仅靠自我对弈就能超越人类顶尖水平。

这说明 AI 不需要海量数据也可以进化。

5. 纠错能力:人脑具备极强的脑补能力,即使接收到了错误信息,也能正确处理。

生物学家曾经做过一个实验,让普通人戴一个上下颠倒的眼镜,刚开始特别不适应,各种失误和跌倒,连最简单的抓取杯子都做不好。

但很快,大脑就自适应了这个眼镜,对人来说,神奇的是世界又恢复正常了,上下和原来一样,做动作毫无影响。只是等摘下眼镜,又混乱了,需要再适应一段时间才能恢复。

我们生活中也经常遇到此类问题。比如一段序顺倒颠的话,读起来毫无困难。

但是有种特殊的情况,大脑无法适应,就是逻辑错误(我们通常称之为认知错误)。逻辑一致性对于生存模型太重要了,非经剧烈的刺激,大脑绝不轻易改变。

比如,我们无法适应与自己认知不一样的世界观,按某些人的逻辑,美国就是最强大的灯塔,怎么可能被中国超越?一定是哪里出了问题,我绝不接受。

这说明什么呢?我想很多 AI 研究者可能还没意识到——

数据内容并不重要,数据结构才是关键。

在思维链中,数据结构决定了推理的质量,而不是数据内容。因为内容错了,神经网络会自动脑补,纠错,但结构错了,会破坏逻辑一致性,让大模型的思考「卡壳」。

Scaling Law 并没有错,但我们对什么是「高质量的数据」,却需要重新评估。

我不看好 Grok3 的合成数据,也是基于这一点。规模没多大意义,质量才是王道。

有意思的是,数据结构其实就是符号主义的思路。

当年皮茨曾预言:「在我们面前有两条通向智能的路径,一条是模拟人脑的结构,一条是模拟人类的心智,但我相信这两条路最终殊途同归」。

真是一个伟大的预言。

最后,罗里吧嗦的说了一堆,有人可能会问,干嘛要模拟人脑?通向 AGI 又不止这一条路。

说的没错。

不过人脑毕竟是我们接触到的唯一智能,看得见,摸得着,所谓近水楼台先得月,模拟人脑只是技术问题,而其他道路则是方向问题,孰难孰易,不用说了吧。

总而言之,我觉得如今的 AI 研究已经到了一个关键节点,需要研究范式上的转变。OpenAI 曾经引领大家探索,但如今它已经走入了歧途,是时候重新出发了。