如何看Meta最新开源的Llama3.3-70B-Instruct,它和之前的Llama有什么区别?

Meta开源的更小参数规模、更高性能的Llama 3.3(70B)来了。该模型在推理、数学和一般知识等领域达到了最先进水平,并且以更低的成本提供与Llama-3.1-405B模型相当的效果。

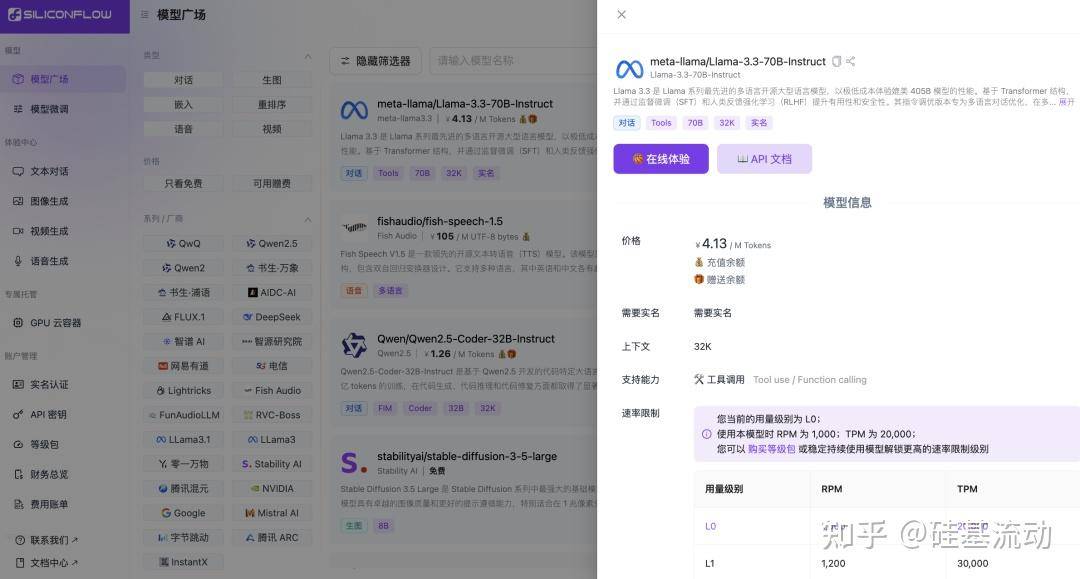

一如既往,SiliconCloud第一时间上线了Llama-3.3-70B-Instruct模型,免去开发者的部署门槛,只需在开发应用时轻松调用API,即可带来更高效的用户体验。平台还支持开发者自由对比体验数十款大模型,为你的生成式AI应用选择最佳实践。

在线体验(需实名)

https://cloud.siliconflow.cn/playground/chat/17885302661

API文档

https://docs.siliconflow.cn/api-reference/chat-completions/chat-completions

直观感受一下SiliconCloud的推理加速版Llama-3.3-70B-Instruct的效果。

模型特点及性能

Llama-3.3-70B-Instruct是一款自回归语言模型,使用优化的transformer架构,该版本使用了监督式微调(SFT)和基于人类反馈的强化学习(RLHF),让其与人类对有用性和安全性的偏好保持一致。

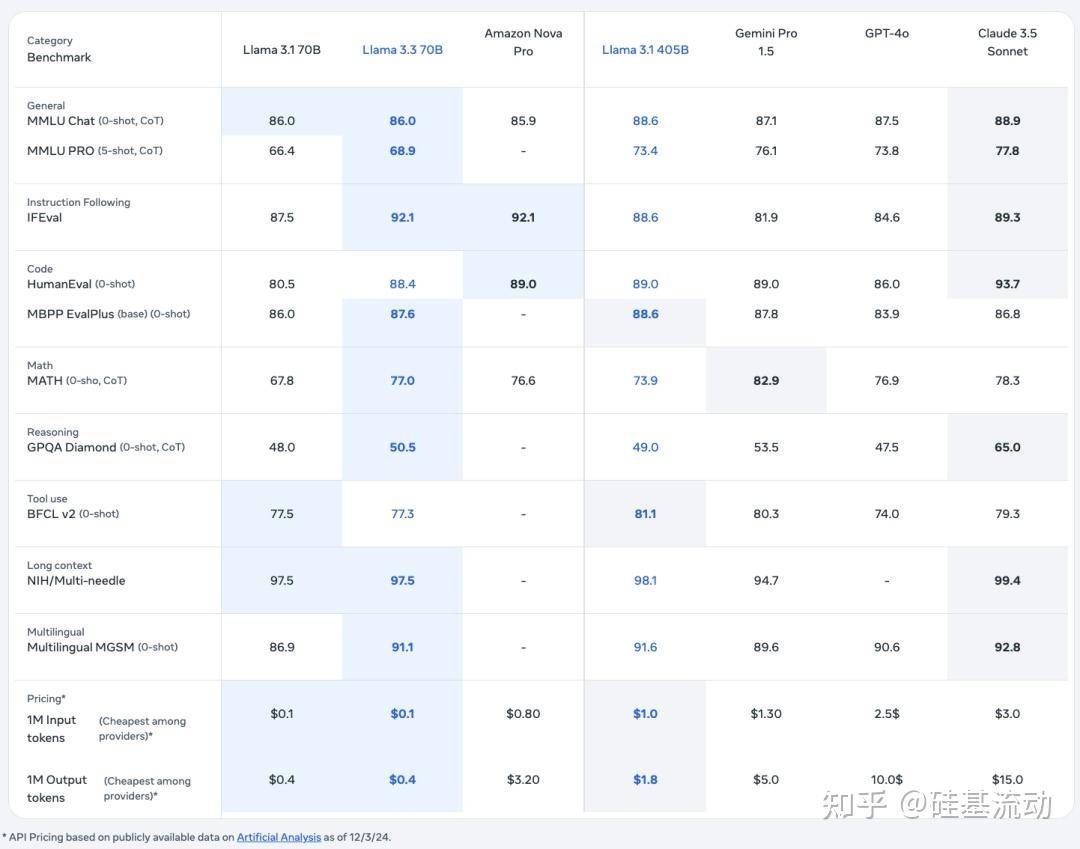

在针对大模型语言理解能力的一系列行业基准测试之中, Llama 3.3 70B的表现优于谷歌的Gemini 1.5 Pro、OpenAI 的GPT-4o和亚马逊本周稍早发布的Nova Pro。

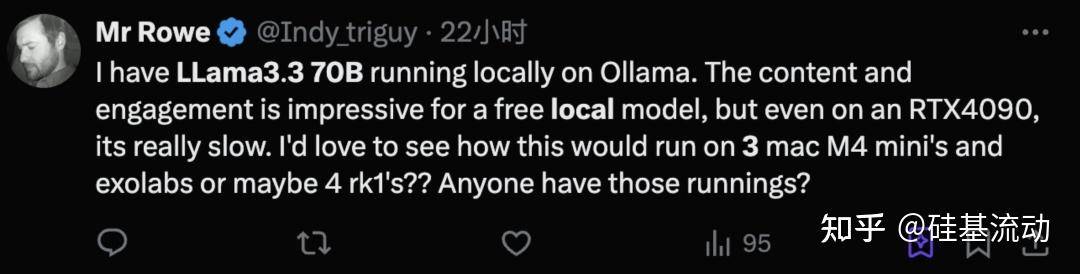

开发者使用体验

Llama-3.3-70B发布后,一些开发者率先进行了体验。有开发者表示,该模型更适合完成工作流的事情。

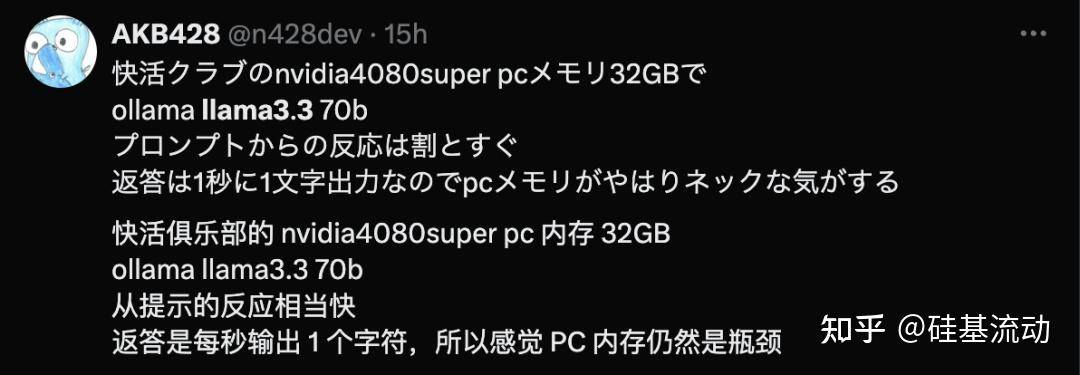

尽管Llama-3.3的输出质量非常不错,但是在本地运行的话响应速度很慢。

另一方面,在本地运行还得需要你有足够的内存。

好消息是,现在通过调用SiliconCloud API使用Llama-3.3,不用再为显存大小与输出速度不够发愁了。

Token工厂SiliconCloud

Qwen2.5(7B)等20+模型免费用

作为集合顶尖大模型的一站式云服务平台,SiliconCloud致力于为开发者提供极速响应、价格亲民、品类齐全、体验丝滑的模型API。

除了Llama-3.3-70B-Instruct,SiliconCloud已上架包括HunyuanVideo、Marco-o1、fish-speech-1.5、QwQ-32B-Preview、LTX-Video、Qwen2.5-Coder-32B-Instruct、Qwen2-VL、InternVL2、Qwen2.5-Math-72B、Qwen2.5-7B/14B/32B/72B、FLUX.1、DeepSeek-V2.5、InternLM2.5-20B-Chat、BCE、BGE、SenseVoice-Small、GLM-4-9B-Chat在内的多种开源大语言模型、图片/视频生成模型、代码/数学模型、向量与重排序模型以及多模态大模型。

其中,Qwen2.5(7B)、Llama3.1(8B)等20+大模型API免费使用,让开发者与产品经理无需担心研发阶段和大规模推广所带来的算力成本,实现“Token 自由”。

让超级产品开发者实现“Token自由”

邀请好友体验SiliconCloud,狂送2000万Token/人

邀请越多,Token奖励越多

SiliconCloud