关于阅读开源项目的源码,有哪些经验值得分享?

作为一个一直对前沿科技满怀热忱、闲来爱琢磨新技术的人,听闻书生大模型全链路开源开放体系时,心里那股好奇劲儿一下就被勾起来了。起初,面对那些高大上的专业术语、琳琅满目的工具框架,脑袋里直发懵,但真一头扎进去摸索一番后,却有了不少意外收获。

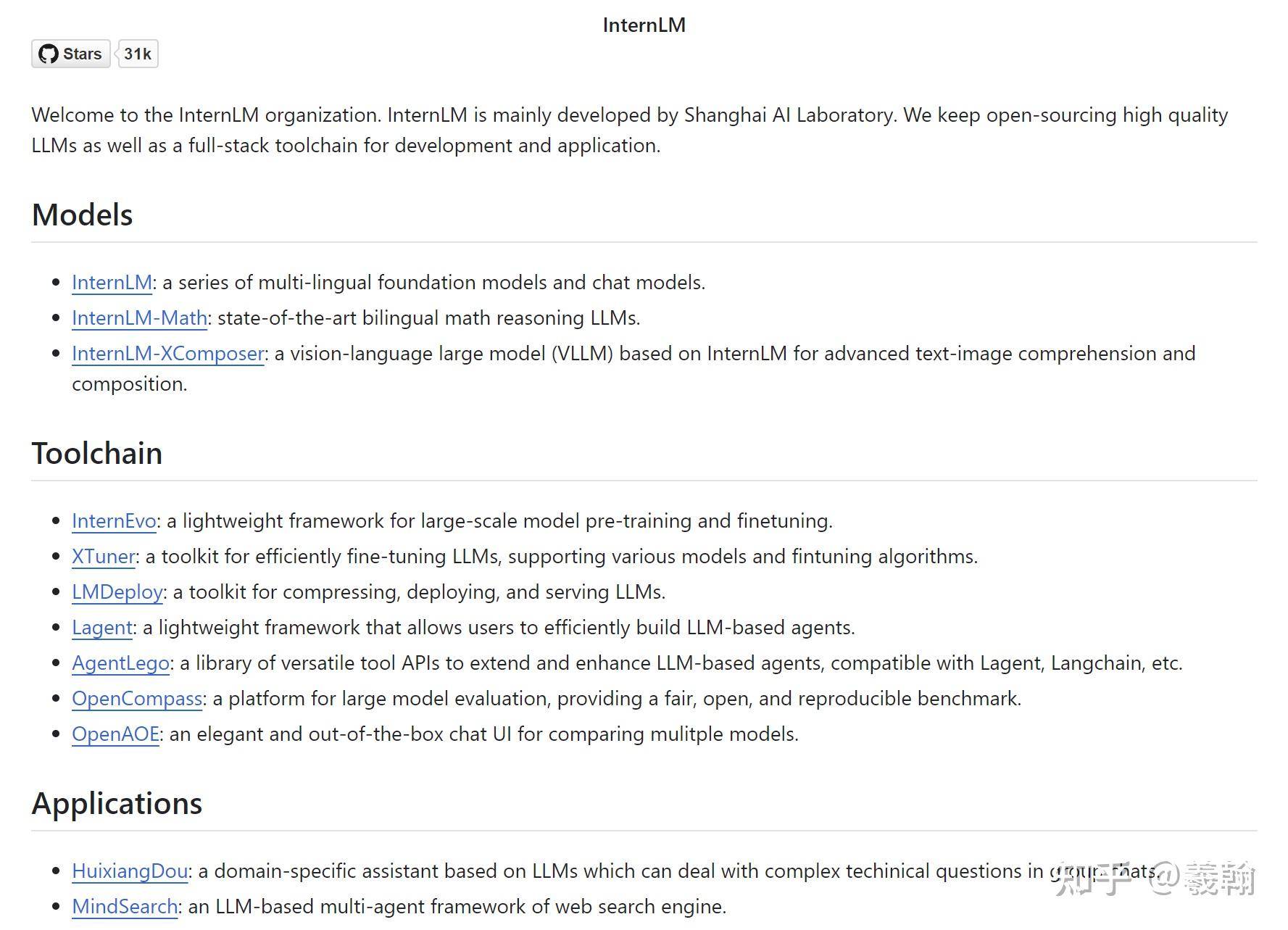

先来认识一下,从InternLM官方介绍中,可以看到模型和工具链工具介绍——

https://github.com/internLM/

可能看起来英文有点难理解,不过官方给到一图看懂这个体系,包括几个维度

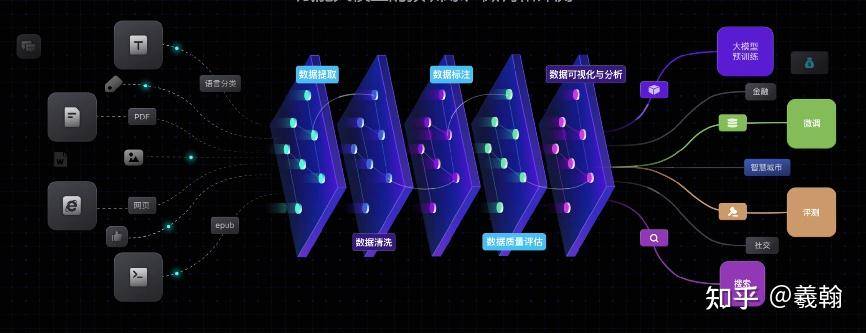

InternLM开源体系构成,包括书生·万卷多模态语料库、预训练框架InternEvo、模型微调工具Xtuner、OpenCompass 评测体系、LLMs 模型部署工具箱LMDeploy、四大应用。

1、书生·万卷多模态语料库

想盖高楼,优质的建材不可或缺,大模型开发也一样,数据就是基石。

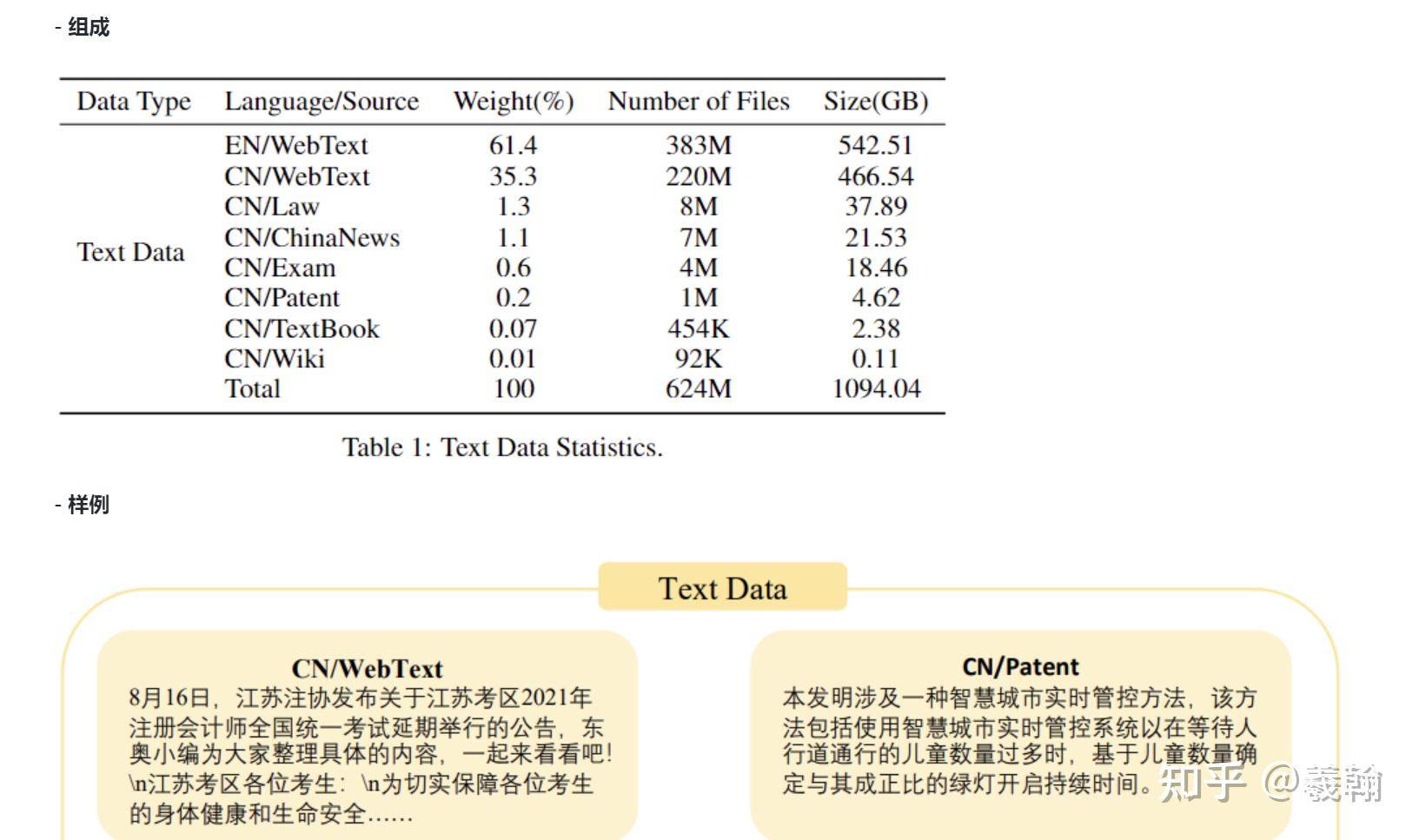

文本数据集 1.0:搜罗网页、书籍、考题等各处精华,超 5 亿文档被洗净杂质、格式规整,变身整齐划一的 jsonl格式,恰似精心筛选、打磨的砖石,稳稳撑起模型知识储备。

https://github.com/opendatalab/image-downloader

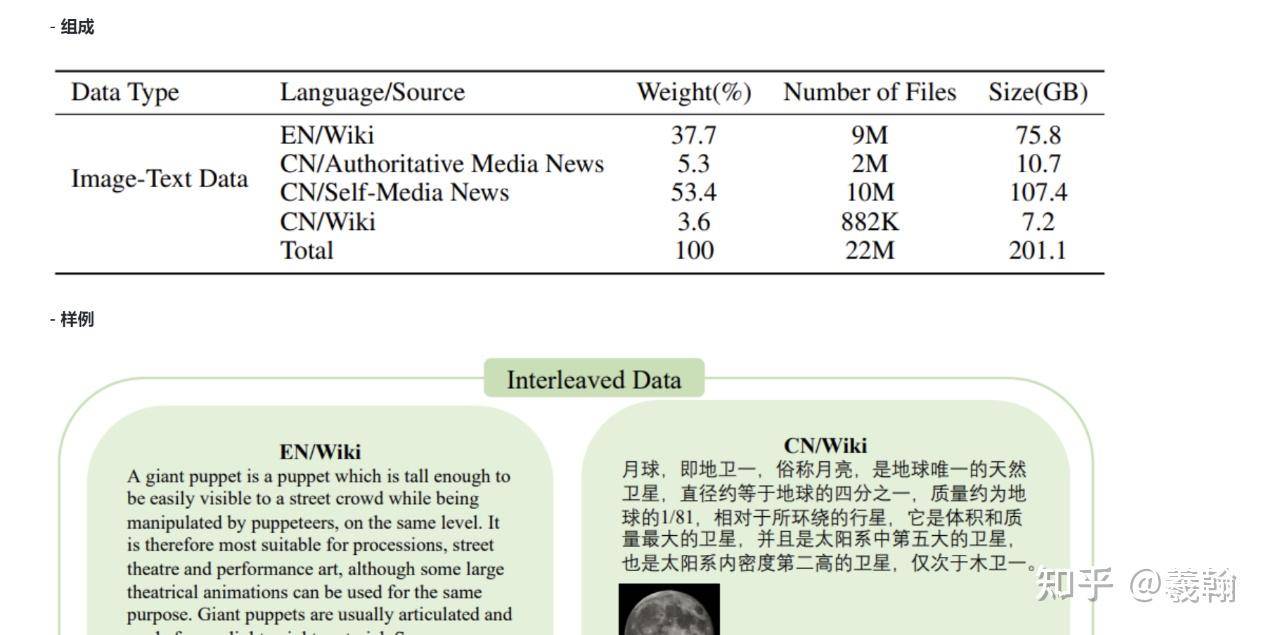

图文数据集 1.0:超 2200 万份图文并茂的文档,源于公开网页,新闻、风景、人物百态尽在其中,图片配 URL,直观鲜活,给模型添几分 “图文并茂” 的巧思,助其理解多模态信息。

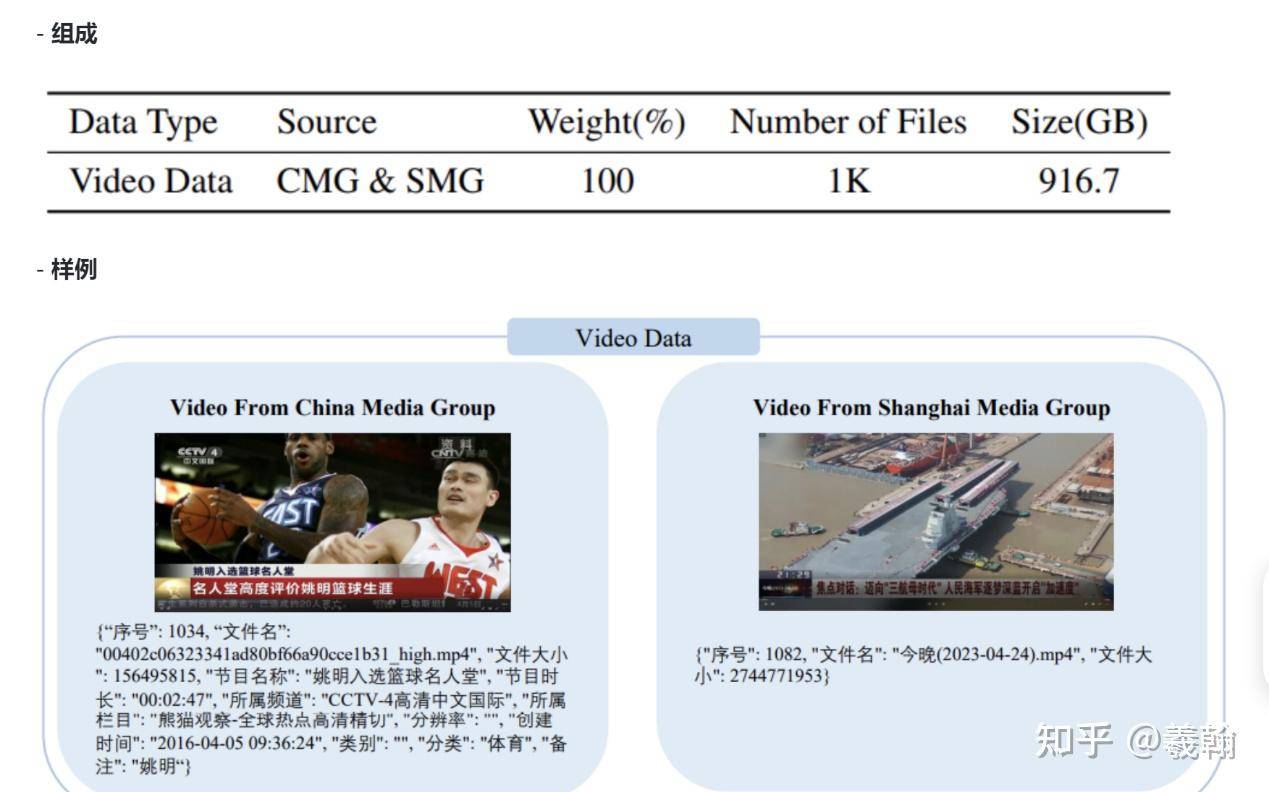

视频数据集 1.0:牵手中央广播电视总台、上海文广,千余个节目影像入驻,文艺、体育、自然、真实世界、知识类、影像艺术纷纷 “入库”,近 1TB 视频资料。

https://github.com/opendatalab/WanJuan1.0

https://openxlab.org.cn/datasets/OpenDataLab/WanJuan1_dot_0

开源数据处理工具箱

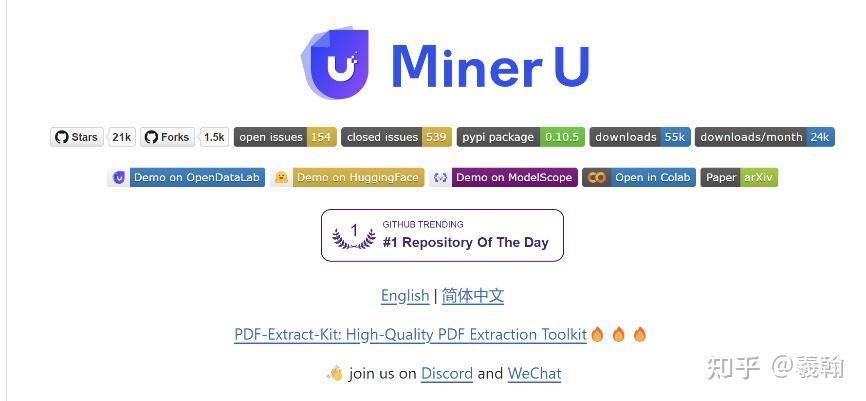

(1)Miner U

一站式开源高质量数据提取工具,将PDF转换成Markdown和JSON格式

https://github.com/opendatalab/MinerU

https://opendatalab.com/OpenSourceTools

(2)Label LLM

开源的数据标注平台

https://github.com/opendatalab/LabelLLM/wiki/README%E2%80%90zh

(3)Label U

https://github.com/opendatalab/labelU

https://opendatalab.github.io/labelU/

OpenDataLab 开源的数据标注工具,支持图片、音频和视频标注

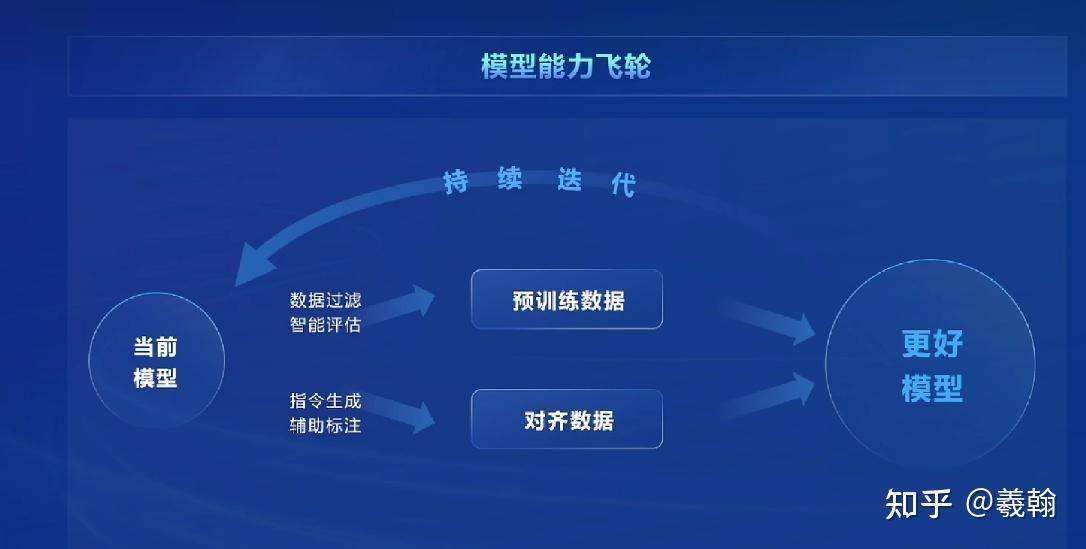

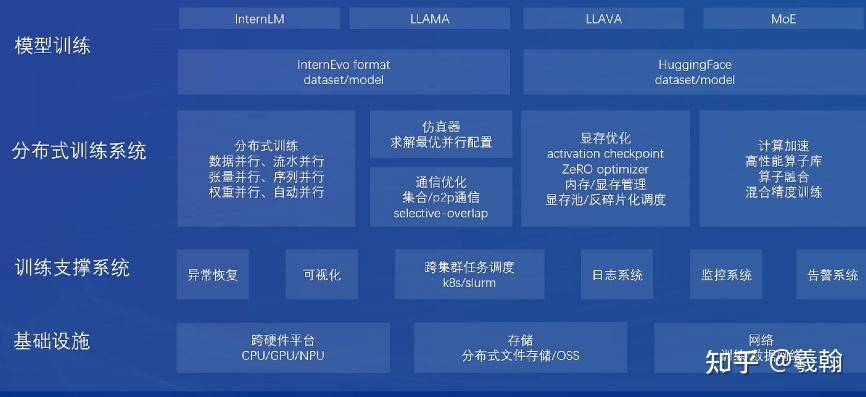

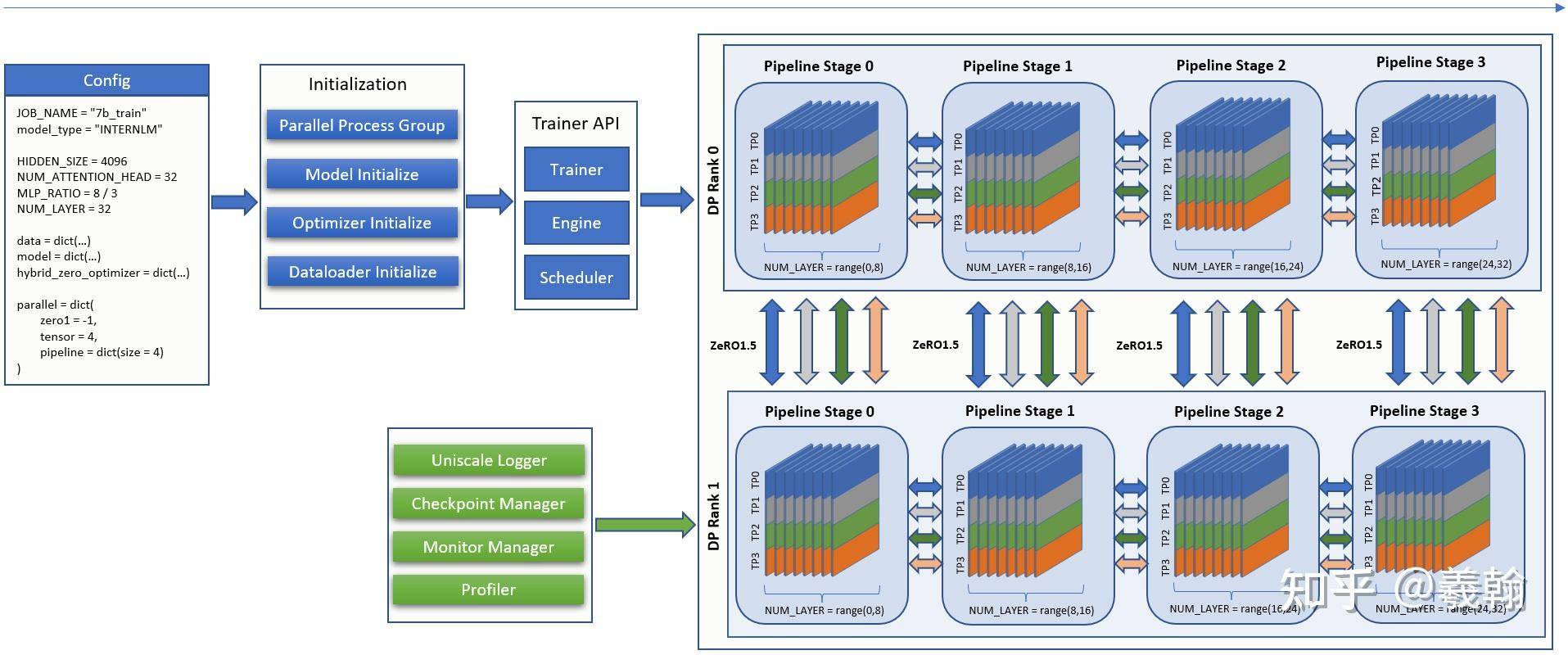

2、预训练框架InternEvo

https://github.com/InternLM/InternEvo

https://internevo.readthedocs.io/zh-cn/latest/?badge=latest

有了好料,得有趁手家伙塑形。InternEvo 担此重任,它是书生体系 “心脏” 般的存在。内置前沿 Transformer 架构优化绝技,能驾驭大规模分布式训练,通用数据海,还是专业领域 “小切口”,都能高效 “锤炼” 模型。

3、模型微调工具Xtuner

模型初成,要适配万千下游任务,得精雕细琢。Xtuner 手持 “微调利刃” 登场,参数高效微调、领域适配策略多样,像个懂行工匠,找准微调 “穴位”。

https://github.com/InternLM/xtuner

模型微调Xtuner工具中文文档

https://xtuner.readthedocs.io/zh-cn/latest/

4、OpenCompass 评测体系

https://github.com/open-compass/opencompass

https://opencompass.org.cn

模型训练微调完,到底成色几何?OpenCompass 给出答案。跑一遍基准测试,自然语言各板块表现尽收眼底,理解有无偏差、生成内容是否靠谱、对话逻辑通不通顺,全被量化打分。

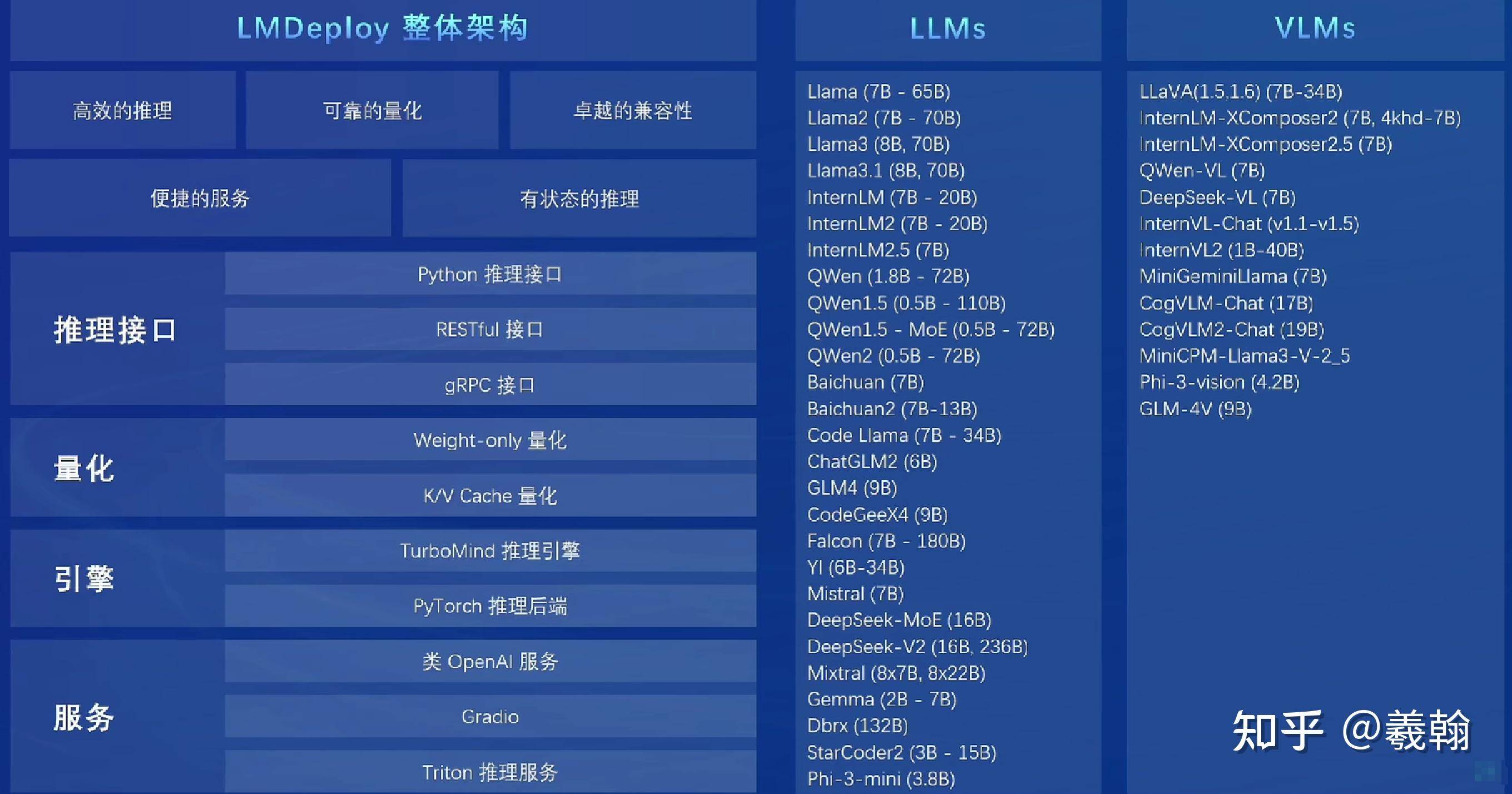

5、推理部署LMDeploy

LLMs 模型部署工具箱,功能涵盖了量化、推理和服务

到了推理部署阶段,LMDeploy 让模型走出 “实验室”,走向多平台。本地电脑测试时,模型加载飞速,量化压缩后,占内存极小;云端部署操作简单,边缘设备上也能稳定运行,物联网小项目里数据实时处理、快速响应。

https://github.com/InternLM/lmdeploy

https://lmdeploy.readthedocs.io/zh-cn/latest/

6、四大应用

(1)MindSearch思索式搜索

打破常规搜索局限,文本、图像、音视频多模态信息一手抓。

https://github.com/InternLM/MindSearch

(2)Lagent智能体框架

模块化组装 “积木”,内置行为、决策工具,打造 “高智商” 智能体,解决复杂场景。

https://github.com/InternLM/lagent

(3)MinerU高效文档解析

解决合同、文献解析难题,精准提炼有价值内容。

https://github.com/opendatalab/MinerU

(4)HuixiangDou专业知识助手

结合学术、科研专长,听懂群内难题,知识库赋能,给出靠谱建议,协同讨论更高效。

https://github.com/InternLM/HuixiangDou

https://openxlab.org.cn/apps/detail/tpoisonooo/huixiangdou-web

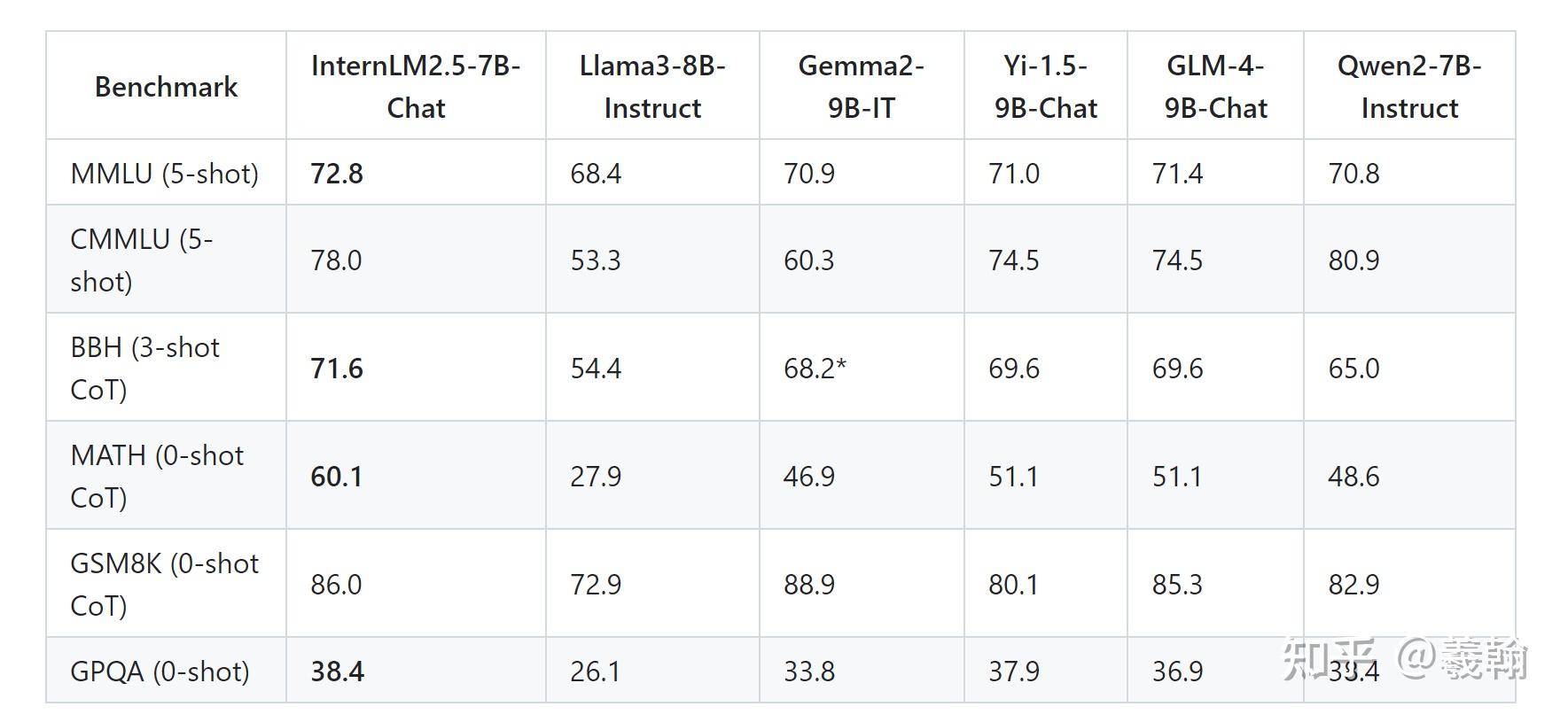

7、模型评分(Chat Model)

在大部分基准测试中,InternLM2.5 - 7B - Chat 表现较为出色,Qwen2 - 7B - Instruct 在 CMLU(5 - shot)测试中得分最高,Gemma2 - 9B - IT 在 GSM8K(0 - shot CoT)测试中得分最高,不同模型在不同基准测试中的表现各有优劣。

https://github.com/InternLM/InternLM

1、MMLU(5 - shot)

MMLU指的是大规模多任务语言理解测试。包含了很多不同类型的问题,涵盖了各种知识领域,比如科学、历史、文学等。就像是给语言模型出了一套超级综合试卷,来测试它对不同知识的理解和处理能力。从模型测试中,可以发现——

- InternLM2.5 - 7B - Chat 得分高,为 72.8。

- Llama3 - 8B - Instruct 得分低,为 68.4。

- 其余模型得分较为接近,Gemma2 - 9B - IT 得分为 70.9,Yi - 1.5 - 9B - Chat 为 71.0,GLM - 4 - 9B - Chat 为 71.4,Qwen2 - 7B - Instruct 为 70.8。

2、CMLU

用来评估语言模型对知识理解能力的测试。和 MMLU 类似,通过给模型提供一些问题,观察它的回答来判断模型的水平。不同的是,它可能在问题的类型或者评估的侧重点上有自己的特点。从模型测试中,可以发现——

- InternLM2.5 - 7B - Chat 再次得分高,为 78.0。

- Llama3 - 8B - Instruct 得分低,为 53.3。

- 其他模型中,Gemma2 - 9B - IT 得分为 60.3,Yi - 1.5 - 9B - Chat 和 GLM - 4 - 9B - Chat 均为 74.5,Qwen2 - 7B - Instruct 最高,为 80.9。

3、BBH(3 - shot CoT)

评估语言模型在复杂推理和思维链(CoT,Chain of Thought)相关任务上的表现。3 - shot CoT 意味着会给模型 3 个相关示例来引导它进行推理回答。它的问题通常需要模型不仅仅是简单地模仿已有的知识,而是要进行更深层次的思考和逻辑推理,比如解决一些需要多步骤推理的问题。从模型测试中,可以发现——

- InternLM2.5 - 7B - Chat 得分高,为 71.6。

- Llama3 - 8B - Instruct 得分低,为 54.4。

- Gemma2 - 9B - IT 得分为 68.2,Yi - 1.5 - 9B - Chat 和 GLM - 4 - 9B - Chat 均为 69.6,Qwen2 - 7B - Instruct 为 65.0。

4、MATH

专门针对数学问题的测试。0 - shot CoT 表示在测试时不给模型示例直接让它回答数学问题。这些数学问题可能包括算术、代数、几何等各个数学领域,通过这个测试可以看出语言模型对数学知识的掌握和运用能力,以及它是否能够进行合理的数学推理。

- InternLM2.5 - 7B - Chat 得分高,为 60.1。

- Llama3 - 8B - Instruct 得分低,为 27.9。

- Gemma2 - 9B - IT 得分为 46.9,Yi - 1.5 - 9B - Chat 和 GLM - 4 - 9B - Chat 均为 51.1,Qwen2 - 7B - Instruct 为 48.6。

5、GSM8K

专门针对数学文字题(用文字描述的数学问题)的测试。同样是 0 - shot CoT,它的问题都是以文字形式呈现的数学题目,比如 “小明有 5 个苹果,小红比小明多 3 个,问小红有几个苹果” 这种类型的问题。通过这种测试可以评估模型对实际生活中的数学问题的解决能力。

- InternLM2.5 - 7B - Chat 得分高,为 86.0。

- Llama3 - 8B - Instruct 得分低,为 72.9。

- Gemma2 - 9B - IT 得分为 88.9,Yi - 1.5 - 9B - Chat 为 80.1,GLM - 4 - 9B - Chat 为 85.3,Qwen2 - 7B - Instruct 为 82.9。

6、GPOA

利用人工智能技术来优化和自动化测试过程的一种测试。包括自动化测试案例的生成、测试执行的自动化、智能数据分析、结果的预测的能力。

各模型得分较为接近,其中 InternLM2.5 - 7B - Chat 得分为 38.4,Llama3 - 8B - Instruct 为 26.1,Gemma2 - 9B - IT 为 33.8,Yi - 1.5 - 9B - Chat 为 37.9,GLM - 4 - 9B - Chat 为 36.9,Qwen2 - 7B - Instruct 为 38.4。