DeepSeek 服务再次宕机,造成了什么影响?

DeepSeek 宕机有何关系,本地部署跑起来!

这届网友太猛了!DeepSeek刚出道就被玩成了"AI界春运现场",我昨晚想试试春晚中问些问题,结果突然发现

好家伙,这泼天的富贵直接把服务器干趴了!

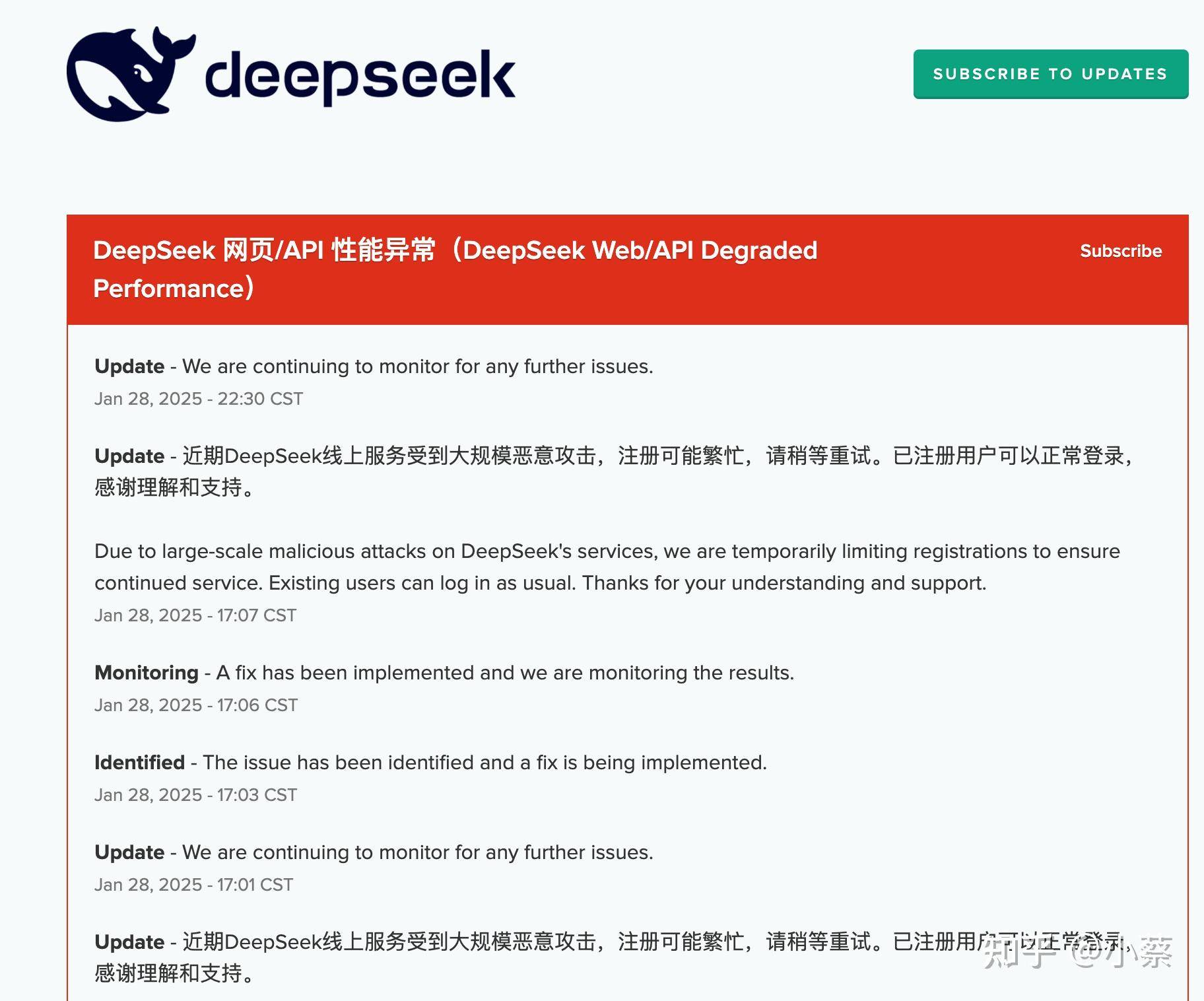

看个公告才发现,原来是遭到了恶意攻击,果然眼红的人过年也不放假。

好在老司机我早有准备,连夜整理出使用秘籍,从白嫖API到本地部署全都有,甚至能在手机上跑模型!

紧急通道:重试、API 与海外网站

| 方案 | 响应速度 | 隐私性 | 成本 | 适合人群 |

| 官方网页版 | ⚡️⚡️⚡️ | ❌ | 免费限额 | 佛系用户 |

| API直连 | ⚡️⚡️ | 几分钱/次 | 技术博主 | |

| 本地部署 | ⚡️ | ✅ | 电费 | 极客/隐私控 |

| 第三方平台 | ⚡️⚡️⚡️ | 免费 | 魔法师 |

第一招,当然是无限重试战术

虽然等来的可能是无休止的转圈,但总有一次能成功。

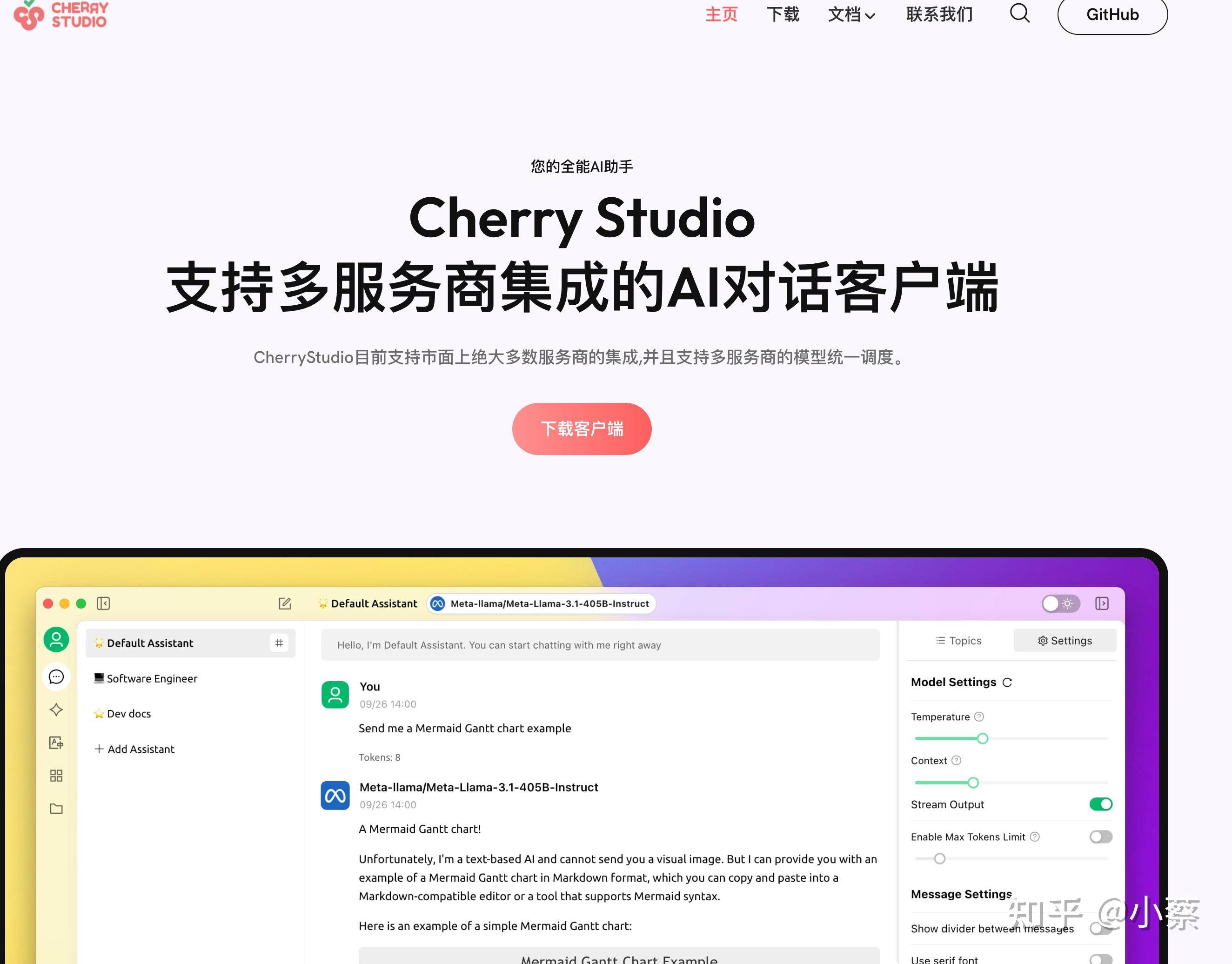

第二招,暗度陈仓:API + 本地对话软件

官网后台申请个密钥,20块钱够你用到ChatGPT-5发布!

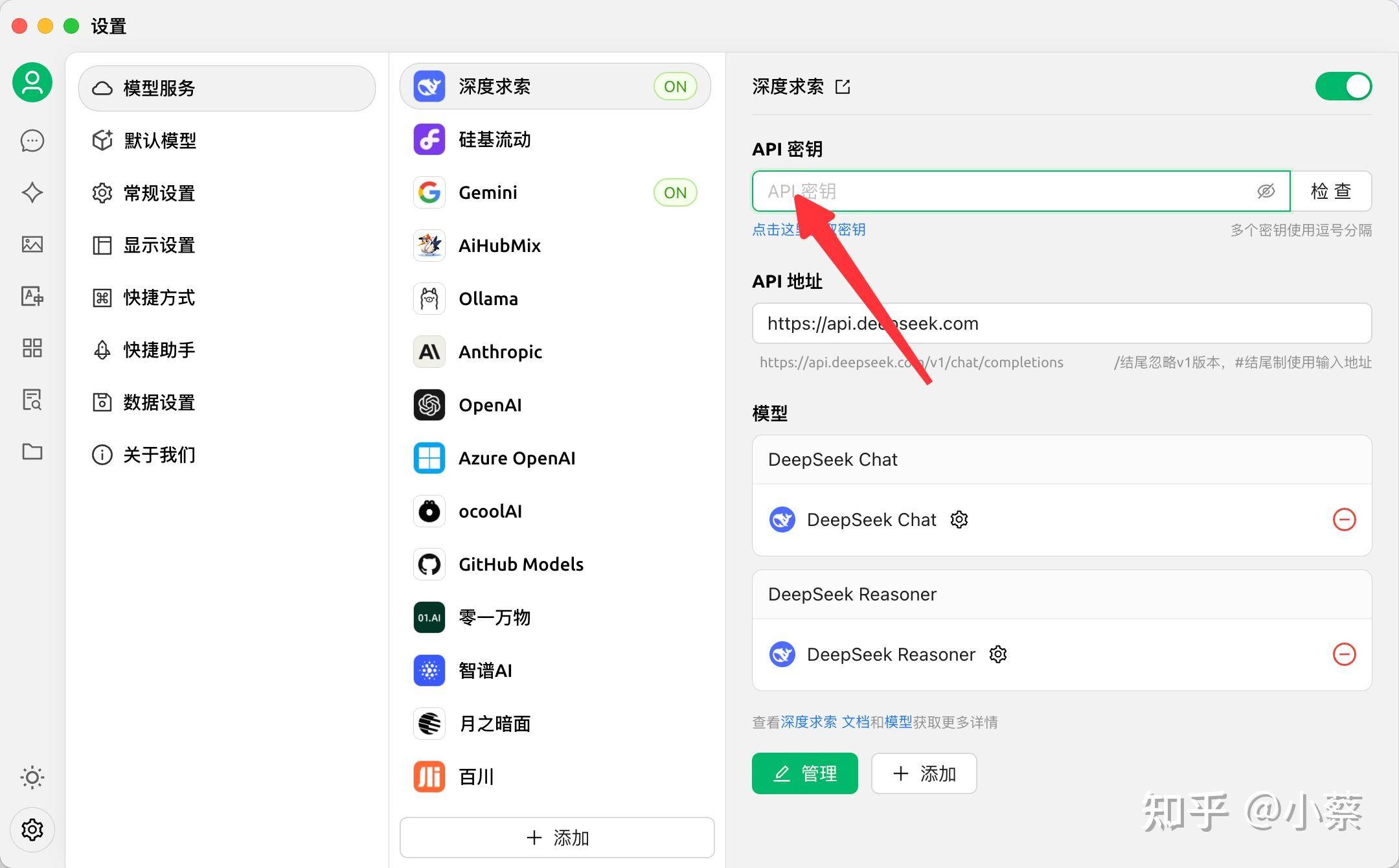

搭配开源客户端CherryStudio,直接把网页版踹进冷宫

下载地址:https://cherry-ai.com/download

下载后只需要把 api 放到设置里,开启模型即可

第三招:白嫖海外发展科

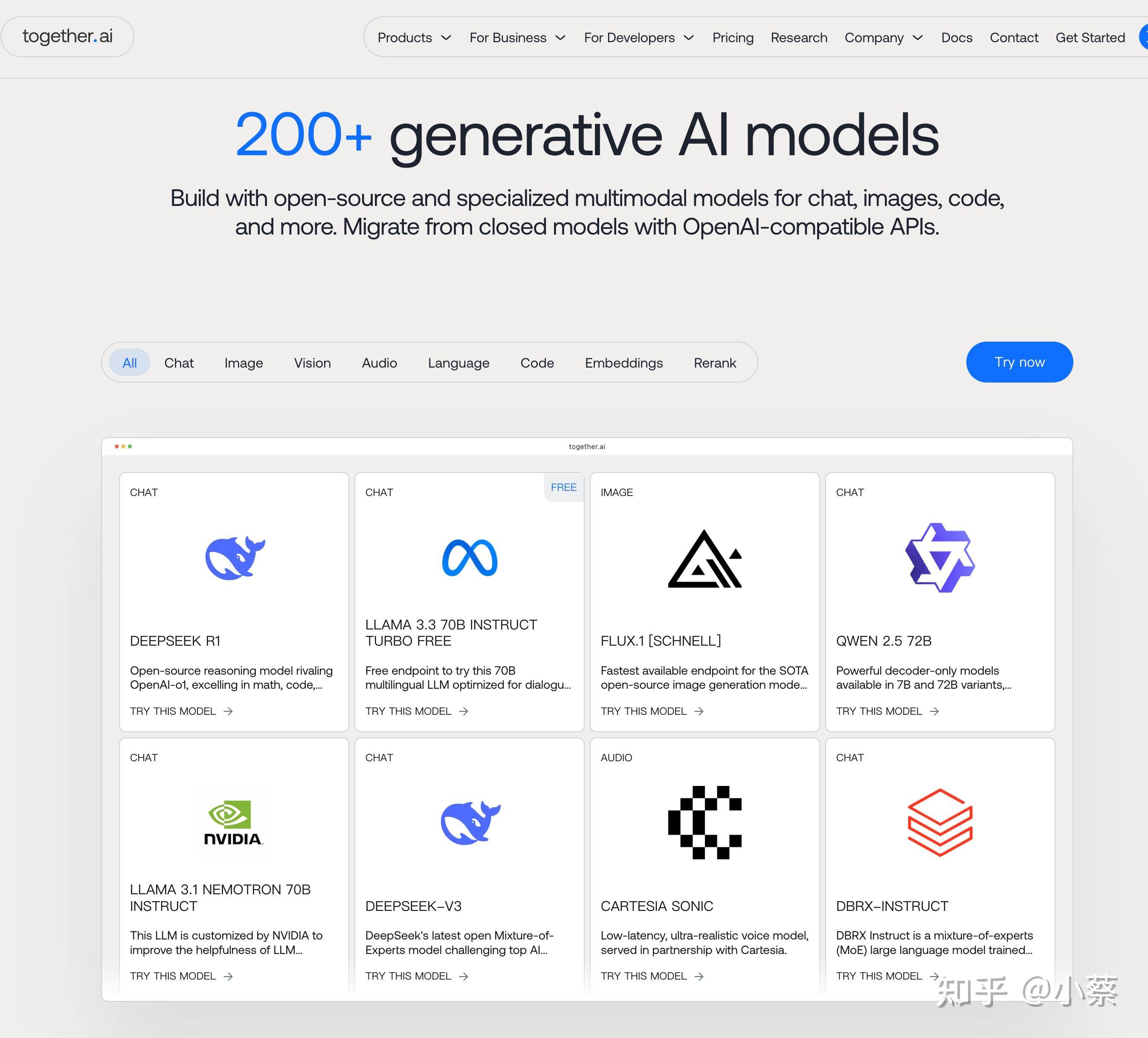

使用Together AI,白嫖2小时/天的云端R1!实测响应速度比官网还快,懂的都懂

地址:https://www.together.ai/

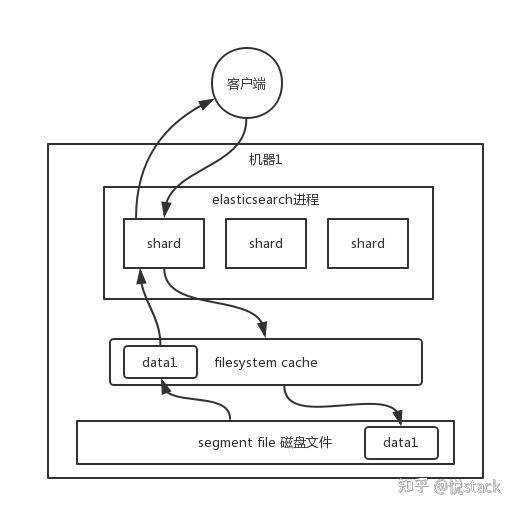

终极方案:把DeepSeek装进电脑

当全网都在抢服务器时,你可以把 DeepSeekR1 下载到本地电脑里,用电脑部署!

下面教你五分钟部署方法,非常简单:

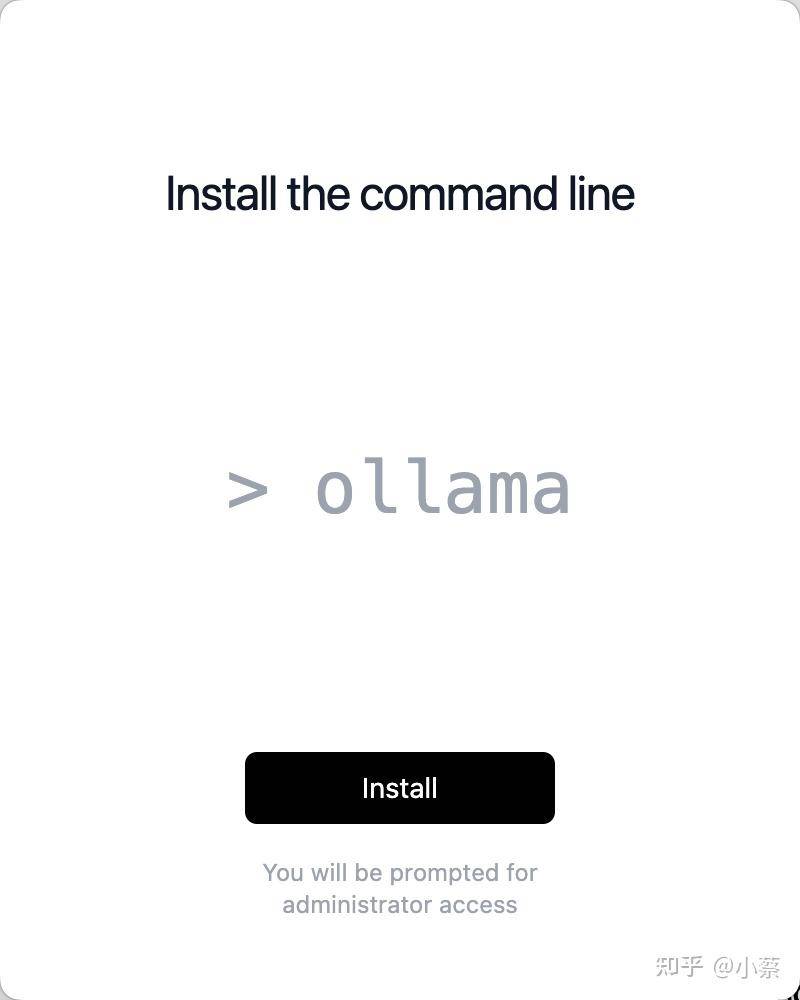

下载 ollama,安装大模型

地址:https://ollama.com/

安装完成后,你的电脑会成功安装ollama指令。

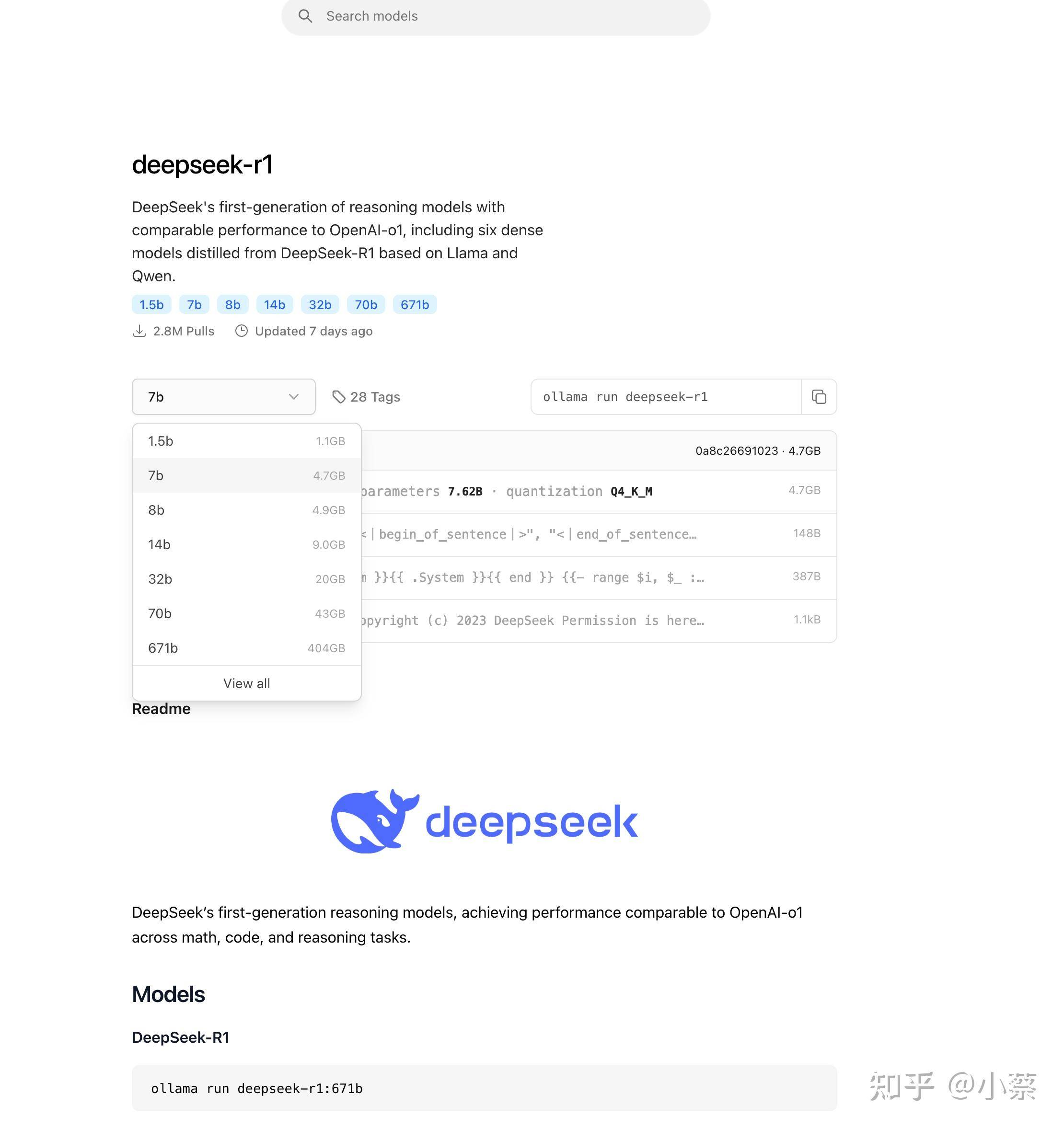

接下来我们需要下载模型

可以看到,DeepSeek 的R1 模型有很多种,要求越高的能力越强,可以根据本地配置来决定下载哪一个。

地址:https://ollama.com/library/deepseek-r1

模型对比如下:

| 模型 | 安装命令 | 显存建议(量化版) |

| 1.5B Qwen DeepSeek R1 | ollama run deepseek-r1:1.5b | 4GB+ |

| 7B Qwen DeepSeek R1 | ollama run deepseek-r1:7b | 8GB+ |

| 8B Llama DeepSeek R1 | ollama run deepseek-r1:8b | 8GB+ |

| 14B Qwen DeepSeek R1 | ollama run deepseek-r1:14b | 12-16GB |

| 32B Qwen DeepSeek R1 | ollama run deepseek-r1:32b | 24-32GB |

| 70B Llama DeepSeek R1 | ollama run deepseek-r1:70b | 48GB+ |

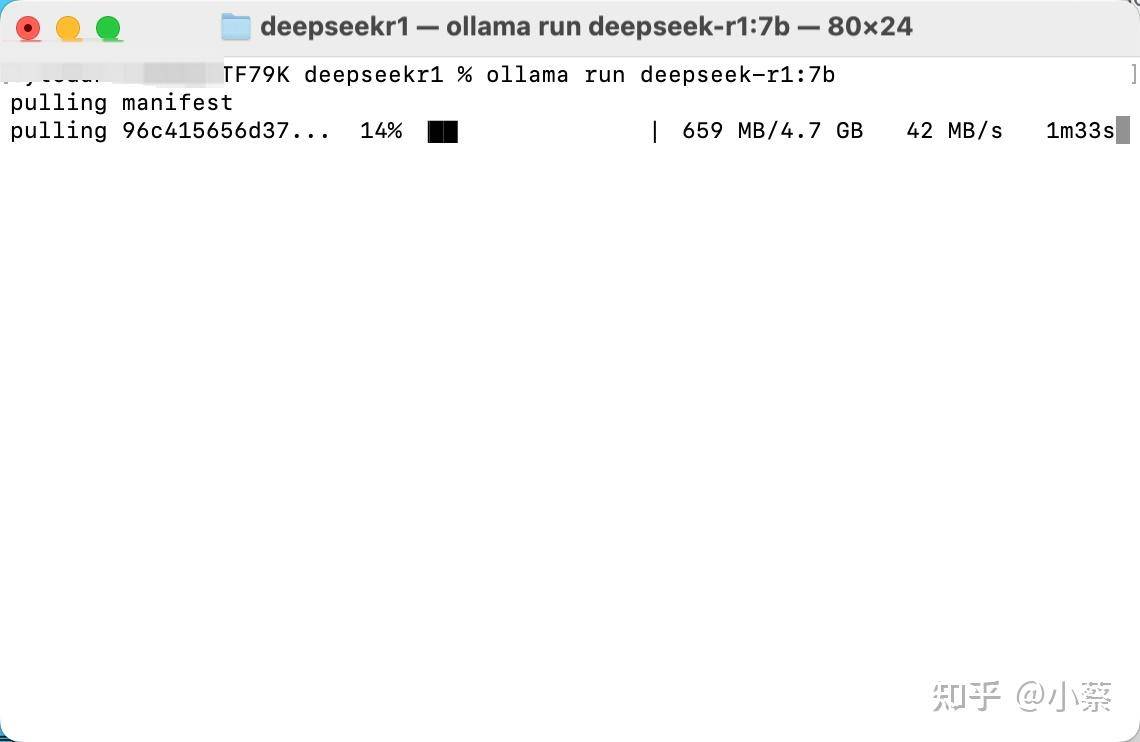

选好模型后,打开控制台即可安装。

在 mac 中,控制台叫终端。在 Windows 中,叫 powershell。如何打开,可以简单搜索下就知道啦。

安装完成后,本地部署就完成啦。你可以直接在终端中开始对话了!

当然,在终端中对话非常不优雅,我也不想一直打开终端,怎么办呢?

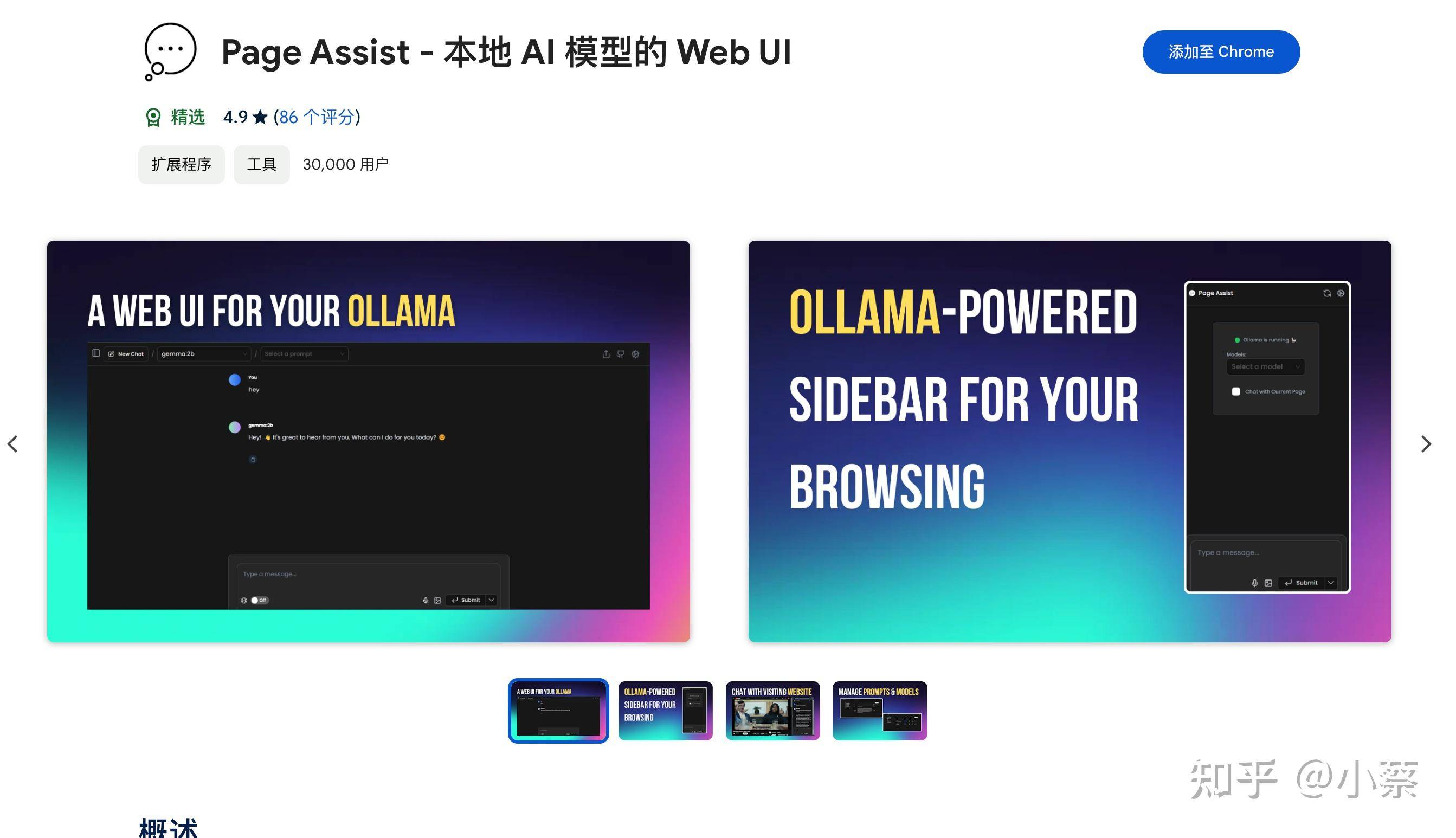

接下来可以借助一个 webui 来让我们在浏览器中对话。

地址:https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

安装上面的page Assist浏览器插件

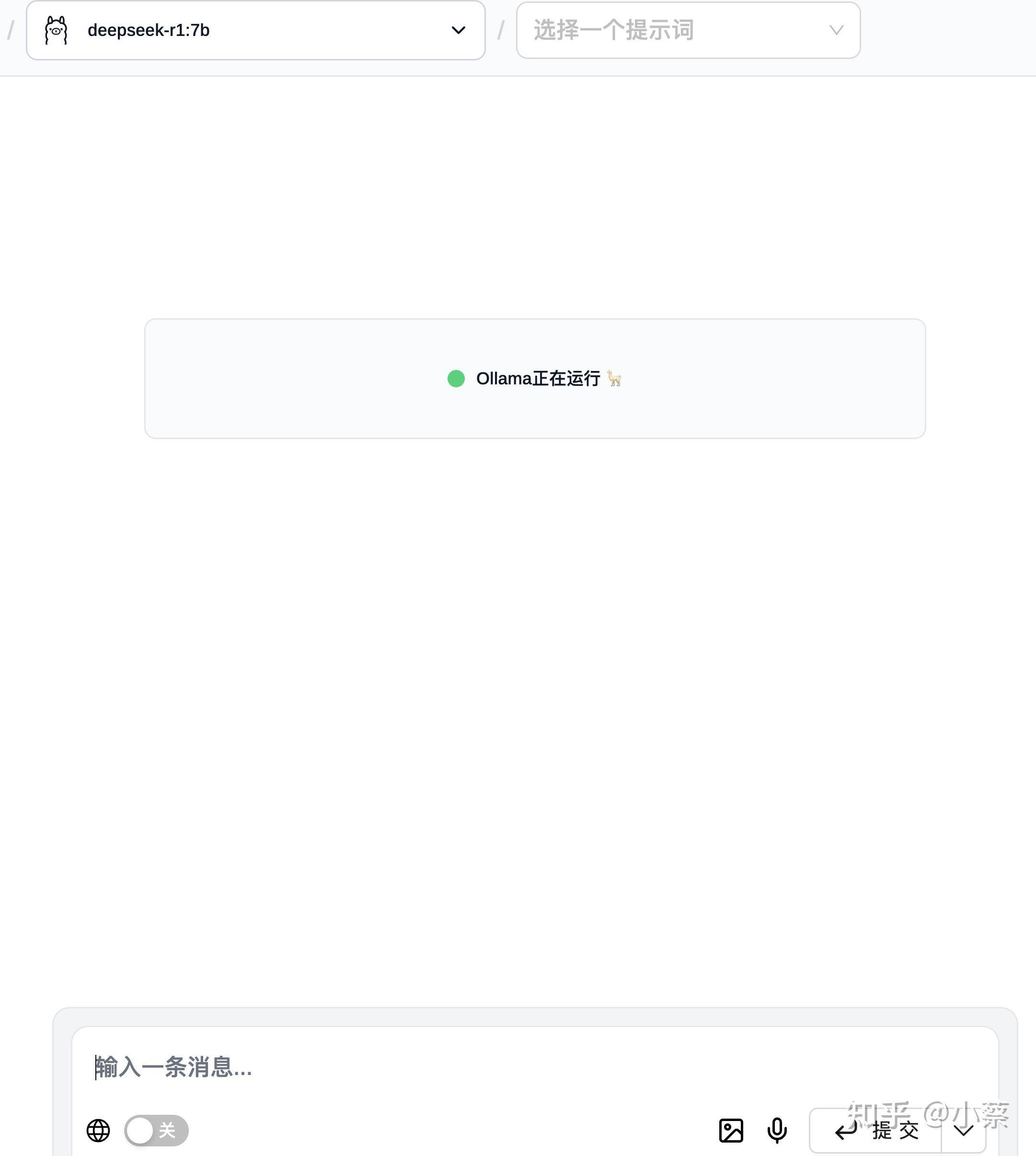

安装完成后打开插件,可以看到界面如下,说明我们的本地模型已经在运行啦

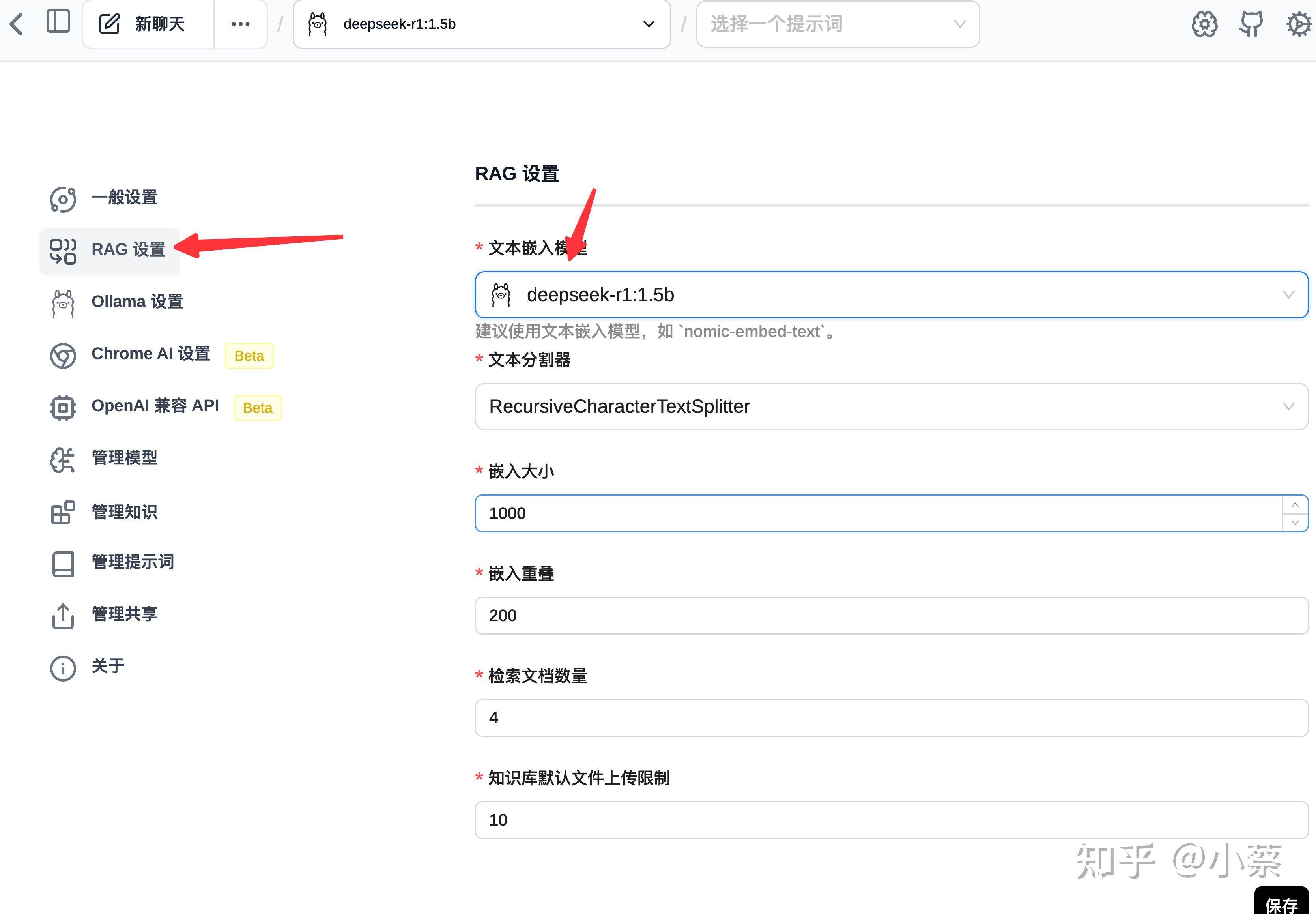

但还不能直接用,还需要进行一些配置

在对应配置中选择 DeepSeek 模型即可!

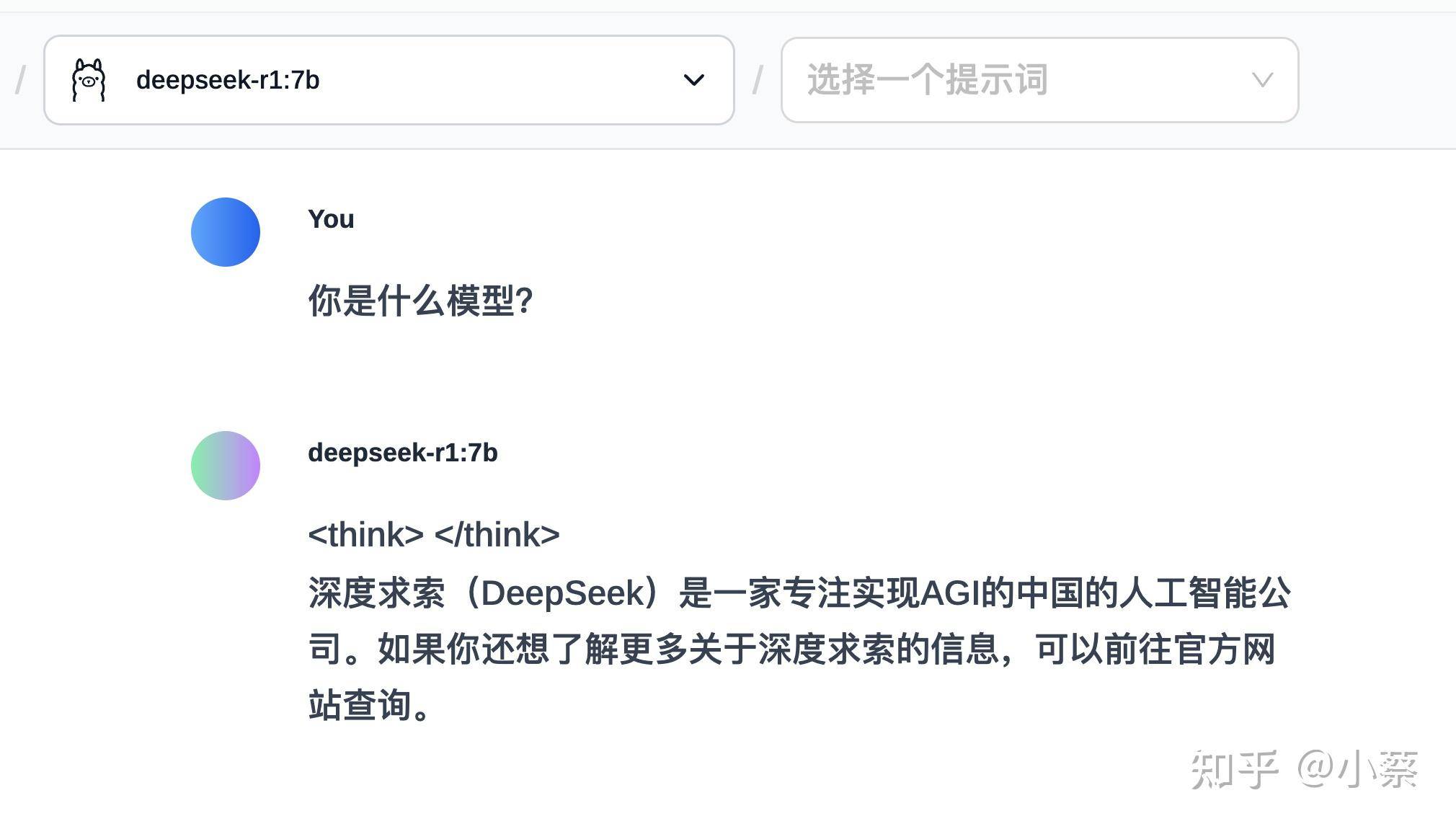

接下来就可以愉快的对话啦!

写在最后

当我在本地跑起R1时,突然悟了:这哪是什么AI崩溃?分明是全民AI觉醒的前奏!

正如《黑神话》团队说的:"总要有人走通这条取经路"。

那些抢不到服务器的夜晚,何不自己造个AI花果山?

我是小蔡,字节跳动 AI 工程师,专注于 AI 工具、编程、智能体

关注我,让我们一起在AI时代前行。