如何在本地部署DeepSeek-R1模型?

注意,ollama上的版本7b 14b的什么的不是原版R1,原版R1没有这么小的版本,这几个都是对应的Qwen和llama的蒸馏版本,不算是正经R1。

个人用户本地部署原版R1不太可能。这玩意光模型688G,没有GPU集群根本不用想。

https://huggingface.co/deepseek-ai/DeepSeek-R1/tree/main

即使是量化版本,最极端的Q1量化,也要94G:

https://huggingface.co/bartowski/DeepSeek-R1-GGUF/tree/main/DeepSeek-R1-IQ1_S

也不是普通玩家能玩的东西,但是如果你有两张A100 80G,可以试试。

但是Q1应该已经劣化成傻子了,比较能接受的是Q4的版本,大概360G:

https://huggingface.co/bartowski/DeepSeek-R1-GGUF/tree/main/DeepSeek-R1-IQ4_XS

如果你有5张 A100 80G应该可以试试。这个效果估计跟Deepseek网站上的就类似了。

所以普通用户,只能试试蒸馏的量化版本,感受下意思得了,比如这个R1蒸馏Qwen 2.5 14b的IQ4_NL版本:

https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-14B-GGUF/blob/main/DeepSeek-R1-Distill-Qwen-14B-IQ4_NL.gguf

10G显存就能跑跑。

如果你有16G显存,可以试试蒸馏的Qwen 2.5 32b的版本,IQ3_M量化,实测损失有点严重,Q4以下量化其实都不太推荐:

https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-32B-GGUF/blob/main/DeepSeek-R1-Distill-Qwen-32B-IQ3_M.gguf

32B的蒸馏版本还是推荐至少有24G显存,上至少Q4的量化版本:

https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-32B-GGUF/blob/main/DeepSeek-R1-Distill-Qwen-32B-Q4_1.gguf

注意,ollama上的版本7b 14b的什么的不是原版R1,原版R1没有这么小的版本,这几个都是对应的Qwen的蒸馏版本,不算是正经R1。

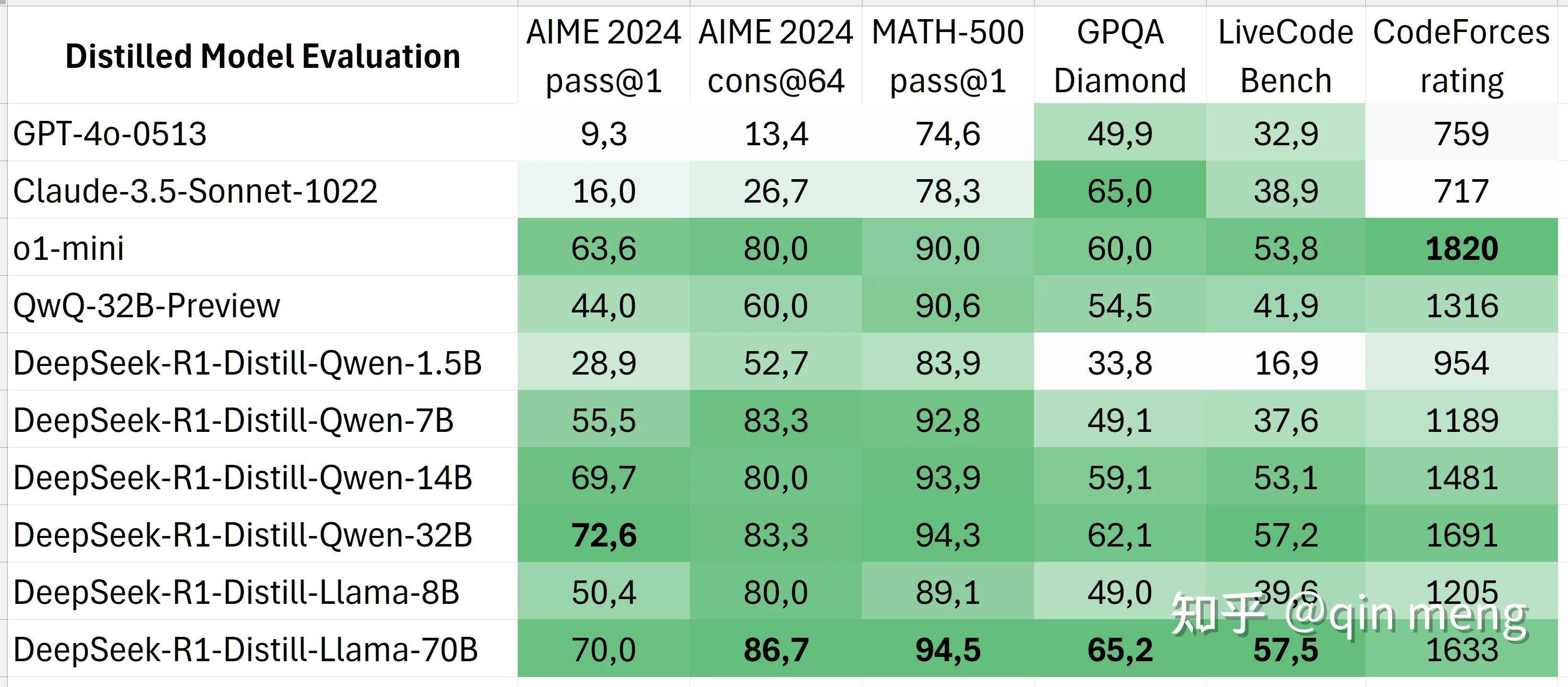

当然,蒸馏版本也挺能打的:

没有o1和R1那么强,但是比个gpt4o还是绰绰有余。尤其蒸馏的7B现在已经可以在手机上跑了。

一个比gpt4o还强的模型,能在手机上本地跑,都不说一年前,放一个月前,你敢想么?

其实,这个也不太意外,Cot模型的发展速度真挺快,其实之前就有Open O1这个项目,项目目的就是要复现OpenAI的o1。他选择的微软的rStar算法,这就是一个Cot模式蒸馏小模型的方法,蒸馏的llama7b就有很高的能力了。

Mutual Reasoning Makes Smaller LLMs Stronger Problem-Solvers

Deepseek直接开大,R1蒸馏Qwen,干的gpt4o跟SZ一样。Deepseek太TM给力,请继续。

另,个人小白安装步骤,用的R1蒸馏Qwen 14b,不是正经R1,10G显存,感受一下吧:

ollama标配前端是open-webui,装个python 12.8,记得勾上pip工具,把path加好。

打开一个cmd命令行,然后直接:

pip install open-webui

安装好后直接:

open-webui serve

ollama自己装吧,下一步点点就可以了。

装好后,命令行输入:

ollama run deepseek-r1:14b-qwen-distill-q4_K_M

等着,网络不好下载要很久(这是一个R1蒸馏Qwen 14b的q4版本,大概需要至少10G显存),出现>>>代表下载完成了,这时候你可以问他几个问题。然后ctrl-d退出。

确认open-webui在命令行里面运行着,ollama小山羊图标也在系统右下角。

打开浏览器,输入http://127.0.0.1:8080,第一次需要注册管理员用户,注册好后登录,你就能看到类似chatGPT的界面了,还有刚才你下载的deepseek-r1:14b-qwen-distill-q4_K_M,可以开始对话了。